Trong bối cảnh đào tạo mô hình AI, "định luật mở rộng quy mô" mô tả hiệu suất của mô hình lệ thuộc vào ba yếu tố chính: kích thước mô hình (số lượng tham số), thời gian đào tạo và lượng dữ liệu được sử dụng để đào tạo. Ba yếu tố này quyết định khối lượng điện toán được sử dụng trong quá trình đào tạo, và định luật mở rộng quy mô được sử dụng để phân bổ một lượng điện toán cố định giữa các yếu tố này nhằm tạo ra mô hình có năng lực cao nhất.

Định luật mở rộng quy mô được sử dụng để quyết định các lựa chọn đánh đổi như: Tôi có nên trả tiền cho Stack Overflow để đào tạo trên dữ liệu của họ không? Hay tôi nên mua thêm GPU? Hay tôi nên trả hóa đơn điện cao hơn do đào tạo mô hình của mình lâu hơn? Nếu khả năng điện toán của tôi tăng gấp 10 lần, tôi nên thêm bao nhiêu tham số vào mô hình của mình để sử dụng GPU một cách hiệu quả nhất?

Trong trường hợp của các mô hình tiên tiến như GPT-4, những sự đánh đổi này có thể giống như đào tạo một mô hình 20 tỷ tham số trên 40% dữ liệu của Internet, đào tạo một mô hình 200 tỷ tham số trên 4% dữ liệu của Internet, hoặc bất kỳ chiến lược nào giữa hai chiến lược này.

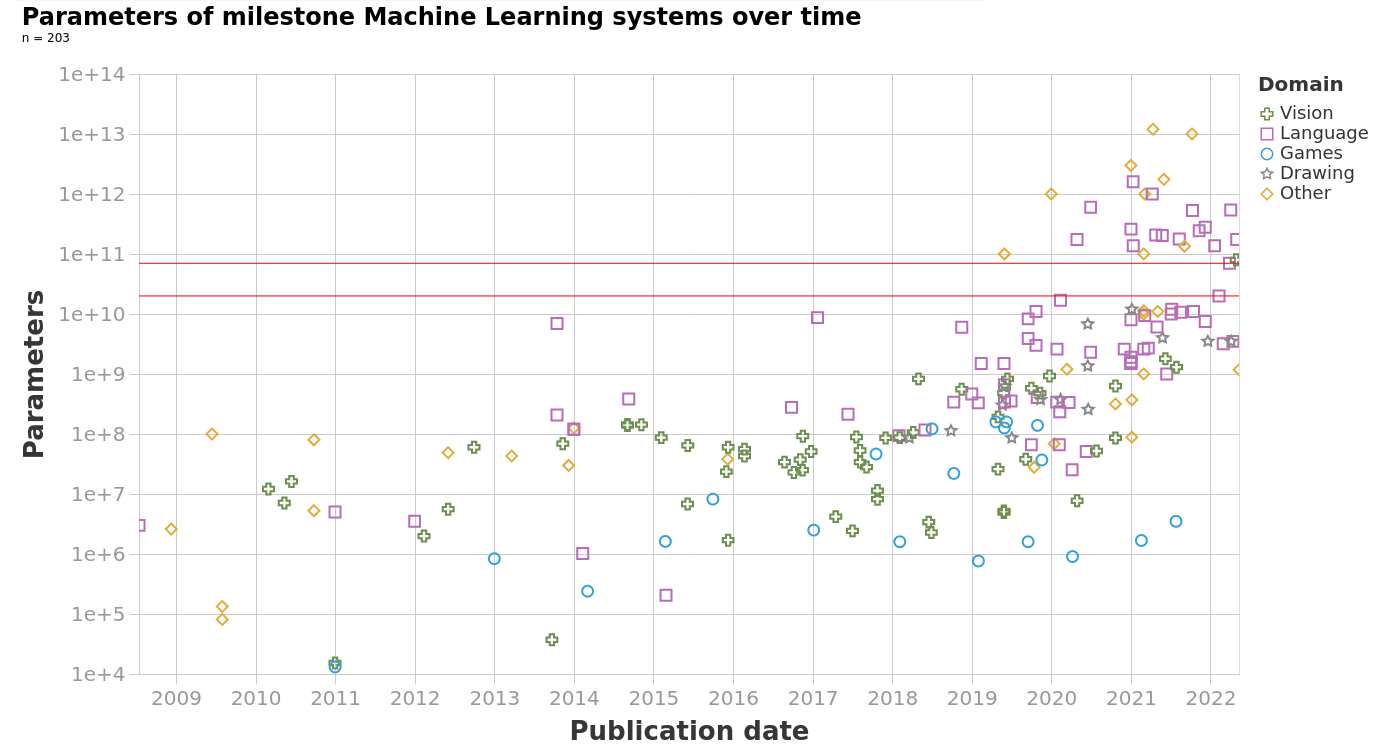

Vào năm 2020, OpenAI đã đề xuất các định luật mở rộng quy mô đầu tiên, dựa trên phát hiện rằng, ít nhất là đối với các mô hình lớn nhất tại thời điểm đó, tăng kích thước mô hình hiệu quả hơn việc sử dụng nhiều dữ liệu hơn. Các nghiên cứu sau đó đã chấp nhận rộng rãi giả thuyết này — trong bảng dưới đây, hãy lưu ý sự gia tăng tốc độ tăng trưởng tham số mô hình, trong khi lượng dữ liệu đào tạo được sử dụng tương đối nhất quán.

Các nhà nghiên cứu của DeepMind đã đề xuất các định luật mở rộng quy mô mới vào năm 2022. Họ phát hiện ra rằng việc tăng kích thước mô hình và kích thước tập dữ liệu với tỷ lệ gần như nhau sẽ sử dụng khả năng điện toán hiệu quả hơn so với việc chủ yếu tăng kích thước mô hình. Để thử nghiệm định luật mở rộng quy mô mới, DeepMind đã huấn luyện một mô hình 70 tỷ tham số có tên "Chinchilla" bằng cách sử dụng cùng khả năng điện toán như mô hình Gopher 280 tỷ tham số. Kích thước nhỏ hơn của Chinchilla cho phép DeepMind phân bổ lại khả năng điện toán để huấn luyện mô hình trên một tập dữ liệu lớn hơn nhiều (1,4 nghìn tỷ mã thông báo so với 300 tỷ của Gopher). Như định luật mở rộng quy mô mới dự đoán, Chinchilla hoạt động hiệu quả vượt trội hơn Gopher.