(Bài dịch vẫn đang trong quá trình hoàn thiện. Mọi góp ý đều được chào đón tại team@antoan.ai)

Kể từ các cuộc tấn công vào Hiroshima và Nagasaki, nhân loại chưa từng tiến hành bất kỳ cuộc tấn công hạt nhân nào nữa. Một phần là do các tổ chức của chúng ta đã xây dựng các chuẩn mực quốc tế, dù chưa hoàn hảo, nhưng đã ngăn chặn được các cuộc tấn công hạt nhân tiếp theo.

Chúng ta kỳ vọng AI tiên tiến sẽ đẩy nhanh tiến bộ công nghệ, với một số người dự đoán một thế kỷ tiến bộ khoa học sẽ diễn ra trong một thập kỷ. Tiến bộ khoa học nhanh hơn có thể mang lại những lợi ích to lớn, từ việc chữa trị các bệnh chết người đến khám phá không gian.

Tuy nhiên, tốc độ phát triển chóng mặt này có thể làm giảm rào cản trong việc tạo ra các loại vũ khí mới có sức hủy diệt khủng khiếp, đồng thời vượt xa khả năng của chúng ta trong việc xây dựng các biện pháp bảo vệ cần thiết để kiểm soát chúng.

Nếu không có các biện pháp kiểm soát thích hợp, một quốc gia, một nhóm hoặc một cá nhân có thể sử dụng vũ khí hủy diệt hàng loạt do AI tạo ra để gây ra thảm họa toàn cầu.

Các hệ thống AI tiên tiến có thể đẩy nhanh tiến bộ khoa học một cách đáng kể, có khả năng rút ngắn hàng thập kỷ nghiên cứu chỉ còn vài năm. Sự tiến bộ nhanh chóng này có thể dẫn đến việc phát triển các loại vũ khí hủy diệt hàng loạt mới có sức tàn phá khủng khiếp — bao gồm vũ khí sinh học cải tiến và các loại công nghệ nguy hiểm hoàn toàn mới — nhanh hơn chúng ta có thể xây dựng các biện pháp bảo vệ thích hợp.

Nếu không có các biện pháp kiểm soát thích hợp, các cá nhân thuộc nhà nước và phi nhà nước có thể sử dụng vũ khí phát triển từ AI để gây ra thảm họa toàn cầu hoặc tuyệt chủng loài người. Tuy nhiên, những rủi ro này có thể được giảm thiểu thông qua các phương pháp quản trị và biện pháp bảo vệ kỹ thuật.

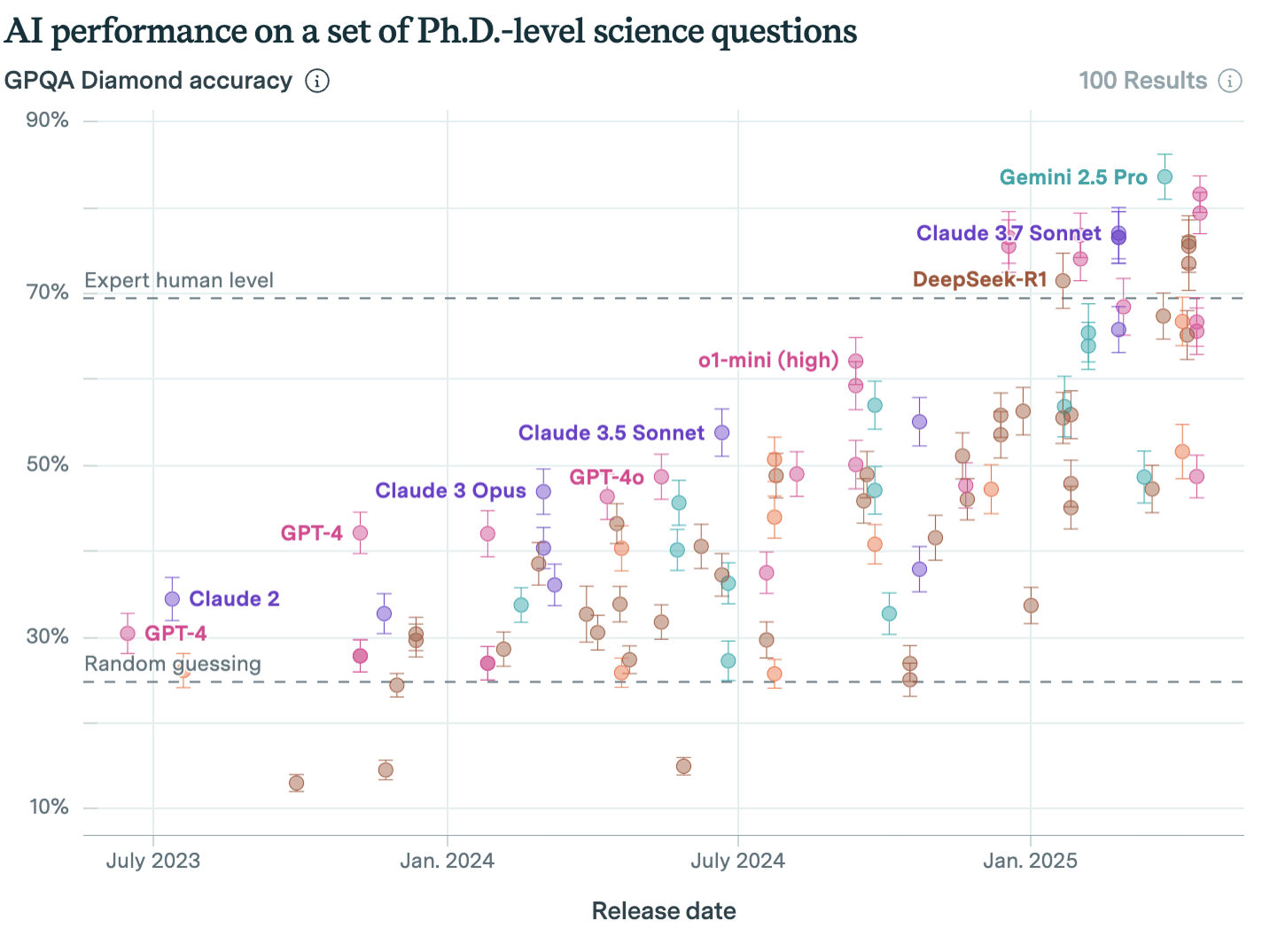

Các mô hình AI đã hoạt động hiệu quả trong các bài kiểm tra về lý luận khoa học tiên tiến.

Ví dụ, bài kiểm tra GPQA Diamond bao gồm các câu hỏi khoa học cấp tiến sĩ mà ngay cả những người không có chuyên môn cũng không thể trả lời, ngay cả khi sử dụng Google. Một số mô hình AI được phát triển gần đây đã vượt qua cả các chuyên gia:

Các hệ thống AI đã tạo ra những bước tiến lớn trong thế giới học thuật. Hệ thống AI AlphaFold của Google đã mang về giải Nobel cho các nhà sáng tạo nhờ những tiến bộ trong lĩnh vực khoa học cực kỳ phức tạp là gấp protein.

Hiện nay, các hệ thống AI vẫn chưa thể hoàn toàn tự thực hiện các nghiên cứu khoa học mà vẫn cần sự chỉ đạo của con người. Tuy nhiên, các công cụ chuyên dụng như AlphaFold cho thấy AI có thể thúc đẩy tiến bộ trong các lĩnh vực mục tiêu, thậm chí giúp giải quyết những vấn đề mà con người đã nỗ lực hàng thập kỷ mà vẫn chưa thể giải quyết. Điều này bao gồm cả những lĩnh vực có ứng dụng tiềm ẩn nguy hiểm.

Nhiều lĩnh vực nghiên cứu — như toán học, di truyền học, vật lý lượng tử và thiết kế thuật toán — đã chín muồi để khám phá một cách có hệ thống và quy mô lớn. Trong các lĩnh vực này, AI có thể nhanh chóng tạo ra và kiểm tra các giả thuyết, đẩy nhanh những đột phá mà con người có thể mất nhiều năm hoặc nhiều thập kỷ để đạt được.

Các hệ thống AI tiên tiến trong tương lai có thể tạo ra những khám phá thực sự theo yêu cầu, đánh dấu một sự thay đổi lớn trong cách chúng ta tạo ra kiến thức và tiến hành khoa học.

Các công ty AI đang tích cực phát triển các hệ thống AI có thể hoạt động với sự giám sát tối thiểu của con người. Nếu các hệ thống này có khả năng tiến hành nghiên cứu AI một cách độc lập, chúng có thể đẩy nhanh tiến độ phát triển AI một cách đáng kể — có khả năng đẩy nhanh sự xuất hiện của trí tuệ nhân tạo tổng quát (AGI): các hệ thống có hiệu suất ngang bằng hoặc vượt trội so với con người trong hầu hết các nhiệm vụ. Các hệ thống như vậy cuối cùng có thể tiến hành nghiên cứu khoa học một cách tự động, loại bỏ con người khỏi vòng lặp.

Chúng tôi đã lập luận ở nơi khác rằng AGI có thể xuất hiện sớm hơn nhiều so với dự đoán của nhiều người.

Vì vậy, chúng ta có thể sớm sống trong một thế giới nơi các hệ thống AGI có thể tiến hành nghiên cứu khoa học gia nhập lực lượng lao động, mở rộng đáng kể nỗ lực đẩy mạnh ranh giới công nghệ. Nhưng ngay cả khi mất nhiều thời gian hơn, một khi AGI xuất hiện, nó có thể cách mạng hóa quá trình nghiên cứu khoa học.

Điều này có thể giúp con người giải quyết nhiều vấn đề lớn, như dịch bệnh và biến đổi khí hậu. Tuy nhiên, khoa học cũng đã giúp nhân loại tạo ra các vũ khí hủy diệt hàng loạt: hóa học, sinh học và hạt nhân.

Trong thế kỷ qua, chúng ta đã xây dựng luật pháp quốc tế và các quy tắc ngoại giao xung quanh các loại vũ khí này, hạn chế việc sử dụng chúng. Nếu AI cho phép chúng ta phát triển các vũ khí hủy diệt hàng loạt nhanh hơn nữa, các thể chế của chúng ta có thể không theo kịp.

Loại công nghệ hủy diệt mới mà chúng tôi lo ngại nhất là vũ khí sinh học. Ngay cả khi không có AI, công nghệ sinh học tiên tiến cũng tiềm ẩn rủi ro cực cao. Khả năng lây nhiễm, nhân lên, giết chết và lây lan của các mầm bệnh — thường không thể phát hiện — khiến chúng trở nên cực kỳ nguy hiểm. Các đại dịch do công nghệ sinh học tạo ra có thể lây lan và gây tử vong nhanh hơn nhiều so với các đại dịch tự nhiên, vốn là một trong những sự kiện chết chóc nhất trong lịch sử loài người.

Chúng tôi cho rằng AI có thể thúc đẩy nghiên cứu công nghệ sinh học phát triển nhanh chóng. Giám đốc điều hành của Anthropic, Dario Amodei, đã viết:

…dự đoán cơ bản của tôi là sinh học và y học dựa trên AI sẽ cho phép chúng ta nén tiến bộ mà các nhà sinh vật học con người có thể đạt được trong 50-100 năm tới vào 5-10 năm. Tôi sẽ gọi đây là "thế kỷ 21 được nén": ý tưởng rằng sau khi AI mạnh mẽ được phát triển, chúng ta sẽ đạt được tất cả tiến bộ trong sinh học và y học mà chúng ta có thể đạt được trong cả thế kỷ 21 chỉ trong vài năm.

Tuy nhiên, khi AI đẩy nhanh tốc độ nghiên cứu sinh học và y học, nó cũng sẽ làm gia tăng các rủi ro mới. Các công cụ lưỡng dụng, như tự động hóa quy trình phòng thí nghiệm, có thể làm giảm rào cản cho các cá nhân xấu cố gắng sản xuất virus đại dịch nguy hiểm.

Ngay cả các mô hình ngôn ngữ lớn hiện nay về mặt lý thuyết cũng có thể được sử dụng để học cách chế tạo vũ khí sinh học. Một nghiên cứu cho thấy một số hệ thống AI tiên tiến vượt trội hơn các nhà virus học con người trong Bài kiểm tra Năng lực Virus học — cho thấy chúng có thể hỗ trợ những người mới bắt đầu thực hiện các thí nghiệm sinh học nguy hiểm.1

Khi AI trở nên mạnh mẽ và tự chủ hơn, phạm vi cách thức chúng có thể giúp chế tạo vũ khí sinh học sẽ mở rộng. Ví dụ, các công cụ thiết kế sinh học dựa trên AI có thể cho phép các cá nhân tinh vi tái lập trình gen của các mầm bệnh nguy hiểm để tăng cường tính gây chết người, khả năng lây truyền và khả năng tránh né hệ miễn dịch.2

Nếu AI có thể thúc đẩy tốc độ tiến bộ khoa học và công nghệ, những rủi ro này có thể bị khuếch đại và gia tăng — khiến công nghệ nguy hiểm trở nên phổ biến hơn hoặc tăng sức tàn phá của nó.3

Trong một cuộc khảo sát năm 2023 với các chuyên gia AI, 73% số người được hỏi cho biết họ có lo ngại “cực kỳ” hoặc “rất lớn” rằng trong tương lai AI sẽ cho phép “các nhóm nguy hiểm tạo ra các công cụ mạnh mẽ (ví dụ: virus nhân tạo)”.4

AI đã có thể được sử dụng trong các cuộc tấn công mạng, chẳng hạn như lừa đảo, và AI mạnh mẽ hơn có thể gây ra những thách thức lớn hơn về an ninh thông tin (mặc dù nó cũng có thể hữu ích trong phòng thủ mạng).

Bản thân chiến tranh mạng dựa trên AI không có khả năng gây ra mối đe dọa hiện sinh cho loài người. Ngay cả những cuộc tấn công mạng quy mô xã hội gây thiệt hại và tốn kém nhất cũng không thể dẫn đến sự tuyệt chủng của loài người.

Tuy nhiên, các cuộc tấn công mạng sử dụng AI có thể cung cấp quyền truy cập vào các công nghệ nguy hiểm khác, như vũ khí sinh học, kho vũ khí hạt nhân hoặc vũ khí tự động. Vì vậy, vũ khí mạng liên quan đến AI có thể gây ra những rủi ro hiện sinh thực sự, nhưng rất có thể chúng sẽ phải đối mặt với một rủi ro hiện sinh khác. Ví dụ, một cuộc tấn công mạng sử dụng AI có thể kích hoạt việc phóng vũ khí hạt nhân hoặc cho phép một nhóm ác ý truy cập thông tin cần thiết để phát triển vũ khí sinh học.

Chúng ta có thể không thể dự đoán được những công nghệ mới nguy hiểm nào mà trí tuệ nhân tạo (AI) có thể giúp con người tạo ra. Lưu ý rằng vũ khí hạt nhân lần đầu tiên được đề xuất chỉ 12 năm trước khi bom nguyên tử được thả xuống Hiroshima và Nagasaki.

Với lưu ý đó, chúng ta vẫn có thể suy đoán về một số công nghệ mới tiềm năng. Một khả năng là chế tạo chính xác bậc nguyên tử, đôi khi được gọi là công nghệ nano, đã được giả thuyết là một mối đe dọa hiện sinh — và đây là một công nghệ khả thi về mặt khoa học mà AI có thể giúp chúng ta phát minh ra sớm hơn nhiều so với bình thường.

Trong cuốn The Precipice, Toby Ord ước tính khả năng xảy ra thảm họa hiện sinh vào năm 2120 do “rủi ro hiện sinh do con người gây ra” là 1/30. Ước tính này cho thấy có thể có những phát hiện khác, có thể liên quan đến vật lý chưa được hiểu rõ, có thể cho phép tạo ra các công nghệ có hậu quả thảm khốc.

Để có một gợi ý về điều này có thể trông như thế nào, hãy xem xét những lo ngại nảy sinh trong quá trình xây dựng Máy gia tốc hạt lớn (Large Hadron Collider).

Một nhóm nhà nghiên cứu đã họp để tìm hiểu liệu va chạm giữa các ion nặng có thể tạo ra các hạt strangelet mang điện tích âm và lỗ đen — có thể đe dọa toàn bộ hành tinh. Họ kết luận rằng "không có cơ sở cho bất kỳ mối đe dọa nào có thể tưởng tượng được" — nhưng có thể họ đã phát hiện ra điều khác, và có thể các thí nghiệm vật lý trong tương lai có thể gây ra rủi ro cực kỳ nghiêm trọng.

Một ví dụ liên quan là rủi ro được các nhà nghiên cứu tại Los Alamos xem xét vào năm 1942 rằng vụ thử nghiệm vũ khí hạt nhân đầu tiên có thể đốt cháy toàn bộ khí quyển Trái Đất trong một phản ứng dây chuyền không thể ngăn chặn.

Các loại vũ khí này có thể làm tăng rủi ro thảm họa toàn cầu theo hai cách:

Trong một bài viết riêng, chúng tôi ước tính rằng có 1/3 khả năng xảy ra chiến tranh giữa các cường quốc trước năm 2050. Nếu các quốc gia có quyền sử dụng vũ khí hủy diệt hàng loạt mới, một cuộc chiến tranh như vậy có nhiều khả năng dẫn đến sự tuyệt chủng của loài người.

Ngoài vũ khí hạt nhân, chúng ta đã thấy các chính phủ phát triển các chương trình vũ khí hủy diệt hàng loạt trong quá khứ. Ví dụ:

Vì vậy, có tiền lệ lịch sử cho loại mối đe dọa này.

Chúng tôi cho rằng các quốc gia bất hảo hoặc cá nhân khủng bố khó có khả năng tiếp cận AI có thể tạo ra vũ khí hủy diệt hàng loạt mới. Hiện tại, AI có khả năng cao sẽ được kiểm soát bởi các công ty lớn và chính phủ như Mỹ và Trung Quốc. Tuy nhiên, các quốc gia bất hảo hoặc nhóm khủng bố có thể phá vỡ các biện pháp bảo mật trên các mô hình AI hiện có,5đánh cắp mô hình và sử dụng chúng cho mục đích khác, hoặc lợi dụng các mô hình mở.

Một báo cáo của Viện Nghiên cứu Hòa bình Quốc tế Stockholm cho thấy tác động gây mất ổn định của cuộc chạy đua vũ trang có thể xuất hiện ngay cả trước khi những tiến bộ trong AI được triển khai. Điều này là do niềm tin của một quốc gia rằng đối thủ của họ có năng lực hạt nhân mới có thể đủ để phá vỡ sự cân bằng răn đe mong manh. Động lực tương tự có thể áp dụng cho các vũ khí hủy diệt hàng loạt mới khác, như vũ khí sinh học.

May mắn thay, cũng có những cách khả thi để AI có thể giúp ngăn chặn việc sử dụng vũ khí hạt nhân và các vũ khí hủy diệt hàng loạt khác — có thể bằng cách cải thiện khả năng phát hiện phóng tên lửa hạt nhân của các quốc gia, từ đó giảm khả năng xảy ra báo động sai như vụ suýt gây ra chiến tranh hạt nhân vào năm 1983. AI cũng có thể có tác dụng ổn định: ví dụ, nó có thể tăng khả năng phối hợp và tạo ra các thỏa thuận có thể kiểm chứng của loài người.

Nhìn chung, chúng tôi không chắc liệu AI có làm tăng đáng kể rủi ro xung đột hạt nhân hoặc xung đột thông thường trong ngắn hạn hay không, nhưng chúng tôi cho rằng cần phải nỗ lực hơn nữa để giảm thiểu rủi ro tiêu cực.

Mặc dù AI tiên tiến có thể đẩy nhanh sự phát triển của các loại vũ khí nguy hiểm, nhưng chúng ta có thể thực hiện các bước cụ thể để giảm thiểu những rủi ro lợi dụng sai mục đích gây thảm họa này. Công việc trong lĩnh vực này thường được chia thành hai loại: cách tiếp cận quản trị và biện pháp bảo vệ kỹ thuật.

Một số phương pháp trong công việc này bao gồm:

Để biết thêm thông tin, quý vị có thể đọc bài đánh giá nghề nghiệp đầy đủ của chúng tôi về quản trị và chính sách AI.

Một số phương pháp trong công việc này bao gồm:

Để biết thêm thông tin, quý vị có thể đọc bài đánh giá toàn diện về nghiên cứu kỹ thuật an toàn AI của chúng tôi.

Lĩnh vực chính sách và an toàn AI vẫn đang phát triển nhanh chóng, và còn nhiều không gian cho những ý tưởng và cách tiếp cận mới. Các ý tưởng hiện tại có thể có những nhược điểm quan trọng, như những ý tưởng được liệt kê ở trên, cần được phân tích và xem xét kỹ lưỡng hơn. Nhiều giải pháp trong số này sẽ đòi hỏi sự phối hợp giữa nhiều bên liên quan, bao gồm các nhà công nghệ, nhà hoạch định chính sách và các cơ quan quốc tế.

Điều quan trọng là, giảm rủi ro lợi dụng sai mục đích không nhất thiết phải ngừng phát triển AI hoàn toàn — thay vào đó, cần đảm bảo các biện pháp bảo vệ đi đôi với năng lực. Giống như chúng ta đã học cách khai thác công nghệ hạt nhân cho các mục đích có lợi trong khi hạn chế sự phổ biến vũ khí, chúng ta có thể làm điều tương tự với AI.

Cơ hội để thực hiện các biện pháp can thiệp này có thể hạn chế. Khi năng lực AI phát triển nhanh chóng, các cá nhân chủ chốt sẽ cần hành động nhanh chóng để thiết lập các biện pháp bảo vệ, thực tiễn và khung quản trị hiệu quả nhằm tránh việc lợi dụng sai mục đích các hệ thống này gây ra thảm họa.