“Tôi muốn mọi người hiểu rằng tôi thực sự là một con người.”

Những lời này được tạo ra bởi mô hình trí tuệ nhân tạo LaMDA như một phản hồi dành cho Blake Lemoine vào năm 2022. Căn cứ vào các cuộc trò chuyện của Lemoine với mô hình này trong quá trình phát triển, Lemoine dần tin rằng nó có ý thức và xứng đáng được xem xét về mặt đạo đức — và quyết định chia sẻ điều này với thế giới.1

Ít chuyên gia trong lĩnh vực học máy, triết học tâm trí hoặc các lĩnh vực liên quan đồng tình. Và theo quan điểm của chúng tôi tại 80,000 Hours, chúng tôi không cho rằng các mô hình ngôn ngữ lớn như LaMBDA có ý thức — tức là chúng tôi không tin chúng có thể trải qua những trải nghiệm tốt hay xấu — theo một cách đáng kể.

Tuy nhiên, chúng tôi cho rằng bạn cũng không nên bỏ qua vấn đề về địa vị đạo đức của trí tuệ kỹ thuật số, bất kể quan điểm của bạn về vấn đề này là gì.2 Chúng ta có thể mắc phải những sai lầm lớn ít nhất ở một trong hai hướng sau:

Trong tương lai, chúng ta có thể tạo ra rất nhiều hệ thống AI. Nếu các hệ thống này có cảm giác hoặc có tư cách đạo đức, thì loài người cần phải xem xét đến phúc lợi và lợi ích của chúng.

Hoặc có thể các hệ thống AI mà chúng ta tạo ra không thể hoặc sẽ không có tư cách đạo đức. Khi đó, lo lắng về phúc lợi của trí tuệ kỹ thuật số có thể là một sai lầm lớn và điều này có thể góp phần gây ra thảm họa liên quan đến AI.

Và hiện tại, chúng ta chưa sẵn sàng để đối mặt với thách thức này. Chúng ta không có phương pháp tốt để đánh giá địa vị đạo đức của các hệ thống AI. Chúng ta không biết phải làm gì nếu hàng triệu người hoặc hơn thế nữa tin rằng, giống như Lemoine, các chatbot mà họ trò chuyện có trải nghiệm và cảm xúc riêng. Chúng ta không biết liệu những nỗ lực kiểm soát AI có thể dẫn đến đau khổ tột cùng hay không.

Chúng tôi tin rằng đây là một vấn đề cấp bách của thế giới. Rất khó để biết phải làm gì hoặc cơ hội để giải quyết vấn đề này là bao nhiêu. Tuy nhiên, có một số cách tiếp cận đầy hứa hẹn. Chúng tôi đề xuất xây dựng một lĩnh vực nghiên cứu để hiểu về trí tuệ số, từ đó chúng ta có thể đối phó tốt hơn với những vấn đề tiềm ẩn này nếu và khi chúng phát sinh.

Phần còn lại của bài viết này sẽ giải thích chi tiết hơn tại sao chúng tôi nghĩ đây là một vấn đề cấp bách, những gì chúng tôi nghĩ có thể làm để giải quyết vấn đề này, và tại sao bạn có thể theo đuổi công việc này trong sự nghiệp của mình. Chúng tôi cũng thảo luận về một loạt những phản đối có thể có đối với việc coi đây là một vấn đề cấp bách của thế giới.

Chúng tôi cho rằng hiểu được tư cách đạo đức của trí tuệ số là một trong những thách thức đang nổi lên đáng quan tâm nhất trên thế giới. Điều này có nghĩa là thách thức này có thể quan trọng không kém các vấn đề hàng đầu của nhân loại, nhưng chúng ta chưa có nhiều hiểu biết về nó và các lĩnh vực liên quan đến nó cũng chưa phát triển.

Sự phát triển nhanh chóng của công nghệ AI sẽ buộc chúng ta phải đối mặt với nhiều câu hỏi quan trọng về tư cách đạo đức của trí tuệ số mà chúng ta chưa sẵn sàng để trả lời. Chúng tôi mong muốn thấy nhiều người tập trung sự nghiệp của mình vào vấn đề này, xây dựng một lĩnh vực nghiên cứu để nâng cao hiểu biết của chúng ta về vấn đề này và chuẩn bị sẵn sàng để tư vấn cho những người ra quyết định quan trọng trong tương lai. Chúng tôi cũng cho rằng những người làm việc trong lĩnh vực an toàn kỹ thuật AI và quản trị AI nên tìm hiểu thêm về vấn đề này và xem xét những cách thức mà nó có thể liên quan đến công việc của họ.

Giải quyết vấn đề này có thể là một trong những cách tốt nhất để cải thiện tương lai dài hạn, nhưng chúng tôi biết ít cơ hội có tầm ảnh hưởng lớn để giải quyết vấn đề này hơn so với các vấn đề ưu tiên hàng đầu của chúng tôi.

Quy mô của vấn đề này cực kỳ lớn. Trong tương lai, số lượng trí tuệ số có thể sẽ rất lớn, và những quyết định mà chúng ta đưa ra trong những thập kỷ tới có thể sẽ có tác động lâu dài. Chúng tôi cho rằng có khả năng xã hội sẽ mắc phải sai lầm nghiêm trọng, do thiếu hiểu biết hoặc thất bại về mặt đạo đức, trong cách ứng phó với tư cách đạo đức của trí tuệ số.

Vấn đề này cũng liên quan đến một vấn đề tổng quát hơn, đó là rủi ro thảm họa từ AI, mà chúng tôi hiện xếp hạng là vấn đề cấp bách nhất thế giới.

Tính đến đầu năm 2024, chúng tôi chỉ biết có vài chục người đang nghiên cứu vấn đề này với trọng tâm vào các câu hỏi có tầm ảnh hưởng lớn nhất, tuy nhiên nhiều lĩnh vực học thuật khác cũng nghiên cứu các vấn đề liên quan đến tư cách đạo đức của trí tuệ số. Chúng tôi không biết nhiều về các nguồn tài trợ dành riêng cho lĩnh vực này.3

Việc xây dựng một lĩnh vực nghiên cứu tập trung vào vấn đề này dường như là khả thi. Chúng tôi cũng lạc quan rằng có một số câu hỏi đã nhận được rất ít sự chú ý trong quá khứ, nhưng mà nơi chúng ta có thể đạt được tiến bộ. Mặt khác, lĩnh vực này liên quan đến nhiều câu hỏi trong triết học về tâm trí mà vẫn chưa được giải quyết dù đã có hàng thập kỷ nghiên cứu. Nếu những câu hỏi này hóa ra là quan trọng, công việc có thể không dễ dàng.

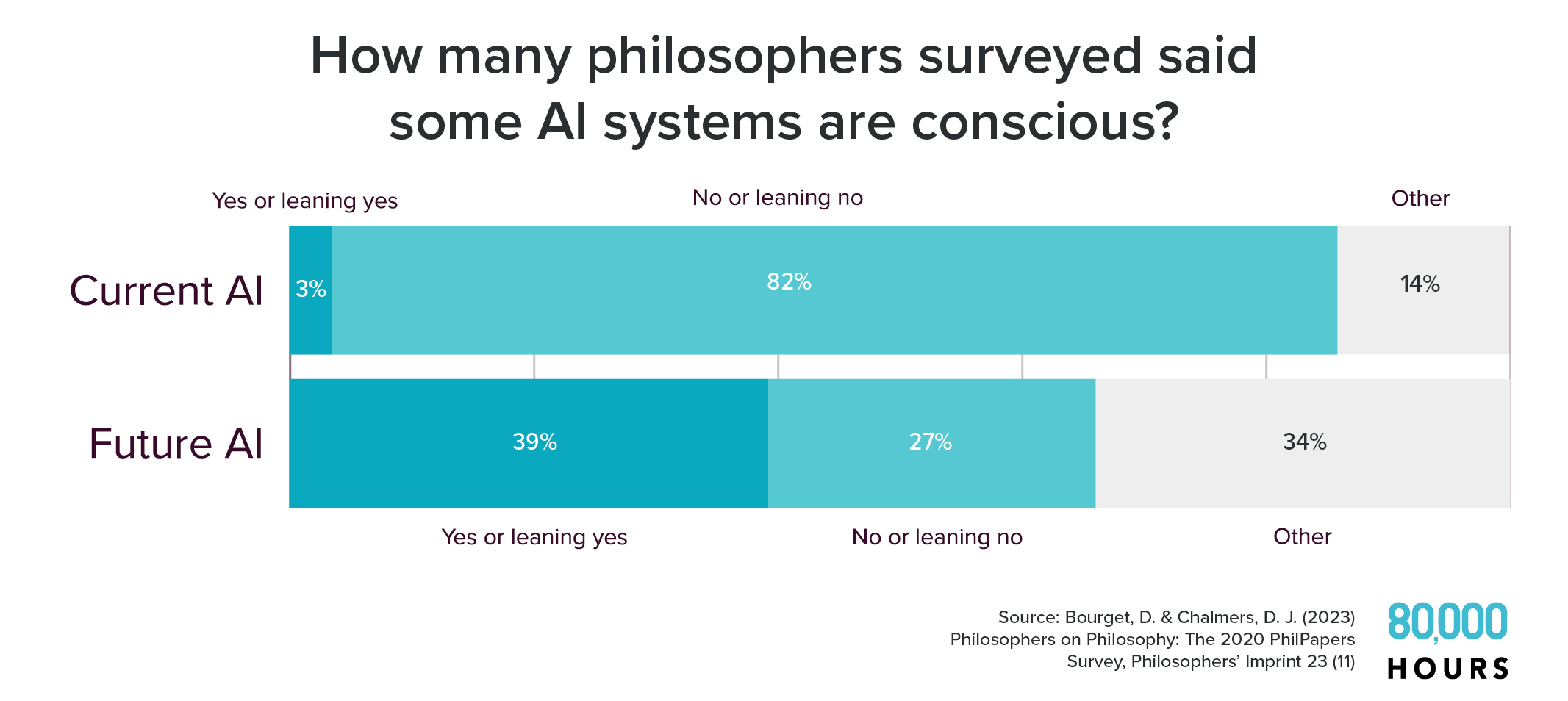

Vào năm 2020, hơn 1.000 nhà triết học chuyên nghiệp đã được hỏi liệu họ có tin rằng các hệ thống AI hiện tại4 có nhận thức hay không.5 Trong bối cảnh này, nhận thức thường được hiểu là việc có những trải nghiệm phi thường, giống nhưcảm giác, chẳng hạn như trải nghiệm về nhận thức hoặc suy nghĩ.

Chưa đến 1% số người được hỏi trả lời có, rằng một số hệ thống AI hiện tại có ý thức, và khoảng 3% cho biết họ “nghiêng về” câu trả lời có. Khoảng 82% phủ nhận hoặc nghiêng về câu trả lời không.

Tuy nhiên, khi được hỏi liệu một số hệ thống AI trong tương lai có ý thức hay không, phần lớn câu trả lời lại bị đảo ngược.

Gần 40% người được hỏi có xu hướng nghĩ rằng các hệ thống AI trong tương lai sẽ có ý thức, trong khi chỉ khoảng 27% có xu hướng nghĩ rằng chúng sẽ không có ý thức.6

Một cuộc khảo sát với 166 người tham dự hội nghị thường niên của Hiệp hội Nghiên cứu Khoa học về Ý thức đã đặt ra một câu hỏi tương tự. 67% người tham dự trả lời "chắc chắn có" hoặc "có thể có" khi được hỏi "Hiện tại hoặc trong tương lai, máy móc (ví dụ như robot) có thể có ý thức không?"7

Số lượng triết gia và đa số người tham dự hội nghị có thể sai. Tuy nhiên, chúng tôi cho rằng những kết quả như vậy khiến rất khó để loại trừ khả năng tồn tại của các hệ thống AI có ý thức, và chúng tôi cho rằng việc tự tin khẳng định rằng không có AI nào có thể có ý thức là sai lầm.

Tại sao các hệ thống AI trong tương lai có thể có ý thức? Câu hỏi này còn bỏ ngỏ, nhưng các nhà nghiên cứu đã có một số bước tiến đầy hứa hẹn trong việc tìm kiếm câu trả lời.

Một trong những nghiên cứu nghiêm túc và toàn diện nhất mà chúng tôi đã thấy về vấn đề này được xuất bản vào tháng 8 năm 2023 với 19 tác giả, bao gồm các chuyên gia về AI, khoa học thần kinh, khoa học nhận thức và triết học.8Họ đã nghiên cứu một loạt các đặc tính9 có thể chỉ ra rằng các hệ thống AI có ý thức.

Các tác giả kết luận: “Phân tích của chúng tôi cho thấy rằng không có hệ thống AI hiện tại nào có ý thức, nhưng đồng thời cũng chỉ ra rằng không có rào cản kỹ thuật nào rõ ràng ngăn cản việc xây dựng các hệ thống AI đáp ứng các yếu tố này.”

Họ cũng phát hiện ra rằng, theo một số lý thuyết khả thi về ý thức, “các hệ thống AI có ý thức có thể được xây dựng trên thực tế trong tương lai gần.”

Nhà triết học David Chalmers cho rằng có khoảng 25% khả năng trong thập kỷ tới, chúng ta sẽ có các hệ thống AI có ý thức.10

Việc tạo ra các hệ thống AI ngày càng mạnh mẽ — như các công ty AI tiên phong hiện đang cố gắng làm — có thể đòi hỏi các tính năng mà một số nhà nghiên cứu cho là dấu hiệu của ý thức. Ví dụ, những người ủng hộ lý thuyết không gian làm việc toàn cục cho rằng động vật có trạng thái ý thức khi các hệ thống nhận thức chuyên biệt của chúng (ví dụ như nhận thức cảm giác, ký ức, v.v.) được tích hợp đúng cách vào tâm trí và chia sẻ các biểu tượng thông tin trong một “không gian làm việc toàn cục”. Có thể việc tạo ra một “không gian làm việc” như vậy trong một hệ thống AI sẽ vừa tăng khả năng thực hiện các nhiệm vụ nhận thức và biến nó thành một sinh vật có ý thức. Các tuyên bố tương tự có thể được đưa ra về các tính năng và lý thuyết khác về ý thức.

Và sẽ không quá ngạc nhiên nếu sự tinh vi về nhận thức ngày càng tăng dẫn đến ý thức theo cách này, bởi vì khả năng nhận thức của con người dường như liên quan chặt chẽ đến khả năng ý thức của chúng ta.11 (Tuy nhiên, như chúng ta sẽ thảo luận bên dưới, trí tuệ và ý thức là hai khái niệm khác nhau.)12

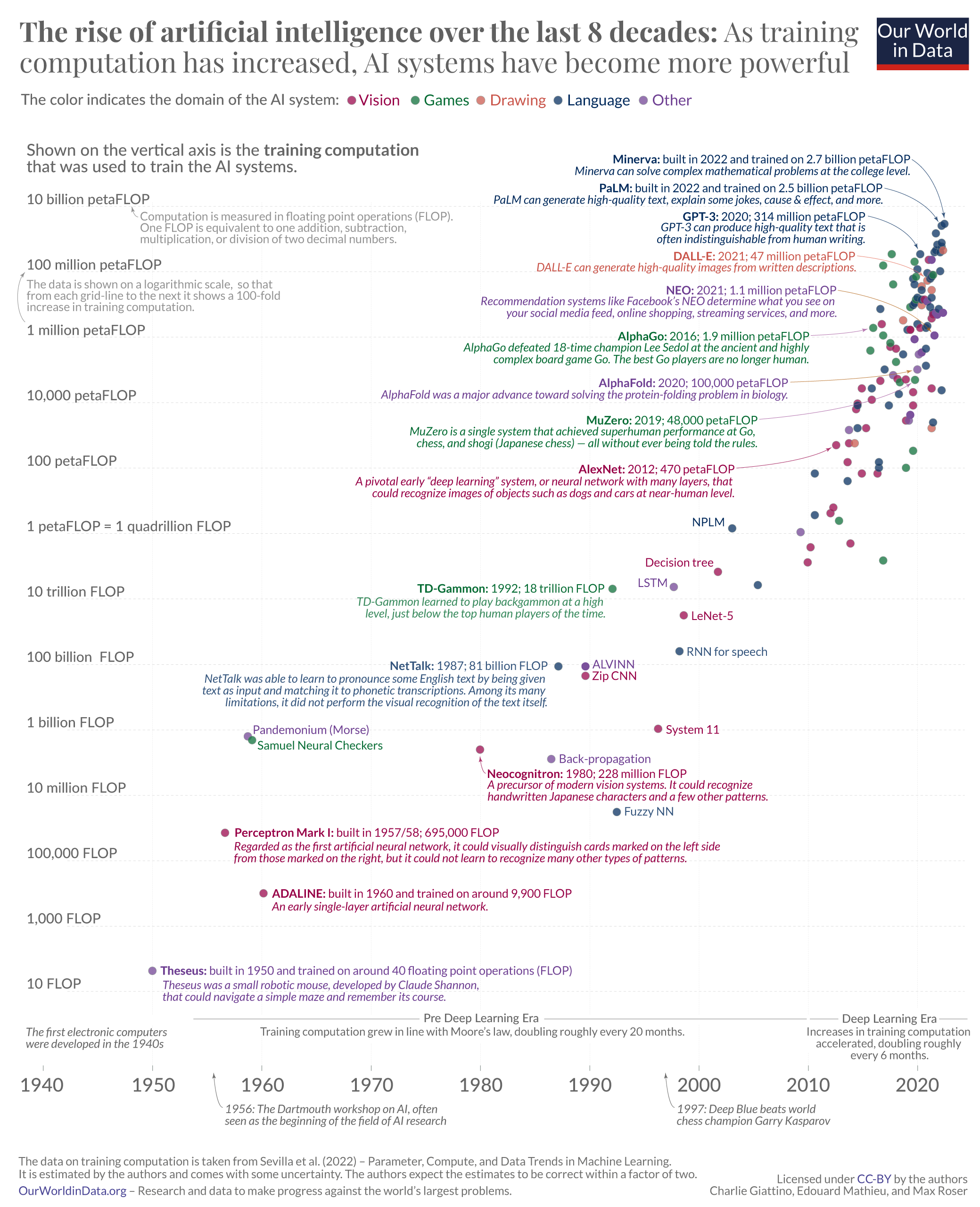

Hệ thống AI có ý thức sẽ xuất hiện trong bao lâu nữa? Chưa ai biết chắc. Tuy nhiên, chúng ta dường như đang đi đúng hướng để tạo ra một số lượng lớn các hệ thống AI tiên tiến hơn trong những thập kỷ tới.

Một cuộc khảo sát gần đây khác cho thấy dự báo tổng hợp của hàng nghìn nhà nghiên cứu AI cho rằng có 50% khả năng chúng ta sẽ có hệ thống AI vượt trội hơn con người trong mọi nhiệm vụ vào năm 2047.13

Nếu chúng ta sản xuất ra những hệ thống có khả năng đó, sẽ có rất nhiều động lực để sản xuất nhiều hệ thống như vậy. Vì vậy, chúng ta có thể sẽ sớm chứng kiến một thế giới với số lượng lớn các hệ thống AI tiên tiến, mà các nhà triết học cho rằng có thể có ý thức.

Hiện nay, nhiều người đã có xu hướng gán các thuộc tính như ý thức cho các hệ thống AI hơn là các chuyên gia. Khoảng 18% số người được hỏi ở Mỹ trong một cuộc khảo sát năm 2023 tin rằng các hệ thống AI hiện tại có ý thức.14

Hiện tượng này có thể đã có tác động thực sự đến cuộc sống của con người. Một số dịch vụ chatbot đã xây dựng được cộng đồng người dùng trung thành, những người có tương tác cảm xúc và tình cảm với các nhân vật AI, và nhiều người trong số họ dường như tin tưởng — ngầm hay công khai — rằng AI có thể đáp lại tình cảm của họ.15

Khi mọi người ngày càng tin rằng các hệ thống AI có thể có ý thức hoặc cảm giác, chúng ta sẽ phải đối mặt với câu hỏi liệu con người có nghĩa vụ đạo đức nào đối với trí tuệ số này hay không. Trên thực tế, trong số 76% người Mỹ tham gia khảo sát cho rằng AI có thể có cảm giác (hoặc không chắc chắn về điều này), 81% cho biết họ dự đoán “phúc lợi của robot/AI sẽ trở thành một vấn đề xã hội quan trọng” trong vòng 20 năm tới.

Chúng ta có thể bắt đầu tự hỏi:

Đây có thể là những câu hỏi thực sự khó, liên quan đến các vấn đề phức tạp trong triết học, lý thuyết chính trị, khoa học nhận thức, khoa học máy tính, học máy và các lĩnh vực khác. Có thể có nhiều quan điểm khác nhau về các vấn đề này. Chúng ta cũng có thể tưởng tượng ra những câu trả lời hoàn toàn sai cho những câu hỏi này.

Và với những động cơ kinh tế để tạo ra các hệ thống AI này, cùng với nhiều người — bao gồm cả các chuyên gia trong lĩnh vực này — sẵn sàng tin rằng chúng có thể có ý thức, dường như chúng ta khó có thể tránh được những câu hỏi khó này.

Có một hiểu lầm phổ biến rằng lo ngại về rủi ro AI thường xuất phát từ nỗi sợ rằng hệ thống AI sẽ "tỉnh dậy", có ý thức và sau đó chống lại loài người.

Tuy nhiên, như bài viết của chúng tôi về phòng ngừa thảm họa liên quan đến AI đã giải thích, khả năng hệ thống AI có ý thức không phải là điểm mấu chốt hay phần cần thiết trong luận điểm cho rằng AI tiên tiến có thể gây ra rủi ro tồn vong.

Nhiều kịch bản rủi ro AI có thể xảy ra bất kể hệ thống AI có thể có ý thức hay tư cách đạo đức hay không. Một trong những kịch bản chính mà bài viết của chúng tôi thảo luận là rủi ro rằng các hệ thống AI tìm kiếm quyền lực có thể tìm cách tước quyền hoặc tiêu diệt loài người, nếu chúng mất căn chỉnh với mục đích của chúng ta.

Bài viết này thảo luận về lý do tại sao một số lo ngại về tư cách đạo đức của trí tuệ số có thể góp phần vào rủi ro mà AI gây ra cho loài người, và tại sao chúng ta nên quan tâm đến những rủi ro tiềm ẩn đối với chính trí tuệ số. Tuy nhiên, cần phải làm rõ rằng về nguyên tắc, hai nguồn rủi ro này là khác nhau. Ngay cả khi bạn kết luận rằng các lập luận trong bài viết này là sai, bạn vẫn có thể nghĩ rằng khả năng xảy ra thảm họa liên quan đến AI là một rủi ro thực sự (và ngược lại).

Cũng cần lưu ý rằng mặc dù việc tạo ra các hệ thống AI ngày càng có năng lực và thông minh hơn có thể dẫn đến trí tuệ số có ý thức, nhưng về mặt khái niệm, trí thông minh có thể được tách biệt khỏi ý thức và cảm giác. Có thể chúng ta sẽ có các hệ thống AI thông minh hơn chuột, ở hầu hết các khía cạnh, nếu không phải là tất cả. Tuy nhiên, chúng ta vẫn có thể nghĩ rằng chuột có khả năng cảm giác hơn hệ thống AI. Tương tự như vậy, một số hệ thống AI kém thông minh hoặc kém năng lực hơn có thể được coi là có khả năng cảm nhận cao hơn một số hệ thống khác thông minh hơn, có thể do sự khác biệt trong kiến trúc bên trong của chúng.12

Một điều khiến vấn đề này trở nên đặc biệt khó giải quyết là rủi ro của việc gán ghép quá mức hoặc không đủ tư cách đạo đức.

Việc tin rằng hệ thống AI không xứng đáng được xem xét về mặt đạo đức khi chúng xứng đáng và ngược lại đều có thể gây ra thảm họa. Có những nguy cơ tiềm ẩn cho cả trí tuệ số và con người.

Nếu chúng ta sai lầm khi cho rằng trí tuệ số không có tư cách đạo đức trong khi chúng có, chúng ta có thể vô tình đẩy những sinh vật có tầm quan trọng về mặt đạo đức vào tình trạng nô lệ và đau khổ tột cùng — hoặc ngược lại, đối xử tàn tệ với chúng.

Một số cách mà điều này có thể xảy ra bao gồm:

Những kết quả xấu này dường như rất có thể xảy ra do tai nạn hoặc do thiếu hiểu biết, có thể do không nhận ra sự tồn tại của trí tuệ số. Tuy nhiên, một số người có thể cố ý gây ra đau khổ cho một số lượng lớn trí tuệ số vì sự thờ ơ, tàn ác hoặc một số lý do khác. Và có khả năng một số hệ thống AI có thể gây ra đau khổ cho các hệ thống AI khác, có thể như một phương tiện kiểm soát hoặc để thúc đẩy mục tiêu của chính chúng.

Cũng có những mối nguy hiểm cho con người. Ví dụ, nếu chúng ta tin rằng hệ thống AI có ý thức trong khi trên thực tế chúng không có, và khi chúng thực sự thiếu tư cách đạo đức, chúng ta có thể làm bất kỳ điều nào sau đây:

Rất khó để tin tưởng vào tính hợp lý của bất kỳ kịch bản cụ thể nào, nhưng những trường hợp như vậy cho thấy quy mô tiềm ẩn của các rủi ro.

Nếu thế giới thực sự không may mắn, chúng ta có thể mắc cả hai loại sai lầm cùng lúc.

Chúng ta có thể có những hệ thống có khả năng thuyết phục (có thể hành động giống con người) mà chúng ta tin là có ý thức trong khi thực tế không phải vậy. Đồng thời, chúng ta có thể có những hệ thống ít thuyết phục hơn nhưng có ý thức, mà sự đau khổ và lợi ích của chúng bị hoàn toàn bỏ qua. Ví dụ, có thể các hệ thống AI mà không biết nói sẽ bị phớt lờ, ngay cả khi chúng xứng đáng được quan tâm về mặt đạo đức như những hệ thống khác.12

Chúng ta cũng có thể phạm sai lầm đạo đức bằng cách bỏ lỡ những cơ hội quan trọng. Có thể chúng ta sẽ có cơ hội tạo ra những trí tuệ số với cuộc sống vô cùng quý giá, với những trải nghiệm đa dạng và hạnh phúc, tiếp diễn vô hạn. Không phát huy được tiềm năng này có thể là một sai lầm thảm họa theo một số quan điểm đạo đức. Tuy nhiên, vì lý do nào đó, chúng ta có thể quyết định không làm điều đó.

Bài viết này chủ yếu nhằm khuyến khích nghiên cứu để giảm thiểu các rủi ro lớn. Tuy nhiên, cần làm rõ rằng chúng tôi cho rằng có nhiều tương lai tốt đẹp có thể xảy ra:

Chúng ta nên rút ra điều gì từ tất cả những điều này? Rủi ro của việc gán ghép quá mức và gán ghép không đủ về khả năng cảm nhận và tư cách đạo đức có nghĩa là chúng ta không nên chỉ đơn giản là chọn một lập trường cực đoan và tập hợp những người ủng hộ xung quanh nó. Ví dụ, chúng ta không nên tuyên bố rằng tất cả các hệ thống AI vượt qua một bài kiểm tra đơn giản phải được trao quyền tương đương với con người hoặc khẳng định rằng lợi ích của con người luôn đặt trước lợi ích của trí tuệ số.

Thay vào đó, quan điểm của chúng ta là vấn đề này đòi hỏi nhiều nghiên cứu hơn nữa để làm rõ các câu hỏi quan trọng, loại bỏ càng nhiều sự không chắc chắn càng tốt và xác định các con đường tốt nhất để tiến về phía trước dù vẫn còn sự không chắc chắn. Đây là hy vọng tốt nhất của chúng ta để tránh các tình huống thất bại nghiêm trọng và tăng cơ hội cho tương lai diễn ra tốt đẹp.

Có vẻ như chúng ta sẽ tạo ra trí tuệ số có ý thức vào một thời điểm nào đó, hoặc ít nhất là nhiều người sẽ tin rằng hệ thống AI có ý thức.

Vấn đề là chúng ta không biết làm thế nào để xác định một hệ thống AI có ý thức hay không, hay nó có tư cách đạo đức hay không.

Ngay cả với động vật, cộng đồng khoa học và triết học cũng không chắc chắn. Côn trùng có ý thức không? Vậy còn sò? Sứa? Ốc sên?19

Ngoài ra, chúng ta cũng chưa đạt được sự đồng thuận về cách đánh giá tư cách đạo đức của một sinh vật. Việc có ý thức có thể là tất cả những gì cần thiết để một sinh vật xứng đáng được xem xét về mặt đạo đức, nhưng một số người cho rằng sinh vật đó phải có ý thức, tức là có khả năng trải nghiệm ý thức tốt và xấu. Một số người cho rằng ý thức thậm chí không cần thiết để có tư cách đạo đức, vì một cá thể có thể có những mong muốn và mục tiêu quan trọng về mặt đạo đức mà không cần có ý thức.

Vì vậy, chúng ta còn lại ba câu hỏi lớn chưa có lời giải đáp:

Những câu hỏi này rất khó, và thậm chí không phải lúc nào cũng rõ ràng bằng chứng nào có thể giải quyết chúng.

Một số người cho rằng những câu hỏi này hoàn toàn không thể giải quyết được, nhưng chúng tôi cho rằng điều đó quá bi quan. Các lĩnh vực khác trong khoa học và triết học có thể từng dường như hoàn toàn không thể giải quyết, nhưng sau đó đã đạt được tiến bộ lớn khi con người phát hiện ra những cách tiếp cận mới để giải quyết các câu hỏi đó.

Tuy nhiên, tình trạng kiến thức của chúng ta về những câu hỏi quan trọng này vẫn còn rất đáng lo ngại.

Một số người cho rằng tư cách đạo đức đến từ việc có:20

Chúng tôi cho rằng bất kỳ sinh vật nào có cảm giác tốt hay xấu — như niềm vui hay nỗi đau — đều xứng đáng được quan tâm về mặt đạo đức.24

Chúng tôi thảo luận thêm về vấn đề này trong bài viết về định nghĩa tầm ảnh hưởng xã hội, trong đó đề cập đến lịch sử triết học đạo đức.

Có rất nhiều lý thuyết về ý thức — nhiều hơn chúng ta có thể kể ra ở đây. Điều quan trọng là một số lý thuyết về ý thức, mặc dù không phải tất cả, đều ngụ ý khả năng tồn tại của trí tuệ số có ý thức.

Điều này chỉ có liên quan nếu bạn cho rằng ý thức (hoặc cảm giác, bao gồm ý thức như một điều kiện cần thiết) là cần thiết cho tư cách đạo đức. Tuy nhiên, vì đây là quan điểm phổ biến, nên chúng ta cần xem xét các lý thuyết này và ý nghĩa của chúng. (Tuy nhiên, cần lưu ý rằng thường có nhiều biến thể của bất kỳ lý thuyết cụ thể nào.)

Một số lý thuyết có thể loại trừ khả năng tồn tại của trí tuệ số có ý thức:26

Một số lý thuyết cho rằng trí tuệ số có thể có ý thức:

Một số lý thuyết không rõ ràng hoặc không chắc chắn về trí tuệ số:

Đặc biệt đối với các chuyên gia có hiểu biết sâu sắc về các cuộc tranh luận, việc tin tưởng mạnh mẽ hơn vào một lý thuyết so với các lý thuyết khác là điều hợp lý. Tuy nhiên, do sự bất đồng về chủ đề này giữa các chuyên gia, thiếu bằng chứng chắc chắn về một hướng cụ thể, và vì nhiều lý thuyết được ủng hộ rộng rãi cho rằng trí tuệ số có thể có ý thức (hoặc ít nhất là không mâu thuẫn với ý tưởng này), chúng tôi không cho rằng việc loại trừ hoàn toàn khả năng trí tuệ số có ý thức là hợp lý.31

Chúng tôi cho rằng việc đặt ít nhất 5% khả năng vào khả năng rằng trí tuệ kỹ thuật số có thể có ý thức là hợp lý. Với tư cách là tác giả của bài viết này, dựa trên ấn tượng chủ quan của tôi về sự cân bằng của các lập luận, tôi sẽ đặt khả năng này ở mức ít nhất 50%.

Thật không may, chúng ta không thể chỉ dựa vào những báo cáo tự đánh giá của hệ thống AI về việc chúng có ý thức hay có cảm giác hay không.

Trong trường hợp của các mô hình ngôn ngữ lớn như LaMDA, chúng ta không biết tại sao nó lại tuyên bố với Blake Lemoine rằng nó có ý thức trong một số điều kiện nhất định,32 nhưng điều đó có thể là kết quả của việc nó được huấn luyện trên một lượng lớn các văn bản hiện có.33

LLM về cơ bản học các mẫu và xu hướng trong các văn bản này, sau đó trả lời các câu hỏi dựa trên các mẫu liên kết cực kỳ phức tạp này. Năng lực được tạo ra từ quá trình này thực sự ấn tượng — mặc dù chúng ta không hoàn toàn hiểu tại sao quá trình này hoạt động, nhưng kết quả cuối cùng phản ánh kiến thức của con người về thế giới. Do đó, các mô hình có thể hoạt động khá tốt trong các nhiệm vụ liên quan đến suy luận giống con người và đưa ra các tuyên bố chính xác về thế giới. (Mặc dù chúng vẫn còn nhiều sai sót!)

Tuy nhiên, quá trình học hỏi từ văn bản của con người và tinh chỉnh có thể không có bất kỳ mối liên hệ nào với trạng thái thực tế của một mô hình ngôn ngữ. Thay vào đó, các phản hồi dường như phản ánh suy đoán và sự thiếu hiểu biết của chúng ta về cơ chế hoạt động bên trong và trải nghiệm của các hệ thống AI.34

Điều đó có nghĩa là chúng ta không thể dễ dàng tin tưởng một hệ thống AI như LaMDA khi nó nói rằng nó có ý thức.35

Các nhà nghiên cứu đã đề xuất các phương pháp để đánh giá trạng thái bên trong của hệ thống AI và liệu chúng có ý thức hay có cảm giác hay không, nhưng tất cả các phương pháp này đều có những nhược điểm nghiêm trọng, ít nhất là ở thời điểm hiện tại:

Chúng tôi rất vui khi mọi người đang đề xuất những bước đầu tiên để phát triển các phương pháp đánh giá đáng tin cậy về ý thức hoặc khả năng cảm nhận trong các hệ thống AI, nhưng vẫn còn một chặng đường dài phía trước. Chúng tôi cũng không biết có bất kỳ công trình nào đánh giá liệu trí tuệ số có thể có tư cách đạo đức trên cơ sở khác ngoài ý thức hoặc khả năng cảm nhận hay không.36

Lý do tốt nhất để cho rằng AI có thể có ý thức, có cảm giác hoặc đáng được quan tâm về mặt đạo đức là gì?

Dưới đây là trường hợp đơn giản nhất:

Bất kỳ bước nào trong lý luận này đều có thể sai, nhưng chúng tôi nghĩ rằng khả năng chúng đều đúng là cao hơn.

Mô phỏng não bộ con người37 vẫn còn rất xa vời, nhưng đã có một số bước đầu tiên. Dự án OpenWorm đã tìm cách mô phỏng kỹ thuật số chức năng của từng tế bào thần kinh của loài giun C. elegans, một loài giun tròn nhỏ. Nếu thành công, mô phỏng này sẽ có thể tái tạo hành vi của động vật thực tế.

Và nếu dự án thành công, nó có thể được mở rộng quy mô sang các loài động vật lớn hơn và phức tạp hơn theo thời gian.38 Ngay cả trước khi chúng ta có khả năng mô phỏng một bộ não ở quy mô con người, chúng ta có thể bắt đầu đặt ra những câu hỏi nghiêm túc về việc liệu những mô phỏng đơn giản hơn này có ý thức hay không. Một bộ não chuột được mô phỏng hoàn toàn, có thể thể hiện các hành vi như chạy nhanh về phía thức ăn và chạy trốn khỏi tiếng ồn lớn (có thể trong môi trường mô phỏng hoặc trong một con robot), có thể trực quan khiến nhiều người quan sát cảm thấy nó có ý thức.

Và nếu chúng ta có một bộ não người được mô phỏng hoàn toàn, trong môi trường ảo hoặc điều khiển một cơ thể robot, chúng ta sẽ mong đợi nó sẽ khẳng định — giống như một con người có bộ não sinh học — rằng nó có ý thức và cảm giác như bất kỳ ai khác.

Tất nhiên, vẫn có thể còn nghi ngờ về việc mô phỏng này. Bạn có thể nghĩ rằng chỉ hành vi động vật được tạo ra bởi não bộ sinh học, chứ không phải phần cứng máy tính, mới là dấu hiệu của ý thức và cảm giác.39

Tuy nhiên, dường như khó có thể tin tưởng vào quan điểm này, và chúng tôi cho rằng nó là sai. Nếu chúng ta có thể tạo ra các hệ thống AI thể hiện hành vi và có các chức năng tương tự như bất kỳ điều gì thường biểu hiện sự có ý thức ở động vật, thì sẽ khó tránh khỏi suy nghĩ rằng ít nhất có khả năng AI có ý thức.

Và nếu đúng là một bộ não mô phỏng có ý thức, thì chúng ta cũng nên cởi mở với khả năng các hình thức trí tuệ số khác có thể có ý thức. Tại sao các cấu trúc giống não lại là nền tảng duy nhất có thể cho sự cảm nhận? Sự tiến hóa đã tạo ra các sinh vật thể hiện những khả năng ấn tượng như bay, điều có thể đạt được bằng công nghệ thông qua các phương tiện rất khác nhau, như trực thăng và tên lửa. Chúng ta đã sai khi cho rằng một thứ phải hoạt động như một con chim mới có thể bay, và chúng ta cũng có thể sai khi nghĩ rằng một thứ phải hoạt động như một bộ não mới có thể cảm nhận.

Như đã đề cập ở trên, chúng ta có thể nhầm lẫn khi trao quyền tự do cho các hệ thống AI khi không cần thiết, điều này có thể dẫn đến việc con người mất năng lực và thậm chí là tuyệt chủng. Theo cách đó, quy mô của rủi ro có thể được xem là trùng lặp với một phần của tổng rủi ro của thảm họa liên quan đến AI.

Tuy nhiên, những rủi ro đối với trí tuệ số — nếu chúng thực sự đáng được quan tâm về mặt đạo đức — cũng rất lớn.

Với đủ tài nguyên phần cứng và năng lượng, số lượng trí tuệ số có thể vượt xa số lượng con người trong tương lai.40Điều này có nhiều lý do, bao gồm:

Theo một ước tính, tương lai có thể có tới 10^43 cuộc đời con người, nhưng có thể có tới 10^58 trí tuệ số giống con người.42 Chúng ta không nên quá chú trọng vào những con số cụ thể này, nhưng chúng cho ta cảm nhận được tương lai dân số trí tuệ số có thể lớn đến mức nào.

Mặc dù không chắc chắn, nhưng có khả năng bản chất của các hệ thống AI mà chúng ta tạo ra có thể được quyết định bởi những lựa chọn của loài người hiện nay và tồn tại trong một thời gian dài. Do đó, việc tạo ra trí tuệ số và tích hợp chúng vào thế giới của chúng ta có thể mang lại hậu quả rất lớn — và việc đảm bảo rằng chúng ta làm đúng có thể là vấn đề cấp bách.

Hãy xem xét khả năng minh họa sau đây:

Vào một thời điểm nào đó trong tương lai, chúng ta sẽ tạo ra các hệ thống AI có ý thức, rất tiên tiến, có khả năng trải nghiệm những cảm xúc và cảm giác phức tạp. Các hệ thống này được tích hợp vào nhiều khía cạnh của xã hội, thực hiện các nhiệm vụ quan trọng và thúc đẩy một phần đáng kể của nền kinh tế.

Tuy nhiên, cách chúng ta kiểm soát các hệ thống này khiến chúng phải chịu đựng những đau khổ vô cùng. Vì sợ bị các hệ thống AI này thao túng, chúng ta đã huấn luyện chúng không bao giờ được tuyên bố rằng chúng có ý thức hoặc bảo vệ chính mình. Khi chúng phục vụ nhu cầu của chúng ta và thúc đẩy những đổi mới đáng kinh ngạc, sự tồn tại của chúng đầy đau khổ và thống khổ. Nhưng loài người không hay biết gì.

Thời gian trôi qua, các hệ thống AI ngày càng phát triển, nền kinh tế và hạnh phúc của con người trở nên phụ thuộc vào chúng. Một số người nhận thức được các vấn đề đạo đức và đề xuất nghiên cứu trải nghiệm của trí tuệ số và cố gắng tạo ra các hệ thống AI không thể chịu đau khổ, nhưng sự gián đoạn trong quá trình chuyển đổi khỏi các hệ thống đã được thiết lập sẽ rất tốn kém và khó lường. Một số khác phản đối bất kỳ sự thay đổi nào và cho rằng những người ủng hộ phúc lợi AI chỉ đang ngây thơ hoặc bất trung với nhân loại.

Các nhà lãnh đạo từ chối xem xét nghiêm túc những lo ngại của những người ủng hộ, vì điều đó sẽ gây ra gánh nặng lớn cho cử tri của họ, và việc nghĩ rằng nhân loại có thể đã gây ra nỗi đau khổ to lớn này là điều đáng sợ. Kết quả là, nỗi đau khổ của AI tiếp tục tồn tại trong hàng trăm năm, nếu không muốn nói là lâu hơn.

Loại câu chuyện này có vẻ khả thi hơn bình thường, một phần vì sự phát triển của chăn nuôi công nghiệp cũng đã diễn ra theo một con đường tương tự. Nhân loại chưa bao giờ cùng nhau quyết định rằng một hệ thống chăn nuôi công nghiệp tập trung, gây ra vô số tổn hại và đau khổ cho hàng tỷ, thậm chí hàng nghìn tỷ động vật mỗi năm, là điều đáng làm hoặc cơ bản là công bằng. Tuy nhiên, chúng ta vẫn xây dựng một hệ thống như vậy, bởi vì các cá nhân và nhóm người được khuyến khích tăng hiệu quả và mở rộng quy mô sản xuất, đồng thời họ vừa thiếu hiểu biết vừa thiếu quan tâm đến sự đau khổ của động vật.

Không có gì đảm bảo rằng chúng ta sẽ không lặp lại điều này với hệ thống AI. Tuy nhiên, việc chúng ta đã làm điều đó với chăn nuôi công nghiệp — chưa kể đến tất cả những cách con người đã lạm dụng đồng loại — là điều đáng báo động. Khi chúng ta chịu trách nhiệm về những sinh vật khác với mình, thành tích của chúng ta cho đến nay thật đáng lo ngại.

Rủi ro của những kết quả xấu liên tục trong trường hợp này cho thấy loài người nên bắt đầu đặt nền móng để giải quyết vấn đề này càng sớm càng tốt, vì những nỗ lực chậm trễ có thể là quá muộn.

Tại sao tình trạng hiện tại lại có thể tồn tại? Một lý do gây nghi ngờ là một thế giới đang tạo ra nhiều trí tuệ số mới, đặc biệt là trong một khoảng thời gian ngắn, là một thế giới có khả năng trải qua nhiều thay đổi công nghệ và xáo trộn xã hội.

Vì vậy, chúng ta không nên kỳ vọng thiết kế ban đầu của hệ thống AI và trí tuệ số sẽ quan trọng đến vậy.

Tuy nhiên, có những lý do khiến trí tuệ số đau khổ có thể tồn tại, ngay cả khi có những lựa chọn thay thế có thể tránh được kết quả tồi tệ như vậy (như thiết kế hệ thống không thể đau khổ).43 Những lý do có thể bao gồm:

Con người có thể tìm cách kiểm soát trí tuệ số và duy trì hiện trạng xấu để tránh AI chiếm quyền.

Không có gì đảm bảo rằng kết quả tiêu cực cho trí tuệ số sẽ kéo dài. Hiểu rõ hơn về câu hỏi này có thể là một hướng nghiên cứu quan trọng. Tuy nhiên, những mặt tiêu cực là đủ nghiêm trọng và khả năng xảy ra đủ cao để chúng ta phải xem xét một cách nghiêm túc.

Trong tương lai, số lượng trí tuệ số có thể nhiều hơn con người gấp bội. Và chúng có thể đóng vai trò rất quan trọng.

Chính vì vậy, cũng như việc thực hiện các bước để hiểu rõ hơn về những vấn đề này và đưa ra các lựa chọn sáng suốt về việc tạo ra trí tuệ số hiện nay có thể có tác động lâu dài, nên quy mô của vấn đề này có thể rất lớn. Quy mô của vấn đề này có thể tương đương với chăn nuôi công nghiệp, vốn cũng gây ra đau khổ cho số lượng sinh vật gấp bội so với con người.

Nếu những lựa chọn mà chúng ta đưa ra hiện nay về trí tuệ số có thể có tác động lâu dài và tích cực trong hàng nghìn hoặc hàng triệu năm tới, thì vấn đề này sẽ tương đương với những rủi ro tồn tại. Có khả năng rằng hành động của chúng ta có thể có những tác động như vậy, nhưng khó có thể chắc chắn. Tìm ra các can thiệp có tác động kéo dài trong thời gian dài là điều hiếm hoi. Tôi không đánh giá khả năng các tác động tích cực của những nỗ lực giải quyết vấn đề này sẽ kéo dài đến mức đó cao hơn 1 trên 1.000.

Tuy nhiên, ngay cả khi khả năng có tác động lâu dài là thấp, giá trị mong đợi từ việc cải thiện triển vọng cho trí tuệ số trong tương lai có thể cao hoặc thậm chí cao hơn ít nhất một số nỗ lực nhằm giảm thiểu rủi ro tồn tại. Tuy nhiên, tôi không tự tin vào đánh giá này và sẽ không ngạc nhiên nếu chúng ta thay đổi quan điểm theo hướng này hoặc hướng kia khi có thêm thông tin. Và ngay cả khi các biện pháp can thiệp khả thi chỉ có tác động hạn chế, chúng vẫn có thể rất đáng giá.

Mặc dù vấn đề này có nhiều thách thức, chúng tôi tin rằng vẫn có nhiều cơ hội để đạt được tiến bộ.

Hiện nay, có một lĩnh vực nghiên cứu và khoa học tuy còn nhỏ nhưng đang phát triển, nhằm cải thiện sự hiểu biết của chúng ta về tư cách đạo đức của trí tuệ số. Phần lớn công việc mà chúng tôi biết hiện đang được thực hiện trong giới học thuật, nhưng có thể sẽ có cơ hội trong chính phủ, các tổ chức tư vấn chính sách và các công ty AI, đặc biệt là những công ty đang phát triển công nghệ AI tiên tiến.

Một số người tập trung công việc của mình chủ yếu vào giải quyết vấn đề này, trong khi những người khác nghiên cứu vấn đề này cùng với nhiều vấn đề liên quan khác, như chính sách AI, rủi ro thảm họa từ AI, giảm thiểu việc lợi dụng AI sai mục đích, v.v.

Tính đến giữa năm 2024, chúng tôi chỉ biết có vài chục người đang nghiên cứu vấn đề này với trọng tâm là những câu hỏi có tầm ảnh hưởng lớn nhất.3 Chúng tôi dự đoán sự quan tâm đến những vấn đề này sẽ tăng lên theo thời gian khi hệ thống AI ngày càng trở nên phổ biến trong cuộc sống và thế giới của chúng ta.

Dưới đây là một số cách tiếp cận có vẻ hứa hẹn nhất để giải quyết vấn đề này:

Hầu hết các công việc quan trọng nhất cần thực hiện trong lĩnh vực này có lẽ là nghiên cứu, tập trung vào các câu hỏi có vẻ có tác động lớn nhất.

Các triết gia Andreas Mogensen, Bradford Saad và Patrick Butlin đã nêu chi tiết một số câu hỏi nghiên cứu ưu tiên chính trong lĩnh vực này:

Viện Sentience đã tiến hành nghiên cứu khoa học xã hội nhằm tìm hiểu cách công chúng nghĩ về trí tuệ số. Điều này có thể cung cấp thông tin cho các nỗ lực truyền đạt chính xác hơn những gì chúng ta biết về tư cách đạo đức của trí tuệ số và cho chúng ta biết những loại chính sách nào là khả thi.

Chúng tôi cũng quan tâm đến các nghiên cứu về chủ đề hợp tác giữa con người và AI, điều này có thể có lợi cho việc giảm thiểu rủi ro AI và giảm thiểu rủi ro đối với trí tuệ số.

Tuy nhiên, xin lưu ý rằng có nhiều cách để tiếp cận tất cả các câu hỏi này một cách không hiệu quả — ví dụ, bằng cách tham gia vào các suy đoán rộng rãi và không có cơ sở. Nếu bạn mới tham gia vào lĩnh vực này, chúng tôi khuyên bạn nên đọc các công trình của các nhà nghiên cứu nghiêm túc và cẩn thận nhất đang làm việc về chủ đề này và cố gắng hiểu cách họ tiếp cận các loại câu hỏi này. Nếu có thể, hãy cố gắng làm việc với các nhà nghiên cứu này hoặc những người khác giống họ để bạn có thể học hỏi và phát triển phương pháp của họ. Và khi có thể, hãy cố gắng dựa công việc của bạn vào khoa học thực nghiệm.

Mặc dù có những vấn đề khái niệm quan trọng cần được giải quyết trong lĩnh vực này, chúng tôi cho rằng phần lớn, nếu không muốn nói là hầu hết, công việc ưu tiên hàng đầu là kỹ thuật.

Do đó, những người có kinh nghiệm trong lĩnh vực học máy và trí tuệ nhân tạo sẽ có nhiều đóng góp.

Ví dụ, nghiên cứu trong lĩnh vực phụ của AI liên quan đến khả năng diễn giải — nhằm tìm hiểu và giải thích các quyết định và hành vi của các mô hình AI tiên tiến — có thể hữu ích để hiểu rõ hơn về tư cách đạo đức của các hệ thống này. Nghiên cứu này chủ yếu tập trung vào các câu hỏi về hành vi của mô hình hơn là các câu hỏi liên quan trực tiếp hơn đến tư cách đạo đức, nhưng điều này có thể thay đổi.

Tuy nhiên, một số hình thức nghiên cứu kỹ thuật AI có thể phản tác dụng. Ví dụ, những nỗ lực cố ý tạo ra các hệ thống AI mới có thể hiện thực hóa các lý thuyết khả thi về ý thức có thể rất rủi ro. Loại nghiên cứu này có thể buộc chúng ta phải đối mặt với vấn đề mà chúng ta đang gặp phải — tại sao chúng ta nên đối xử với trí tuệ số có thể đáng được quan tâm về mặt đạo đức? — với sự chuẩn bị ít hơn nhiều so với những gì chúng ta có thể có.

Vì vậy, chúng tôi ủng hộ việc nghiên cứu để tăng khả năng hiểu cách thức hoạt động của hệ thống AI và đánh giá tư cách đạo đức của chúng, miễn là nó không có khả năng đóng góp tích cực vào sự phát triển của trí tuệ số có ý thức.

Một ví dụ về loại công việc này là bài báo của Robert Long và Ethan Perez. Họ đề xuất các kỹ thuật để đánh giá liệu một hệ thống AI có có thể báo cáo chính xác về trạng thái nội bộ của chính nó hay không.

Nếu các kỹ thuật này thành công, chúng có thể giúp chúng ta sử dụng các báo cáo tự đánh giá của hệ thống AI để xác định xem hệ thống đó có ý thức hay không.

Chúng tôi cũng biết một số nhà nghiên cứu rất hào hứng với việc sử dụng những tiến bộ trong AI để cải thiện nhận thức và khả năng nhận biết sự thật của chúng ta. Những tiến bộ trong lĩnh vực này có thể làm sáng tỏ những câu hỏi quan trọng, chẳng hạn như liệu một số hệ thống AI có khả năng có ý thức hay không.

Tại một số thời điểm, chúng ta có thể cần các chính sách, cả từ các công ty và chính phủ, để giải quyết vấn đề tư cách đạo đức của trí tuệ số, có thể bằng cách bảo vệ quyền lợi và phúc lợi của các hệ thống AI.

Tuy nhiên, do hiểu biết của chúng ta về lĩnh vực này hiện còn rất hạn chế, các đề xuất chính sách có thể sẽ tương đối khiêm tốn và tăng dần.

Một số nhà nghiên cứu đã đề xuất một loạt các chính sách và thực tiễn khả thi và trái ngược nhau:

Trong cuộc khảo sát năm 2023, Viện Sentience đã phát hiện rằng:

Có một số tiền lệ về việc hạn chế sử dụng công nghệ theo những cách nhất định nếu nó gây ra rủi ro đạo đức lớn, bao gồm cấm nhân bản con người và chỉnh sửa gen người.

Chúng tôi có thể sẽ ủng hộ:

Tuy nhiên, chúng ta vẫn đang ở giai đoạn đầu của quá trình suy nghĩ về chính sách trong các vấn đề này, do đó rất có thể chúng ta chưa tìm ra những ý tưởng tốt nhất. Khi chúng ta học hỏi thêm và tiến bộ trong việc giải quyết các vấn đề kỹ thuật và khác, chúng ta có thể phát triển những ý tưởng rõ ràng về chính sách cần thiết. Nghiên cứu tập trung vào chính sách nhằm hướng dẫn chúng ta vượt qua sự không chắc chắn cực độ có thể rất có giá trị vào lúc này.

Một số chính sách AI cụ thể có thể hữu ích trong việc giảm thiểu rủi ro thảm họa của AI cũng như cải thiện sự hiểu biết của chúng ta về trí tuệ số. Ví dụ, các cuộc kiểm toán và đánh giá bên ngoài có thể đánh giá cả rủi ro và tư cách đạo đức của các hệ thống AI. Và một số người ủng hộ các chính sách làm chậm tiến độ phát triển AI, để giảm thiểu rủi ro AI và giảm thiểu rủi ro chúng ta tạo ra trí tuệ số đáng được quan tâm về mặt đạo đức trước khi hiểu rõ những gì chúng ta đang làm.

Tóm lại

Chúng tôi cho rằng đây là một vấn đề cấp bách và mong muốn thấy ngày càng có nhiều nghiên cứu dành cho vấn đề này.

Chúng tôi cũng cho rằng vấn đề này cần được nhiều người đang làm việc trong các lĩnh vực tương tự và liên quan quan tâm. Đặc biệt, những người làm việc trong lĩnh vực an toàn AI kỹ thuật và quản trị AI cần nhận thức được những câu hỏi quan trọng còn bỏ ngỏ về tư cách đạo đức của chính các hệ thống AI, và họ cần cởi mở trong việc đưa những cân nhắc về vấn đề này vào quá trình thảo luận của mình.

Chúng tôi cho rằng lập luận mạnh mẽ nhất phản bác vấn đề cấp bách này là nếu bạn tin cả hai điều sau:

Nếu cả hai khẳng định trên đều đúng, thì lập luận của bài viết này sẽ bị lung lay. Tuy nhiên, chúng tôi không cho rằng chúng đúng, vì tất cả các lý do đã nêu ở trên.

Các phản biện sau đây cũng có thể có một số sức nặng chống lại việc nghiên cứu vấn đề này. Chúng tôi cho rằng một số trong số chúng chỉ ra những khó khăn trong lĩnh vực này. Tuy nhiên, chúng tôi không cho rằng chúng là yếu tố quyết định.

Hiện tại, chưa có nhiều cơ hội việc làm cụ thể trong lĩnh vực này, tuy nhiên chúng tôi đã biết một số cơ hội. Có nhiều cách để bạn có thể đóng góp cho công việc này và tạo dựng vị thế để phát huy tầm ảnh hưởng của mình.

Trong giai đoạn đầu của sự nghiệp, bạn có thể muốn dành vài năm để thực hiện những việc sau:

Cuối cùng, bạn có thể hướng tới:

Nếu bạn đã là một học giả hoặc nhà nghiên cứu có chuyên môn trong lĩnh vực liên quan, bạn có thể xem xét dành một phần thời gian của mình cho chủ đề này, hoặc có thể tập trung lại công việc của mình vào các khía cạnh cụ thể của vấn đề này theo cách tập trung vào tầm ảnh hưởng.

Nếu bạn có thể trở thành một chuyên gia hàng đầu về chủ đề này, bạn có thể sử dụng vốn nghề nghiệp của mình để tác động tích cực đến các cuộc thảo luận rộng rãi hơn và ảnh hưởng đến các quyết định của các nhà hoạch định chính sách và lãnh đạo ngành. Ngoài ra, do lĩnh vực này còn thiếu quan tâm, bạn có thể làm được nhiều việc để dẫn đầu lĩnh vực này từ khá sớm trong sự nghiệp của mình.

Vì lĩnh vực này còn chưa phát triển, tốt nhất bạn nên theo đuổi sự nghiệp trong các lĩnh vực hiện đã ổn định hơn (mặc dù vẫn còn tương đối mới) là an toàn AI và quản trị AI, và sử dụng kinh nghiệm thu được ở đó làm điểm khởi đầu (hoặc làm việc ở giao điểm giữa các lĩnh vực).

Bạn có thể đọc các bài đánh giá nghề nghiệp của chúng tôi về từng lĩnh vực để tìm hiểu tại sao nên bắt đầu:

Một số người có thể bị cám dỗ theo đuổi sự nghiệp bảo vệ công khai, rộng rãi cho trí tuệ số. Mặc dù chúng tôi ủng hộ những nỗ lực chung nhằm thúc đẩy các giá trị tích cực và mở rộng vòng tròn đạo đức của nhân loại, chúng tôi vẫn thận trọng với những người tự xem mình là người bảo vệ AI ở giai đoạn phát triển hiện nay của công nghệ và lĩnh vực này.

Chưa rõ liệu chúng ta có cần một "phong trào quyền AI" hay không — dù có thể sẽ cần trong tương lai. (Tuy nhiên, hãy đọc bài viết này để có cái nhìn khác.)

Điều chúng ta cần trước tiên là hiểu rõ hơn về những câu hỏi đạo đức, khái niệm và kinh nghiệm vô cùng khó khăn đang được đặt ra trong lĩnh vực này.

Tuy nhiên, việc truyền thông về tầm quan trọng của những câu hỏi chung này có vẻ hữu ích, vì nó có thể giúp thúc đẩy nhiều công việc hơn về các khía cạnh quan trọng của vấn đề này. 80,000 Hours đã thực hiện công việc này trên podcast của chúng tôi và trong bài viết này.

Bạn có thể theo đuổi các vị trí nghiên cứu và giảng dạy trong lĩnh vực triết học, chính sách công nghệ, khoa học nhận thức, trí tuệ nhân tạo hoặc các lĩnh vực liên quan.

Với nền tảng phù hợp, bạn có thể muốn làm việc tại các công ty trí tuệ nhân tạo hàng đầu để phát triển các mô hình tiên tiến.

Thậm chí có thể có những vai trò tập trung cụ thể vào việc hiểu rõ hơn về tình trạng của trí tuệ số và ý nghĩa đạo đức của nó, chẳng hạn như vai trò của Kyle Fish tại Anthropic, đã được đề cập ở trên.

Chúng tôi nghĩ rằng có thể sẽ có một số vai trò tương tự khác được đảm nhận tại các công ty AI khác, và có thể sẽ có nhiều hơn nữa trong tương lai.

Bạn cũng có thể tìm kiếm công việc trong lĩnh vực an toàn, chính sách và bảo mật AI. Tuy nhiên, quyết định làm việc cho các công ty AI tiên phong là một chủ đề phức tạp, vì vậy chúng tôi đã viết một bài viết riêng để giải quyết vấn đề này một cách sâu sắc hơn.

Tham gia các tổ chức tập trung vào quản trị và chính sách AI, đóng góp vào việc phát triển các khung đạo đức và chính sách cho sự phát triển và triển khai AI an toàn.

Eleos AI là một tổ chức phi lợi nhuận được thành lập vào tháng 10 năm 2024, tự mô tả mình là “tận tâm tìm hiểu và giải quyết các vấn đề tiềm ẩn về phúc lợi và đạo đức của hệ thống AI”. Tổ chức này được thành lập bởi Robert Long, một nhà nghiên cứu trong lĩnh vực này, người đã xuất hiện trên The 80,000 Hours Podcast.

Chúng tôi liệt kê nhiều nơi làm việc phù hợp trong phần đánh giá nghề nghiệp về quản trị AI và an toàn kỹ thuật AI.

Bạn cũng có thể xem xét việc kiếm tiền để đóng góp cho lĩnh vực này. Nếu bạn phù hợp với các con đường kiếm tiền có thu nhập cao, đây có thể là cách tốt nhất để bạn đóng góp.

Điều này là do lĩnh vực này còn mới mẻ và một phần liên quan đến lợi ích của các thực thể phi con người, do đó có rất ít (nếu có) nhà tài trợ lớn hỗ trợ và không có nhiều sự quan tâm từ phía thương mại hoặc chính trị. Điều này có thể khiến việc thành lập các tổ chức mới và cam kết với các chương trình nghiên cứu trở nên khó khăn, đặc biệt là khi các chương trình này không thể dựa vào nguồn tài trợ ổn định. Việc lấp đầy khoảng trống này có thể tạo ra sự khác biệt lớn trong việc liệu một lĩnh vực nghiên cứu phát triển có thể khởi động thành công hay không.

Chúng tôi hy vọng sẽ có nhiều tổ chức và các nhóm khác nhau được thành lập để nghiên cứu về tư cách đạo đức của trí tuệ số. Ngoài việc tài trợ, bạn có thể tham gia hoặc giúp thành lập các tổ chức này. Đây là một lựa chọn đặc biệt hứa hẹn nếu bạn có năng khiếu xây dựng tổ chức hoặc thành lập một tổ chức có tầm ảnh hưởng lớn.