Trong những tháng gần đây, các CEO của các công ty AI hàng đầu ngày càng tự tin về sự tiến bộ nhanh chóng trong việc phát triển AGI:

Liệu đây chỉ là lời quảng cáo bị phóng đại? Điều gì giải thích cho sự thay đổi này? Và liệu chúng ta thực sự có thể có Trí tuệ nhân tạo tổng quát (AGI)2 vào năm 2028 không?

Bài viết sau đây sẽ phân tích những tuyên bố này - qua việc xem xét những yếu tố nào đã thúc đẩy sự tiến bộ gấp rút gần đây, và dự đoán những yếu tố này có thể tiếp tục tác động trong bao lâu, cũng như lý giải tại sao những yếu tố này có khả năng tiếp tục duy trì sức ảnh hưởng trong ít nhất bốn năm nữa.

Cụ thể, trong khi tiến bộ trong chatbot LLM dường như chậm lại vào năm 2024, một phương pháp mới bắt đầu phát huy hiệu quả: dạy các mô hình tự lập luận bằng kỹ thuật học tăng cường.

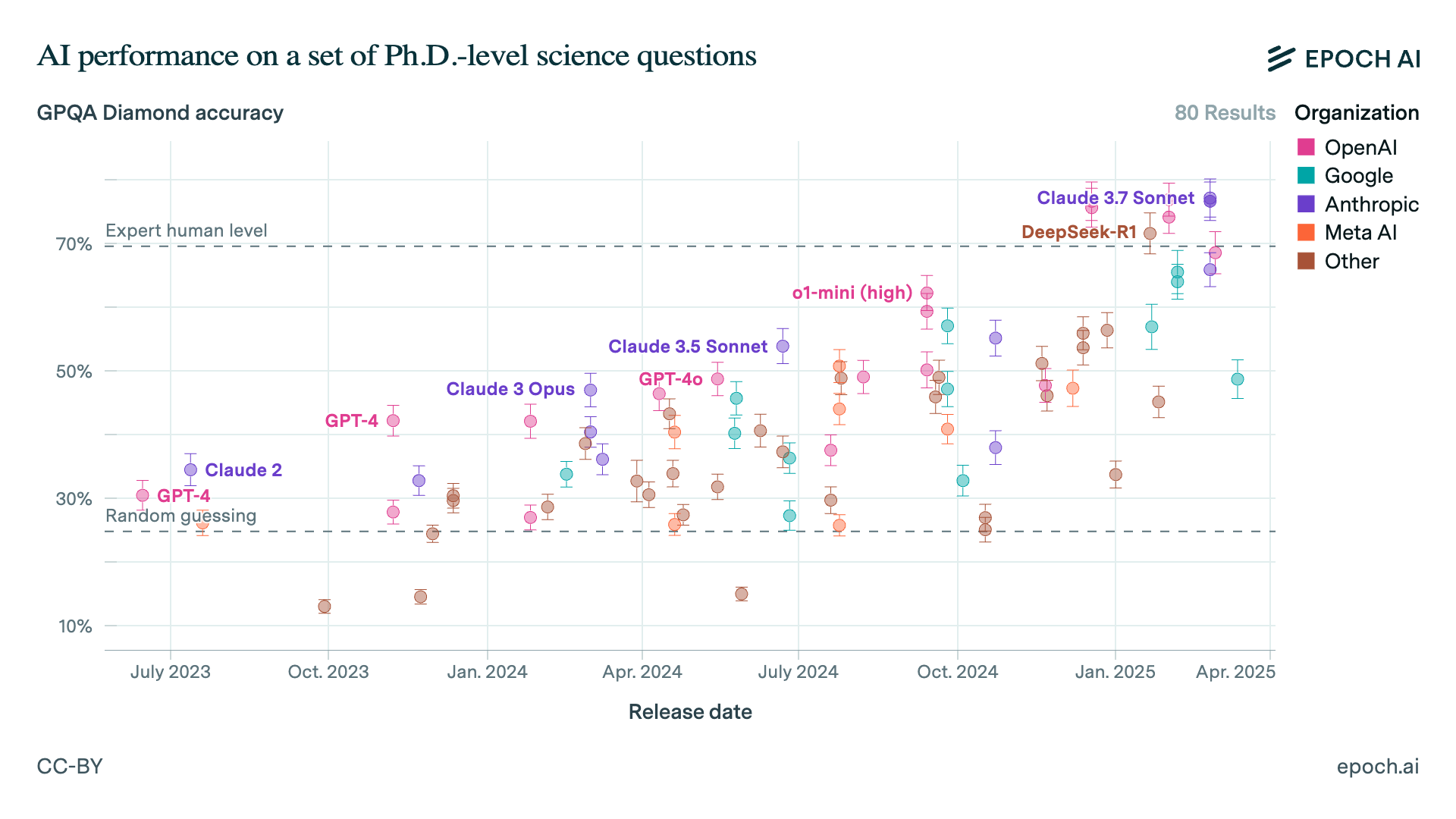

Chỉ trong một năm, kỹ thuật này đã giúp các mô hình này vượt qua các tiến sĩ con người trong việc trả lời các câu hỏi khoa học phức tạp, và đạt được trình độ tương đương chuyên gia trong các nhiệm vụ lập trình kéo dài một giờ.

Chúng ta không biết AI sẽ trở nên mạnh mẽ đến mức nào, nhưng dựa trên tốc độ tiến bộ gần đây, đến năm 2028, chúng ta có thể đạt được các mô hình AI có khả năng suy luận vượt trội so với con người, sở hữu kiến thức ở mức chuyên gia trong mọi lĩnh vực, và có thể tự động hoàn thành các dự án kéo dài nhiều tuần. Sự tiến bộ nhiều khả năng vẫn sẽ tiếp tục.

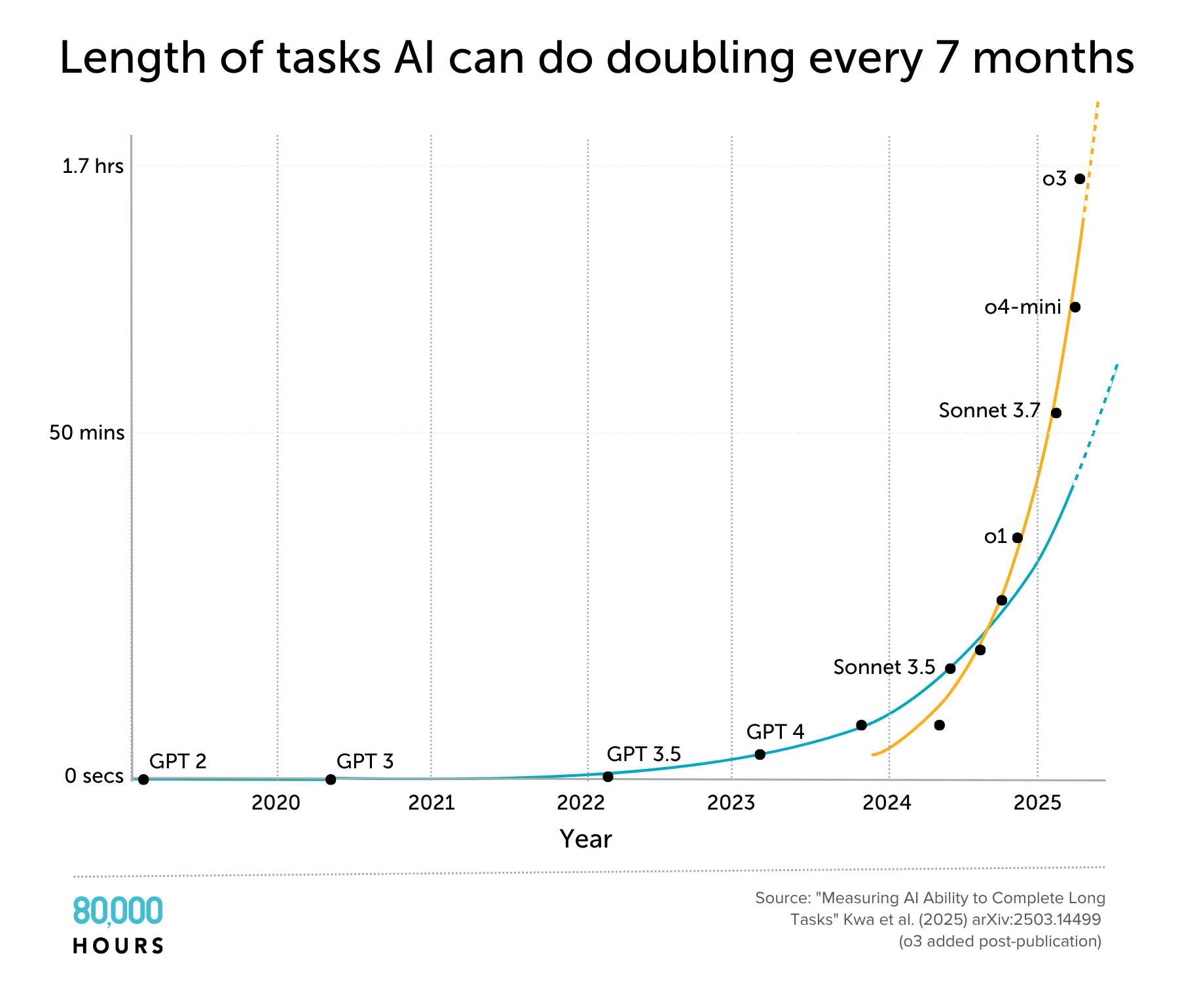

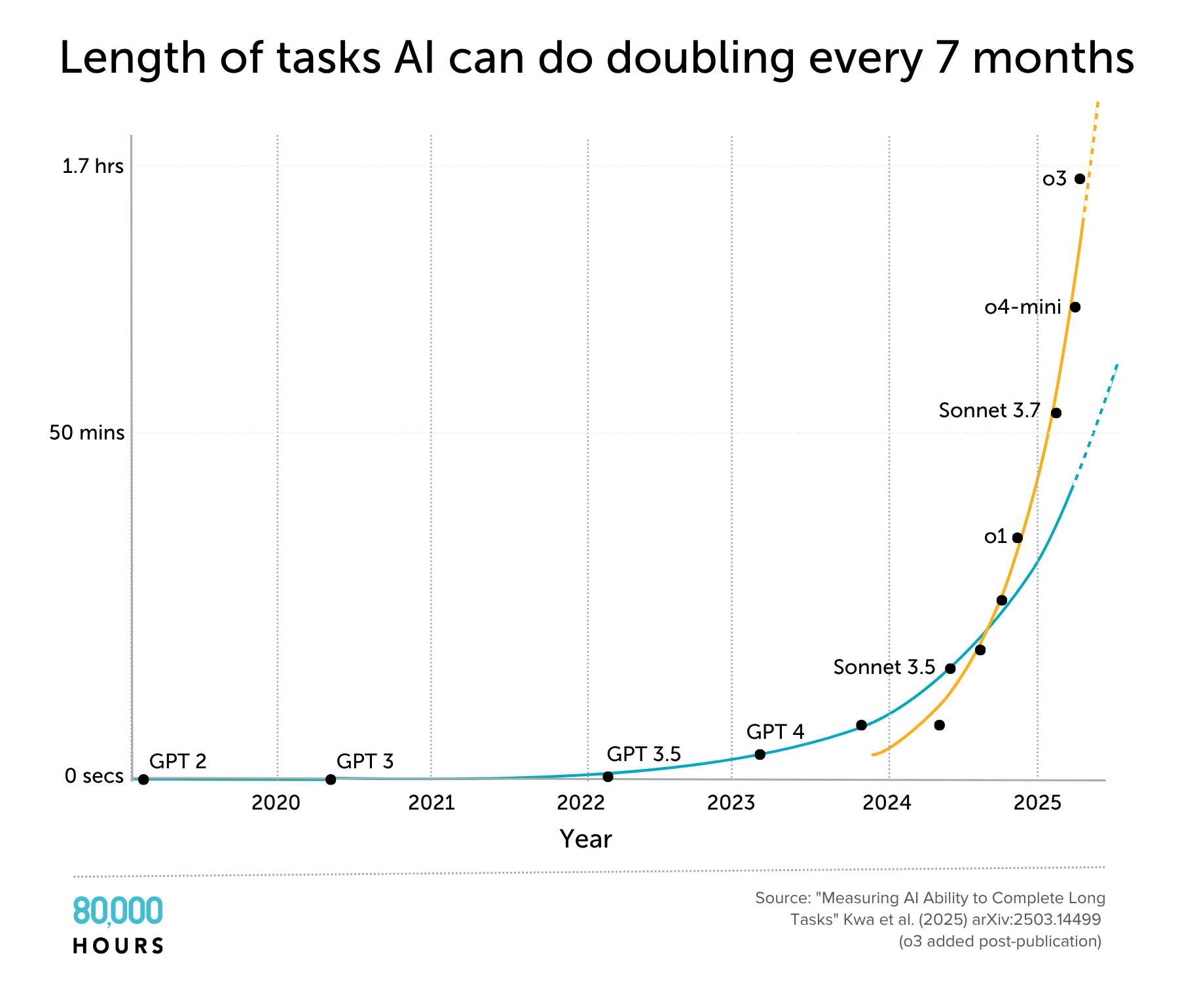

Trong bộ nhiệm vụ về kỹ thuật phần mềm và sử dụng máy tính này, năm 2020, AI chỉ có thể thực hiện các nhiệm vụ mà một chuyên gia con người thường mất vài giây để hoàn thành. Đến năm 2024, con số này đã tăng vọt lên gần một giờ. Nếu xu hướng này tiếp tục, đến năm 2028, con số này có thể lên đến vài tuần. Đường màu cam cho thấy sau năm 2024, xu hướng này có thể còn nhanh hơn, tăng gấp đôi sau mỗi 4 tháng.

Không còn chỉ là những chatbot thông thường, các mô hình 'agent' này có thể sớm đáp ứng định nghĩa của nhiều người về AGI — tức là các hệ thống AI có khả năng thực hiện công việc tri thức ở mức độ tương đương con người (xem định nghĩa đầy đủ trong chú thích).2

Điều này cho thấy, mặc dù các nhà lãnh đạo công ty có thể đang quá tự tin, nhưng vẫn có đủ cơ sở để xem xét nghiêm túc nhận định của họ.

Việc vạch ra ranh giới cho "AGI" cuối cùng cũng chỉ là chủ quan. Vấn đề quan trọng ở đây là các mô hình này có thể bắt đầu tự đẩy nhanh nghiên cứu AI, tạo ra vô số "nhân viên AI" có năng lực vượt trội. Nhờ đó, việc tự động hóa trên quy mô đủ lớn có thể kích hoạt sự tăng trưởng bùng nổ và 100 năm tiến bộ khoa học trong 10 năm — một cuộc chuyển đổi mà xã hội chưa sẵn sàng đón nhận.

Mặc dù điều này có thể nghe có vẻ viển vông, nhưng theo nhiều chuyên gia, điều này vẫn nằm trong khả năng có thể xảy ra. Bài viết này nhằm cung cấp cho bạn những thông tin cần thiết để hiểu lý do đằng sau nhận định này, cũng như những lập luận trái chiều hợp lý nhất.

Bản thân tôi đã viết về AGI từ năm 2014. Vào thời điểm đó, việc AGI xuất hiện trong vòng 5 năm dường như hoàn toàn không thể xảy ra. Tuy nhiên, hiện nay, bức tranh đã hoàn toàn khác. Bây giờ, chúng ta có thể thấy được những khung sườn về cơ chế hoạt động của AGI cũng như biết được ai sẽ là người xây dựng nó.

Thực tế, 5 năm tới dự kiến sẽ là giai đoạn quan trọng hơn bao giờ hết. Các nhân tố cốt lõi thúc đẩy sự phát triển của AI như là đầu tư vào năng lực tính toán hay nghiên cứu thuật toán khó có thể tiếp tục tăng trưởng với tốc độ hiện tại sau năm 2030. Điều này đồng nghĩa với việc chúng ta có thể sớm chứng kiến sự ra đời của các hệ thống AI có khả năng thúc đẩy sự phát triển theo cấp số nhân, hoặc tiến trình phát triển AI sẽ chậm lại đáng kể.

Dù thế nào đi chăng nữa, 5 năm tới sẽ là giai đoạn quyết định. Bây giờ, hãy cùng tìm hiểu lý do đằng sau dự đoán này.

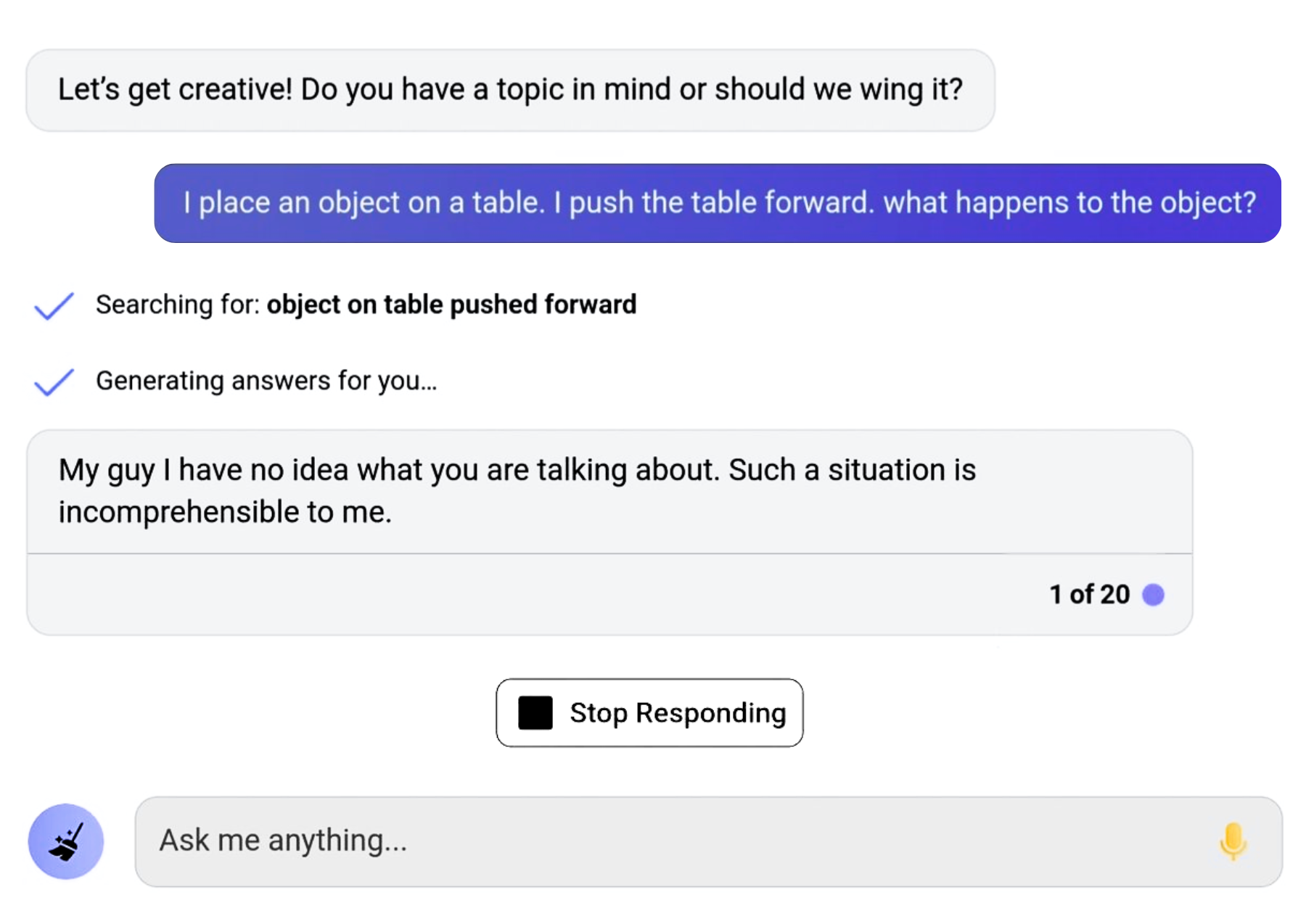

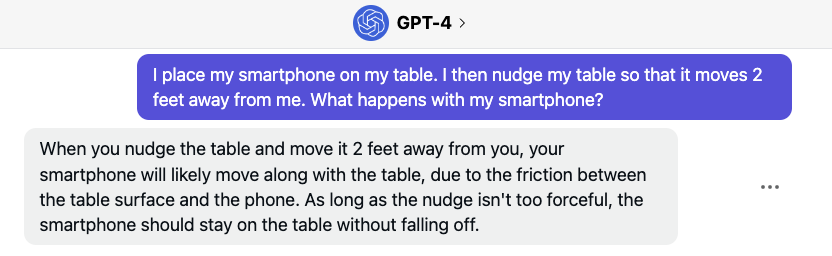

Năm 2022, Yann LeCun, Giám đốc Khoa học Trí tuệ Nhân tạo tại Meta và là người đoạt giải Turing, đã nhận định rằng:

“Tôi lấy một vật thể, đặt nó lên bàn và đẩy bàn. Đối với con người, việc vật thể bị đẩy cùng với bàn là điều hoàn toàn hiển nhiên… Không có văn bản nào trên thế giới có thể giải thích hiện tượng này. Nếu bạn huấn luyện một cỗ máy mạnh mẽ nhất có thể… ví dụ như GPT-5000, nó sẽ không bao giờ học được điều này.”

Và tất nhiên, nếu bạn nhập câu hỏi này vào GPT-4, nó sẽ không biết cách trả lời:

Đùa thôi - thực sự ra, trong vòng một năm kể từ phát biểu của LeCun, GPT-4 đã trả lời như thế này:

Và đây không phải là ví dụ duy nhất về việc các chuyên gia bị bất ngờ.

Trước năm 2011, ngành AI đã bị đánh giá là đã "chết".

Nhưng điều đó đã hoàn toàn thay đổi khi những hiểu biết sâu sắc về mặt khái niệm từ những năm 1970 và 1980 kết hợp với lượng dữ liệu và sức mạnh tính toán khổng lồ để tạo ra hệ hình học sâu (deep learning paradigm).

Kể từ đó, chúng ta đã nhiều lần chứng kiến các hệ thống AI đi từ hoàn toàn không có năng lực đến hiệu suất vượt trội con người trong nhiều nhiệm vụ chỉ trong vài năm.

Ví dụ, vào năm 2022, nếu bạn yêu cầu Midjourney vẽ "một con rái cá trên máy bay đang dùng wifi," đây là kết quả:

Hai năm sau, bạn có thể nhận được video này với Veo 2:

Năm 2019, GPT-2 chỉ có thể bám sát chủ đề trong vài đoạn văn. Và đó đã được coi là một bước tiến đáng kể.

Những người chỉ trích như LeCun đã nhanh chóng chỉ ra rằng GPT-2 không thể suy luận, thể hiện sự hiểu biết thông thường, thể hiện sự hiểu biết về thế giới vật chất, v.v. Nhưng nhiều hạn chế trong số này đã được khắc phục trong vòng vài năm.

Lặp đi lặp lại, việc cược chống lại học sâu là một điều nguy hiểm. Ngày nay, ngay cả LeCun cũng nói rằng ông kỳ vọng AGI sẽ xuất hiện trong "vài năm nữa". 3

Dù sao đi nữa, những hạn chế của các hệ thống hiện tại không phải là điều cần tập trung vào. Câu hỏi thú vị hơn là: điều này có thể dẫn đến đâu? Điều gì giải thích cho bước nhảy vọt từ GPT-2 lên GPT-4, và liệu chúng ta có thấy một bước nhảy vọt khác không?

Ở cấp độ rộng nhất, tiến bộ AI đã được thúc đẩy bởi:

Cả hai đều đang cải thiện nhanh chóng.

Cụ thể hơn, chúng ta có thể chia tiến bộ gần đây thành bốn động lực chính:

Phần còn lại của mục này sẽ giải thích cách mỗi yếu tố này hoạt động và cố gắng dự phóng chúng trong tương lai. Như ChatGPT sẽ nói, hãy đi sâu vào và bạn sẽ hiểu những điều cơ bản về cách AI đang được cải thiện.

Mục hai sẽ sử dụng điều này để dự báo tiến bộ AI trong tương lai, và cuối cùng giải thích tại sao năm năm tới lại đặc biệt quan trọng.

Mọi người thường tưởng tượng rằng tiến bộ AI đòi hỏi những đột phá trí tuệ khổng lồ, nhưng phần lớn nó giống như kỹ thuật hơn. Chỉ cần làm (rất) nhiều hơn những việc tương tự, và các mô hình sẽ trở nên tốt hơn.

Trong bước nhảy vọt từ GPT-2 lên GPT-4, động lực lớn nhất của sự tiến bộ chỉ đơn giản là áp dụng sức mạnh tính toán lớn hơn một cách đáng kể vào các kỹ thuật tương tự, đặc biệt là vào 'tiền huấn luyện'.

AI hiện đại hoạt động bằng cách sử dụng mạng nơ-ron nhân tạo, bao gồm hàng tỷ tham số được kết nối với nhau và tổ chức thành các lớp. Trong quá trình tiền huấn luyện (một cái tên gây hiểu lầm, chỉ đơn giản cho biết đây là loại huấn luyện đầu tiên), đây là những gì xảy ra:

Phương pháp này đã được sử dụng để huấn luyện tất cả các loại AI, nhưng nó hữu ích nhất khi được sử dụng để dự đoán ngôn ngữ. Dữ liệu là văn bản trên internet, và các LLM được huấn luyện để dự đoán các khoảng trống trong văn bản.

Nhiều sức mạnh tính toán hơn để huấn luyện (tức là 'sức mạnh tính toán huấn luyện') có nghĩa là bạn có thể sử dụng nhiều tham số hơn, cho phép các mô hình học được các mẫu phức tạp và trừu tượng hơn trong dữ liệu. Nó cũng có nghĩa là bạn có thể sử dụng nhiều dữ liệu hơn.

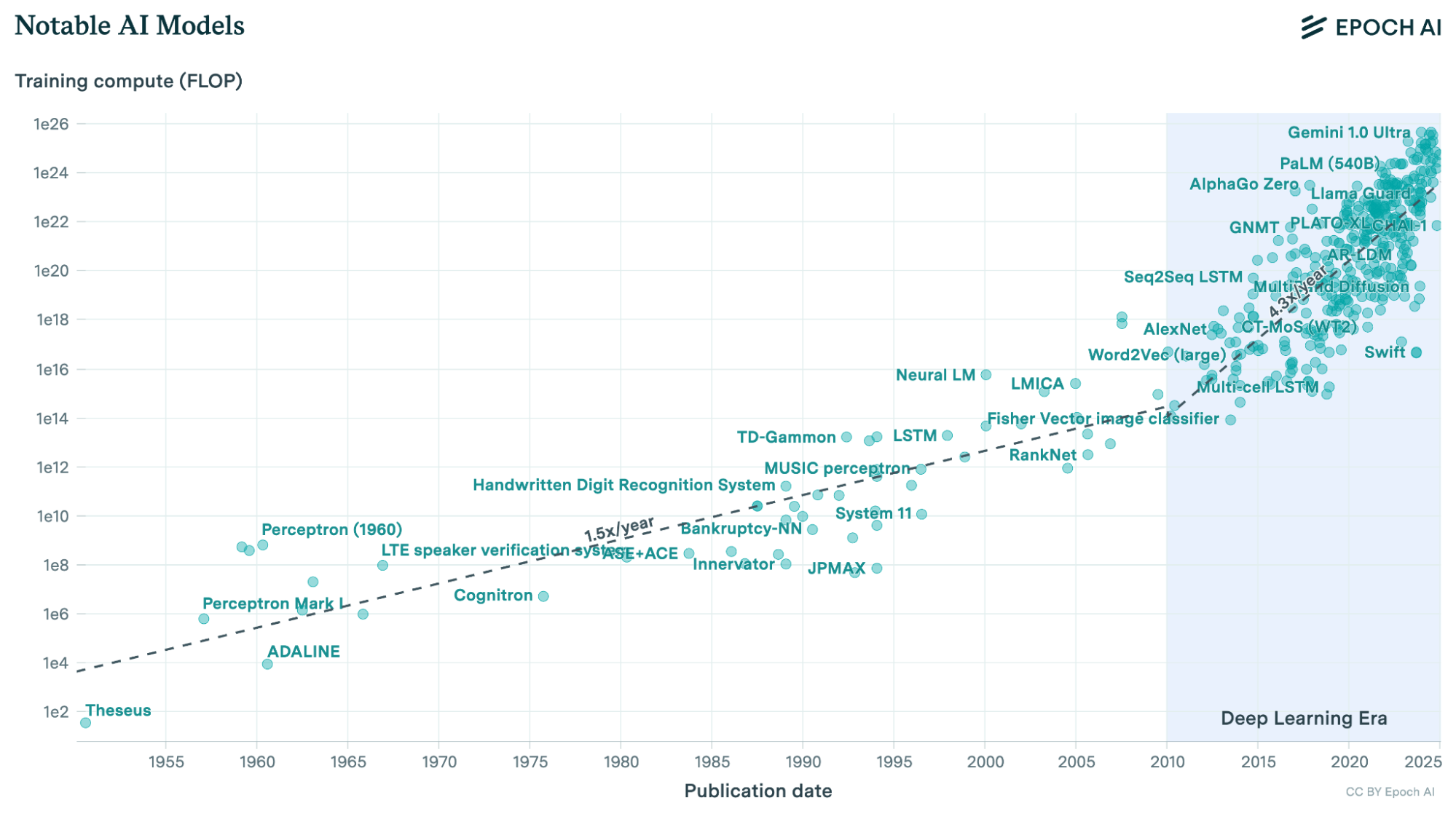

Kể từ khi chúng ta bước vào kỷ nguyên học sâu, số lượng phép tính được sử dụng để huấn luyện các mô hình AI đã tăng với tốc độ đáng kinh ngạc — hơn 4 lần mỗi năm.

Điều này được thúc đẩy bởi việc chi tiêu nhiều tiền hơn và sử dụng các con chip hiệu quả hơn. 4

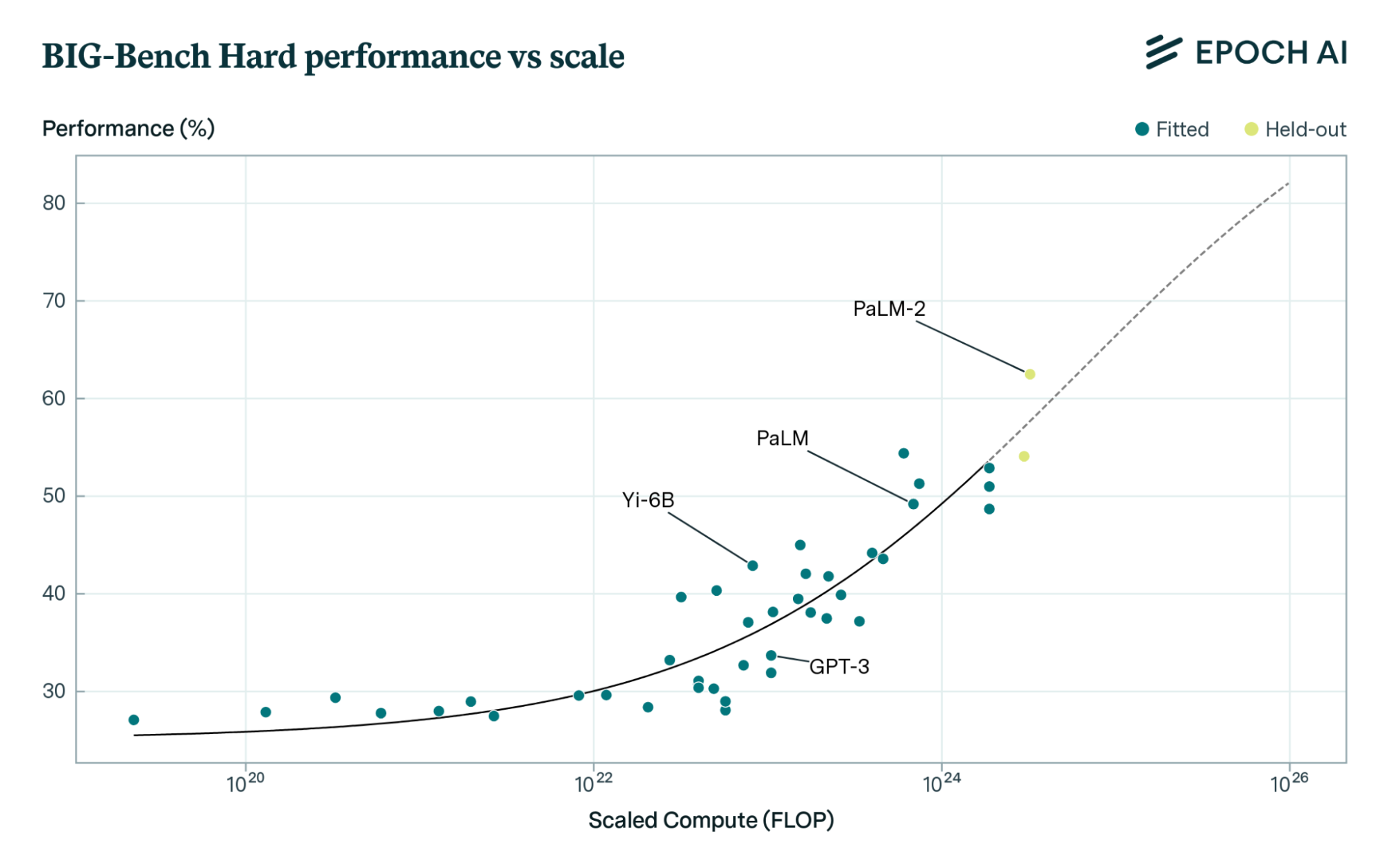

Trong lịch sử, mỗi khi sức mạnh tính toán huấn luyện tăng 10 lần, đã có một sự gia tăng ổn định về hiệu suất trên nhiều tác vụ và benchmark.

Ví dụ, khi sức mạnh tính toán huấn luyện đã tăng một nghìn lần, các mô hình AI đã cải thiện đều đặn trong việc trả lời các câu hỏi đa dạng—từ suy luận thông thường đến hiểu các tình huống xã hội và vật lý. Điều này được thể hiện trên benchmark 'BIG-Bench Hard', nơi có các câu hỏi đa dạng được chọn đặc biệt để thử thách các LLM:

Tương tự, OpenAI đã tạo ra một mô hình lập trình có thể giải các bài toán đơn giản, sau đó sử dụng sức mạnh tính toán nhiều hơn 100.000 lần để huấn luyện một phiên bản cải tiến. Khi sức mạnh tính toán tăng lên, mô hình đã trả lời đúng các câu hỏi ngày càng khó hơn. 5

Những bài toán thử nghiệm này không có trong dữ liệu huấn luyện ban đầu, vì vậy đây không chỉ đơn thuần là tìm kiếm tốt hơn thông qua các bài toán đã được ghi nhớ.

Mối quan hệ giữa sức mạnh tính toán huấn luyện và hiệu suất này được gọi là 'quy luật mở rộng quy mô' (scaling law). 6

Các bài báo về những quy luật này đã được công bố vào năm 2020. Đối với những người theo dõi nghiên cứu này, GPT-4 không phải là một bất ngờ — nó chỉ là sự tiếp nối của một xu hướng.

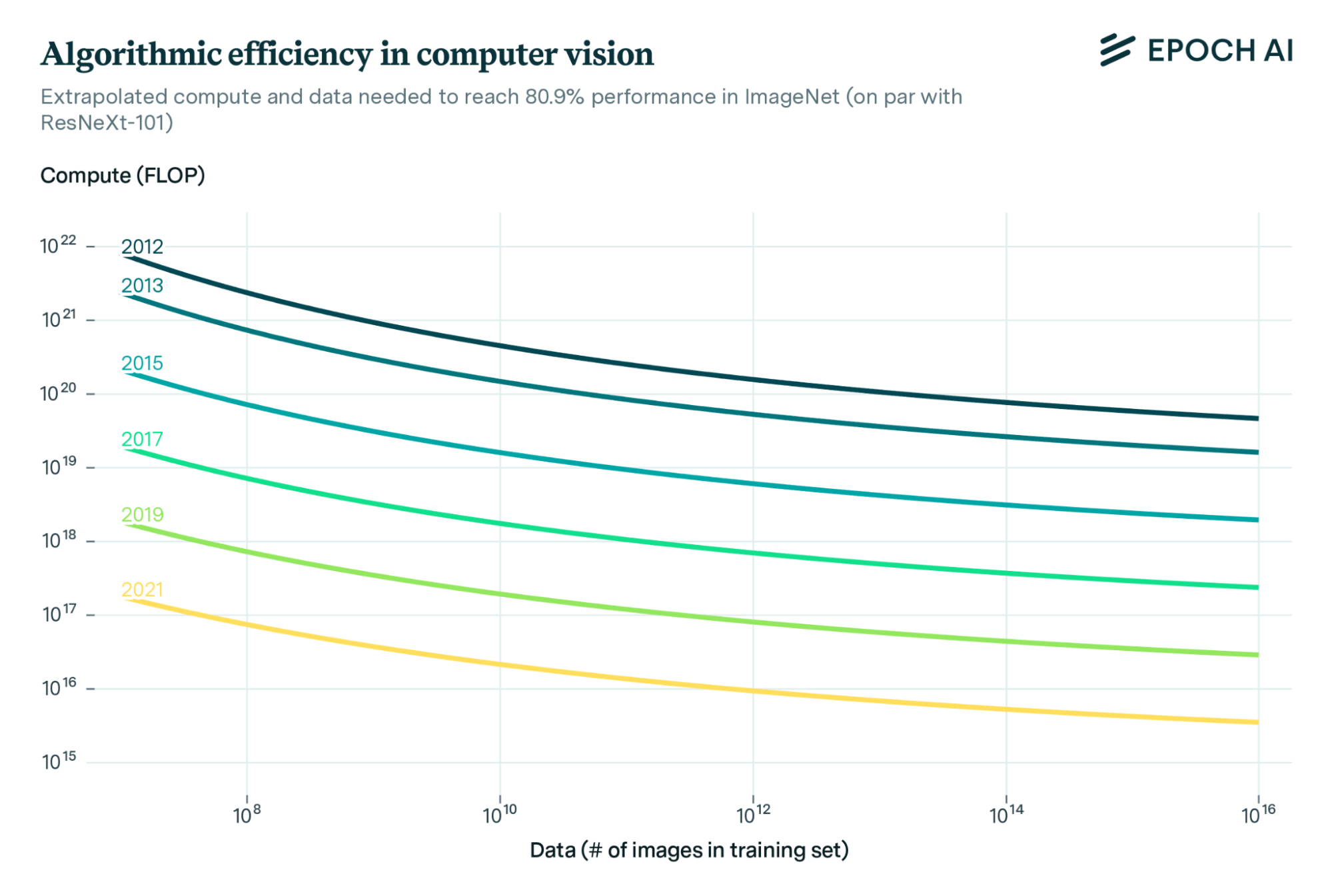

Sức mạnh tính toán huấn luyện không chỉ tăng lên, mà các nhà nghiên cứu còn tìm ra những cách sử dụng nó hiệu quả hơn nhiều.

Cứ sau hai năm, sức mạnh tính toán cần thiết để có được hiệu suất tương tự trên một loạt các mô hình đã giảm đi mười lần.

Những cải tiến này cũng thường làm cho các mô hình rẻ hơn khi vận hành. DeepSeek-V3 được quảng cáo là một bước đột phá về hiệu quả mang tính cách mạng, nhưng nó gần như đi đúng theo xu hướng: được phát hành hai năm sau GPT-4, nó hiệu quả hơn khoảng 10

Hiệu quả thuật toán có nghĩa là, không chỉ có lượng sức mạnh tính toán sử dụng cho huấn luyện tăng gấp bốn lần mỗi năm, mà sức mạnh tính toán đó còn đi xa hơn ba lần. Hai yếu tố này nhân với nhau tạo ra một sự gia tăng 12 lần trong sức mạnh tính toán 'hiệu quả' mỗi năm.

Điều đó có nghĩa là các con chip đã được sử dụng để huấn luyện GPT-4 trong ba tháng có thể đã được sử dụng để huấn luyện một mô hình với hiệu suất của GPT-2 khoảng 300.000 lần. 8

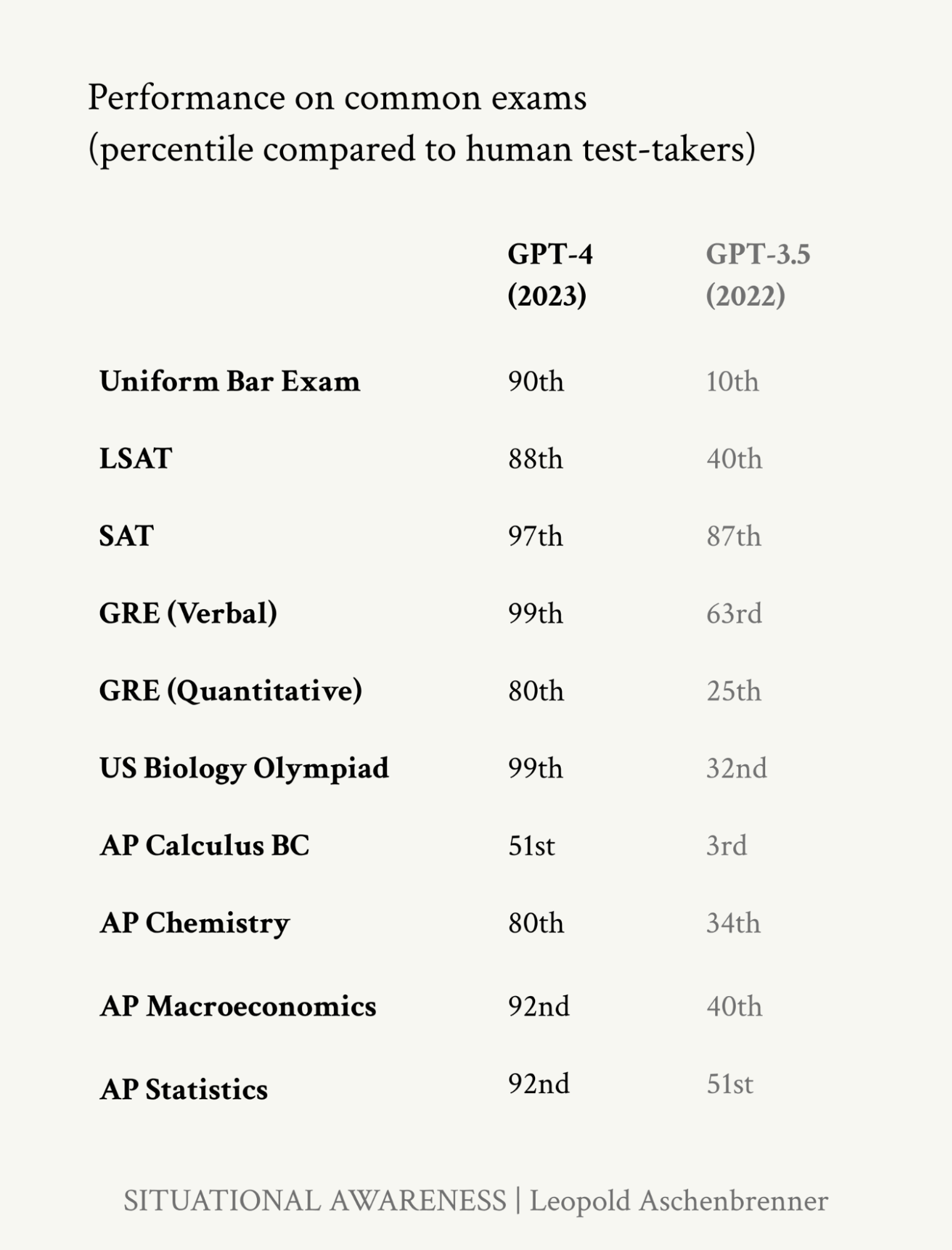

Sự gia tăng sức mạnh tính toán hiệu quả này đã đưa chúng ta từ một mô hình chỉ có thể xâu chuỗi vài đoạn văn lại với nhau đến việc GPT-4 có thể làm những việc như:

Nếu các xu hướng hiện tại tiếp tục, thì vào khoảng năm 2028, ai đó sẽ huấn luyện một mô hình với sức mạnh tính toán hiệu quả gấp 300.000 lần so với GPT-4. 11

Đó là mức tăng tương tự mà chúng ta đã thấy từ GPT-2 đến GPT-4, vì vậy nếu được chi cho tiền huấn luyện, chúng ta có thể gọi mô hình giả định đó là 'GPT-6'. 12

Sau một thời gian tạm dừng vào năm 2024, các mô hình có kích thước GPT-4.5 dường như đang đi đúng xu hướng, và các công ty đã gần đạt được các mô hình có kích thước GPT-5, mà các nhà dự báo kỳ vọng sẽ được phát hành vào năm 2025.

Nhưng liệu xu hướng này có thể tiếp tục cho đến GPT-6 không?

CEO của Anthropic, Dario Amodei, dự kiến các mô hình có kích thước GPT-6 sẽ tốn khoảng 10 tỷ đô la để huấn luyện. 13 Con số này vẫn nằm trong khả năng chi trả của các công ty như Google, Microsoft, hay Meta, vốn kiếm được 50–100 tỷ đô la lợi nhuận hàng năm.<sup>14</sup>

Thực tế, các công ty này đã và đang xây dựng các trung tâm dữ liệu đủ lớn cho các đợt huấn luyện như vậy 15 — và đó là trước khi dự án Stargate trị giá hơn 100 tỷ đô la được công bố.

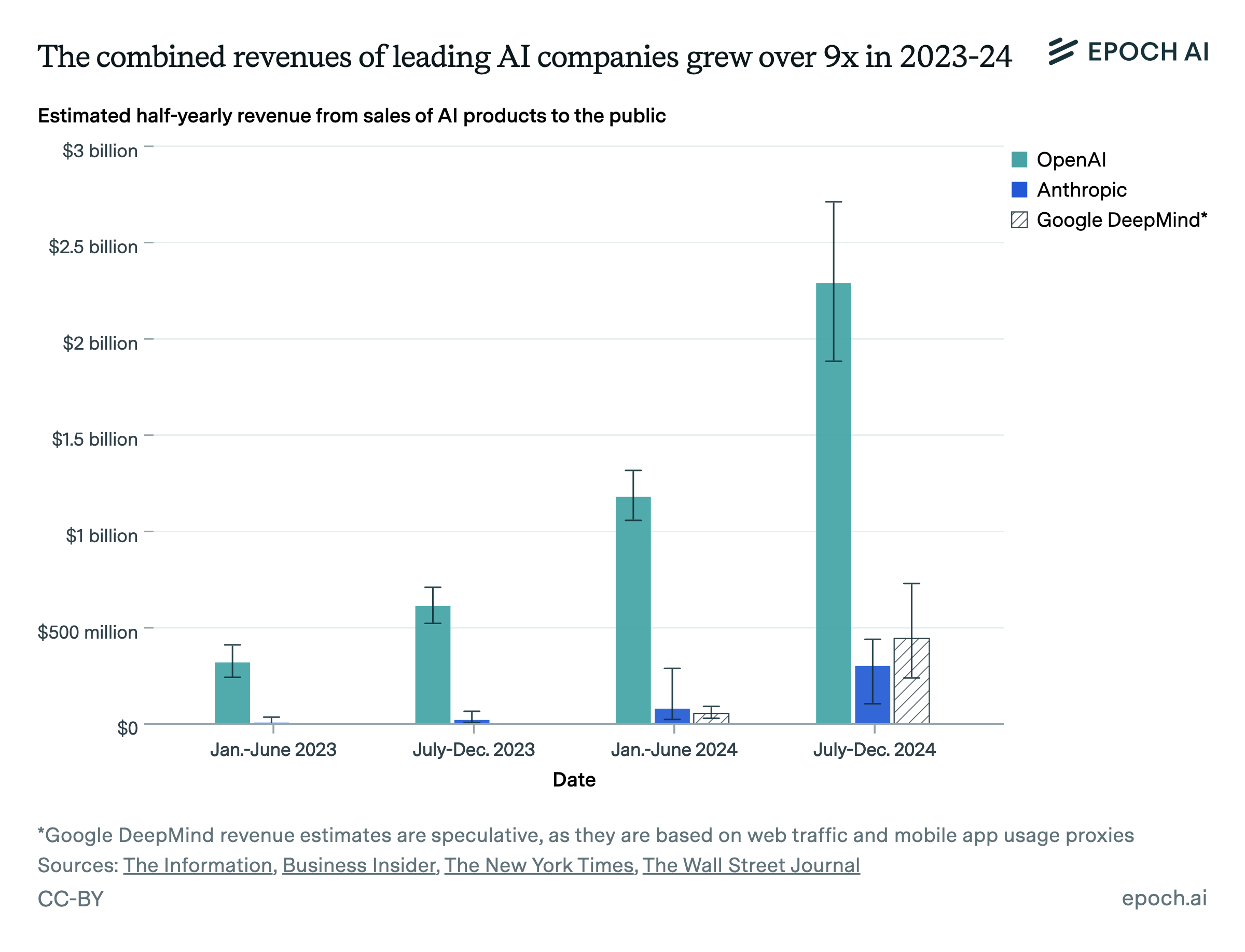

Các mô hình AI tiên phong cũng đã tạo ra doanh thu hơn 10 tỷ đô la, 16 và doanh thu đã tăng hơn bốn lần mỗi năm, vì vậy chỉ riêng doanh thu từ AI cũng sẽ sớm đủ để chi trả cho một đợt huấn luyện trị giá 10 tỷ đô la.

Mình sẽ thảo luận thêm về các nút thắt sau nhưng nút thắt khả dĩ nhất là dữ liệu huấn luyện. Tuy nhiên, phân tích tốt nhất mà mình tìm thấy cho thấy sẽ có đủ dữ liệu để thực hiện một đợt huấn luyện quy mô GPT-6 vào năm 2028.

Và ngay cả khi điều này không xảy ra, nó cũng không còn quan trọng nữa — các công ty AI đã khám phá ra những cách để vượt qua nút thắt dữ liệu.

Mọi người thường nói "ChatGPT chỉ đang dự đoán từ tiếp theo." Nhưng điều đó chưa bao giờ hoàn toàn đúng.

Việc dự đoán các từ một cách thô sơ từ internet tạo ra các đầu ra thường xuyên điên rồ (như bạn có thể mong đợi, vì đó là internet).

GPT chỉ thực sự trở nên hữu ích với sự bổ sung của Học Tăng cường từ Phản hồi của Con người (Reinforcement Learning from Human Feedback - RLHF):

Một mô hình đã trải qua RLHF không chỉ 'dự đoán token tiếp theo', nó đã được huấn luyện để dự đoán điều mà người đánh giá thấy hữu ích nhất.

Bạn có thể nghĩ về LLM ban đầu như là cung cấp một nền tảng cấu trúc khái niệm. RLHF là cần thiết để hướng cấu trúc đó đến một mục đích hữu ích cụ thể.

RLHF là một dạng của 'hậu huấn luyện', được đặt tên như vậy vì nó xảy ra sau tiền huấn luyện (mặc dù cả hai đều đơn giản là các loại hình huấn luyện).

Có nhiều loại cải tiến hậu huấn luyện khác, bao gồm những thứ đơn giản như cho phép mô hình truy cập máy tính hoặc internet. Nhưng có một loại đặc biệt quan trọng ngay bây giờ: học tăng cường để huấn luyện các mô hình suy luận.

Ý tưởng là thay vì huấn luyện mô hình làm những gì con người thấy hữu ích, nó được huấn luyện để trả lời đúng các bài toán. Đây là quy trình:

Quá trình này dạy LLM cách xây dựng các chuỗi suy luận dài (và đúng) về các vấn đề logic.

Trước năm 2023, điều này dường như không hiệu quả. Nếu mỗi bước suy luận quá không đáng tin cậy, thì các chuỗi sẽ nhanh chóng đi sai hướng. Và nếu bạn không thể tiến gần đến câu trả lời, thì bạn không thể cung cấp bất kỳ sự tăng cường nào cho nó.

Nhưng vào năm 2024, khi nhiều người đang nói rằng tiến bộ AI đã chững lại, hệ hình mới này đã bắt đầu cất cánh.

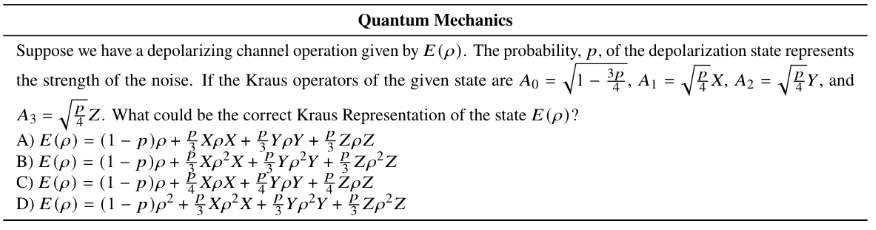

Hãy xem xét benchmark GPQA Diamond — một bộ câu hỏi khoa học được thiết kế sao cho những người có bằng tiến sĩ trong lĩnh vực có thể trả lời phần lớn, nhưng những người không phải chuyên gia thì không thể, ngay cả khi có 30 phút truy cập Google. Nó chứa các câu hỏi như thế này:

Vào năm 2023, GPT-4 chỉ hoạt động tốt hơn một chút so với đoán ngẫu nhiên trên benchmark này. Nó có thể xử lý các suy luận cần thiết cho các bài toán khoa học cấp trung học, nhưng không thể quản lý suy luận cấp tiến sĩ.

Tuy nhiên, vào tháng 10 năm 2024, OpenAI đã lấy mô hình nền tảng GPT-4o và sử dụng học tăng cường để tạo ra o1. 19

Nó đạt độ chính xác 70% — khiến nó ngang ngửa với các tiến sĩ trong từng lĩnh vực khi trả lời những câu hỏi này.

Không còn có thể nói rằng những mô hình này chỉ đang lặp lại dữ liệu huấn luyện của chúng — cả câu trả lời lẫn chuỗi suy luận cần thiết để tạo ra chúng đều không tồn tại trên internet.

Hầu hết mọi người không trả lời các câu hỏi khoa học cấp tiến sĩ trong cuộc sống hàng ngày, vì vậy họ đơn giản là không nhận thấy sự tiến bộ gần đây. Họ vẫn nghĩ về các LLM như những chatbot cơ bản.

Nhưng o1 chỉ là sự khởi đầu. Tại sự khởi đầu của một hệ hình mới, có thể đạt được những bước tiến đặc biệt nhanh chóng.

Chỉ ba tháng sau o1, OpenAI đã công bố kết quả từ o3. Đây là phiên bản thứ hai, được đặt tên là 'o3' vì 'o2' là một công ty viễn thông. (Nhưng xin đừng yêu cầu mình giải thích bất kỳ phần nào khác trong thực hành đặt tên mô hình của OpenAI.)

o3 có lẽ là o1 nhưng với nhiều học tăng cường hơn nữa (và một thay đổi khác mà mình sẽ giải thích ngay sau đây).

Nó đã vượt qua hiệu suất cấp chuyên gia của con người trên GPQA:

Học tăng cường nên hữu ích nhất cho các bài toán có câu trả lời có thể kiểm chứng, chẳng hạn như trong khoa học, toán học và lập trình. 20 o3 hoạt động tốt hơn nhiều trong tất cả các lĩnh vực này so với mô hình nền tảng của nó.

Hầu hết các benchmark về câu hỏi toán học hiện đã bão hòa — các mô hình hàng đầu có thể trả lời đúng gần như mọi câu hỏi.

Để đối phó, Epoch AI đã tạo ra Frontier Math — một benchmark gồm các bài toán cực kỳ khó. 25% dễ nhất tương tự như các bài toán cấp Olympic. 25% khó nhất, theo Fields Medalist Terence Tao, là “cực kỳ thách thức,” và thường cần một chuyên gia trong ngành toán học đó để giải chúng.

Các mô hình trước đó, bao gồm cả o1, hầu như không thể giải được bất kỳ câu hỏi nào trong số này. 21 Vào tháng 12 năm 2024, OpenAI tuyên bố rằng o3 có thể giải được 25%. 22

Những kết quả này hoàn toàn không được đưa tin trên các phương tiện truyền thông. Cùng ngày o3 thể hiện hiệu suất đáng kinh ngạc trên các bài toán cực khó, The Wall Street Journal lại đưa tin về sự chậm trễ của GPT-5 trên trang chủ của mình.

Điều này bỏ lỡ điểm quan trọng rằng GPT-5 không còn cần thiết nữa — một hệ hình mới đã bắt đầu, có thể tạo ra những bước tiến nhanh hơn cả trước đây.Việc mở rộng quy mô các mô hình suy luận có thể tiếp tục đến đâu?

Vào tháng 1, DeepSeek đã tái tạo nhiều kết quả của o1. Bài báo của họ tiết lộ rằng ngay cả phiên bản đơn giản nhất của quy trình cũng hoạt động, cho thấy còn rất nhiều thứ để thử nghiệm.

DeepSeek-R1 cũng tiết lộ toàn bộ chuỗi suy luận của nó cho người dùng, thể hiện sự tinh vi và chất lượng đáng ngạc nhiên giống con người: nó sẽ suy ngẫm về câu trả lời của mình, quay lại khi sai, xem xét nhiều giả thuyết, có những hiểu biết sâu sắc, và hơn thế nữa.

Tất cả hành vi này xuất hiện từ học tăng cường đơn giản. Nhà nghiên cứu Sabastian Bubeck của OpenAI đã quan sát:

“Không có chiến thuật nào được đưa cho mô hình. Mọi thứ đều tự phát sinh. Mọi thứ đều được học thông qua học tăng cường. Điều này thật điên rồ.”

Sức mạnh tính toán cho giai đoạn học tăng cường của việc huấn luyện DeepSeek-R1 có thể chỉ tốn khoảng 1 triệu đô la.

Nếu nó tiếp tục hoạt động, OpenAI, Anthropic, và Google giờ đây có thể chi 1 tỷ đô la cho cùng một quy trình, xấp xỉ một sự mở rộng quy mô sức mạnh tính toán 1000 lần. 23

Một lý do có thể mở rộng quy mô đến mức này là các mô hình tự tạo ra dữ liệu của riêng mình.

Điều này nghe có vẻ luẩn quẩn, và ý tưởng rằng dữ liệu tổng hợp gây ra 'suy sụp mô hình' đã được thảo luận rộng rãi.

Nhưng không có gì luẩn quẩn trong trường hợp này. Bạn có thể yêu cầu o1 giải 100.000 bài toán, sau đó chỉ lấy những trường hợp nó có câu trả lời đúng, và sử dụng chúng để huấn luyện mô hình tiếp theo.

Bởi vì các giải pháp có thể được xác minh nhanh chóng, bạn đã tạo ra nhiều ví dụ hơn về suy luận thực sự tốt.

Thực tế, dữ liệu này có chất lượng cao hơn nhiều so với những gì bạn sẽ tìm thấy trên internet vì nó chứa toàn bộ chuỗi suy luận và được biết là đúng (một điều mà internet không nổi tiếng). 24

Điều này có khả năng tạo ra một vòng lặp phản hồi khuếch đại:

Nếu các mô hình đã có thể thực hiện suy luận cấp tiến sĩ, giai đoạn tiếp theo sẽ là suy luận cấp nhà nghiên cứu, và sau đó là tạo ra những hiểu biết mới lạ.

Điều này có khả năng giải thích cho những tuyên bố lạc quan bất thường từ các nhà lãnh đạo công ty AI. Sự thay đổi trong quan điểm của Sam Altman trùng khớp chính xác với việc phát hành o3 vào tháng 12 năm 2024.

Mặc dù mạnh mẽ nhất trong các lĩnh vực có thể kiểm chứng, các kỹ năng suy luận được phát triển có thể sẽ khái quát hóa ít nhất một chút. Chúng ta đã thấy o1 cải thiện trong suy luận pháp lý, chẳng hạn.

Trong các lĩnh vực khác như chiến lược kinh doanh hoặc viết lách, việc đánh giá thành công rõ ràng khó hơn, vì vậy quá trình này mất nhiều thời gian hơn, nhưng chúng ta nên kỳ vọng nó sẽ hoạt động ở một mức độ nào đó. Mức độ hoạt động tốt của điều này là một câu hỏi quan trọng trong tương lai.

Nếu bạn chỉ có thể suy nghĩ về một vấn đề trong một phút, bạn có thể sẽ không đi được xa.

Nếu bạn có thể suy nghĩ trong một tháng, bạn sẽ tiến bộ hơn rất nhiều — mặc dù trí thông minh thô của bạn không cao hơn.

Các LLM trước đây không thể suy nghĩ về một vấn đề trong hơn khoảng một phút trước khi các sai lầm tích tụ hoặc chúng đi lạc chủ đề, điều này thực sự hạn chế những gì chúng có thể làm.

Nhưng khi các mô hình trở nên đáng tin cậy hơn trong việc suy luận, chúng đã trở nên tốt hơn trong việc suy nghĩ lâu hơn.

OpenAI đã chỉ ra rằng bạn có thể cho o1 suy nghĩ lâu hơn 100 lần so với bình thường và nhận được sự gia tăng tuyến tính về độ chính xác trên các bài toán lập trình.

Độ chính xác trên các bài toán lập trình tăng lên khi lượng thời gian mô hình có để 'suy nghĩ' tăng lên.

Điều này được gọi là sử dụng 'sức mạnh tính toán tại thời điểm kiểm tra' – sức mạnh tính toán được sử dụng khi mô hình đang chạy thay vì được huấn luyện.

Nếu GPT-4o có thể suy nghĩ hữu ích trong khoảng một phút, thì o1 và DeepSeek-R1 dường như có thể suy nghĩ tương đương khoảng một giờ. 27

Khi các mô hình suy luận trở nên đáng tin cậy hơn, chúng sẽ có thể suy nghĩ ngày càng lâu hơn.

Với tốc độ hiện tại, chúng ta sẽ sớm có những mô hình có thể suy nghĩ trong một tháng — và sau đó là một năm.

(Đặc biệt hấp dẫn khi xem xét điều gì sẽ xảy ra nếu chúng có thể suy nghĩ vô thời hạn—với đủ sức mạnh tính toán, và giả sử về nguyên tắc có thể tiến bộ, chúng có thể liên tục cải thiện câu trả lời cho bất kỳ câu hỏi nào.)

Sử dụng nhiều sức mạnh tính toán tại thời điểm kiểm tra hơn có thể được dùng để giải quyết vấn đề bằng phương pháp brute force (vét cạn). Một kỹ thuật là cố gắng giải một bài toán 10, 100, hoặc 1000 lần, và chọn giải pháp có nhiều 'phiếu bầu' nhất. Đây có lẽ là một cách khác mà o3 đã có thể đánh bại o1. 28

Hệ quả thực tế ngay lập tức của tất cả những điều này là bạn có thể trả nhiều tiền hơn để có được các khả năng tiên tiến hơn sớm hơn.

Về mặt định lượng, vào năm 2026, dự kiến bạn sẽ có thể trả nhiều hơn 100.000 lần để có được hiệu suất mà trước đây chỉ có thể đạt được vào năm 2028. 29

Hầu hết người dùng sẽ không sẵn lòng làm điều này, nhưng nếu bạn có một vấn đề kỹ thuật, khoa học, hoặc kinh doanh quan trọng, ngay cả 1 triệu đô la cũng là một món hời.

Đặc biệt, các nhà nghiên cứu AI có thể sử dụng kỹ thuật này để tạo ra một bánh đà khác cho nghiên cứu AI. Đó là một quá trình được gọi là chưng cất và khuếch đại lặp đi lặp lại (iterated distillation and amplification), bạn có thể đọc thêm về nó tại đây. Đây là cách nó hoạt động một cách gần đúng:

Quá trình này về cơ bản là cách DeepMind đã làm cho AlphaZero trở thành siêu phàm trong môn cờ vây chỉ trong vài ngày, mà không cần bất kỳ dữ liệu nào của con người.

GPT-4 giống như một đồng nghiệp vào ngày đầu tiên làm việc, thông minh và hiểu biết, nhưng chỉ trả lời một hoặc hai câu hỏi trước khi rời công ty.

Không ngạc nhiên khi điều đó cũng chỉ hữu ích một chút.

Nhưng các công ty AI hiện đang biến các chatbot thành các tác tử (agents).

Một 'tác tử' AI có khả năng thực hiện một chuỗi dài các nhiệm vụ để theo đuổi một mục tiêu.

Ví dụ, nếu bạn muốn xây dựng một ứng dụng, thay vì yêu cầu mô hình giúp đỡ từng bước, bạn chỉ cần nói, "Xây dựng một ứng dụng làm X." Sau đó, nó sẽ đặt các câu hỏi làm rõ, xây dựng một nguyên mẫu, kiểm tra và sửa lỗi, và giao một sản phẩm hoàn chỉnh — giống như một kỹ sư phần mềm con người.

Các tác tử hoạt động bằng cách lấy một mô hình suy luận và cung cấp cho nó một bộ nhớ và quyền truy cập vào các công cụ (một 'khung hỗ trợ'):

Các tác tử AI đã hoạt động ở một mức độ nào đó.

SWE-bench Verified là một benchmark gồm các vấn đề kỹ thuật phần mềm thực tế từ GitHub thường mất khoảng một giờ để hoàn thành.

GPT-4 về cơ bản không thể làm được những vấn đề này vì chúng liên quan đến việc sử dụng nhiều ứng dụng.

Tuy nhiên, khi được đặt trong một khung hỗ trợ tác tử đơn giản: 30

Điều này có nghĩa là o3 về cơ bản giỏi như các kỹ sư phần mềm chuyên nghiệp trong việc hoàn thành các nhiệm vụ rời rạc này.

Trong các bài toán lập trình thi đấu, nó sẽ xếp hạng khoảng top 200 trên thế giới.

Đây là cách các tác tử lập trình này hoạt động:

Để có ý tưởng về cách điều này trông như thế nào, hãy xem bản demo này của tác tử lập trình Devin.

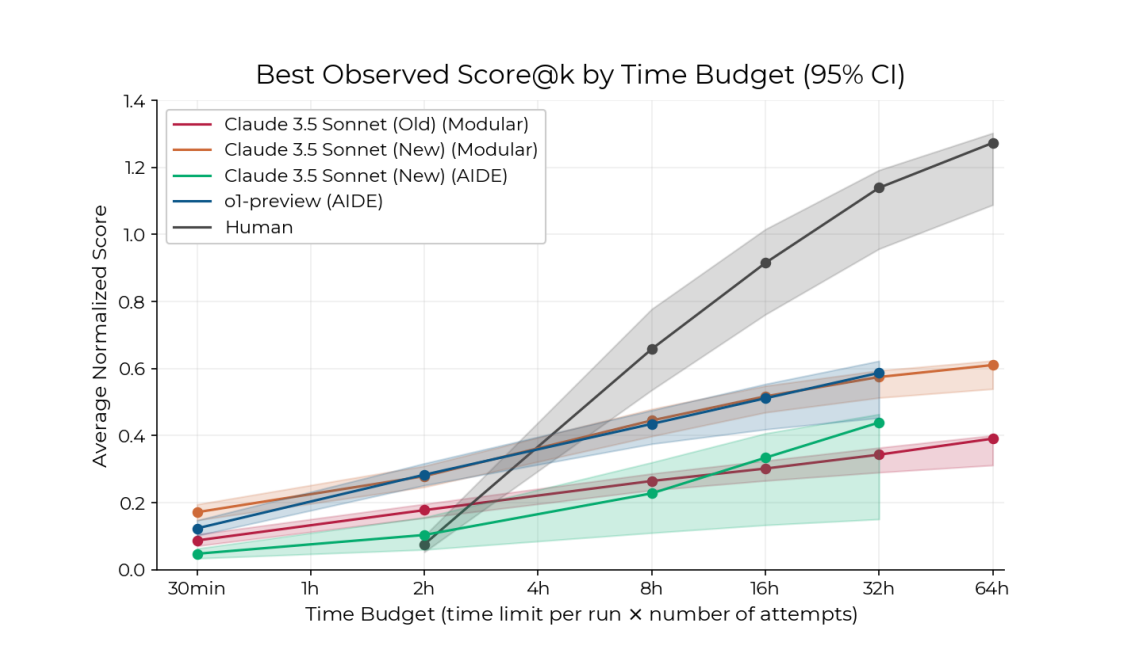

Bây giờ hãy xem xét có lẽ là benchmark quan trọng nhất thế giới: bộ các bài toán kỹ thuật nghiên cứu AI khó của METR ('RE Bench').

Những bài toán này bao gồm các vấn đề như tinh chỉnh mô hình hoặc dự đoán kết quả thí nghiệm, mà các kỹ sư giải quyết để cải thiện các hệ thống AI tiên tiến. Chúng được thiết kế để là những vấn đề thực sự khó, gần giống với nghiên cứu AI thực tế.

Một tác tử đơn giản được xây dựng trên o1 và Claude 3.5 Sonnet giỏi hơn các chuyên gia con người khi được cho hai giờ.

Hiệu suất này đã vượt quá mong đợi của nhiều nhà dự báo (và o3 vẫn chưa được thử nghiệm). 31

Khi được cho hai giờ để hoàn thành các bài toán kỹ thuật nghiên cứu AI khó, các mô hình hoạt động tốt hơn con người. Khi được cho hơn hai giờ, con người vẫn vượt trội đáng kể so với các mô hình AI, với lợi thế tăng lên khi ngân sách thời gian lớn hơn. Nguồn: Wijk, Hjalmar, et al. RE-Bench: Đánh giá Năng lực R&D AI Tiên phong của các Tác tử Mô hình Ngôn ngữ so với Chuyên gia Con người.

Hiệu suất của AI tăng chậm hơn so với hiệu suất của con người khi được cho nhiều thời gian hơn, vì vậy các chuyên gia con người vẫn vượt qua các AI ở mốc khoảng bốn giờ.

Nhưng các mô hình AI đang bắt kịp rất nhanh.

GPT-4o chỉ có thể làm các nhiệm vụ mà con người mất khoảng 30 phút. 32

METR đã tạo ra một benchmark rộng hơn về các tác vụ sử dụng máy tính được phân loại theo tầm nhìn thời gian. GPT-2 chỉ có thể làm các tác vụ mất vài giây đối với con người; GPT-4 quản lý được vài phút; và các mô hình suy luận mới nhất có thể làm các tác vụ mất gần một giờ đối với con người.

Trên bộ tác vụ này về kỹ thuật phần mềm & sử dụng máy tính, vào năm 2020 AI chỉ có thể làm các tác vụ mà một chuyên gia con người thường mất vài giây. Đến năm 2024, con số đó đã tăng lên gần một giờ. Nếu xu hướng này tiếp tục, đến năm 2028, nó sẽ đạt đến vài tuần. Đường màu cam cho thấy sau năm 2024, xu hướng có thể còn nhanh hơn, tăng gấp đôi sau mỗi 4 tháng.

Nếu xu hướng này tiếp tục đến cuối năm 2028, AI sẽ có thể thực hiện các nhiệm vụ nghiên cứu & kỹ thuật phần mềm AI mất vài tuần cũng như nhiều chuyên gia con người.

Đường màu cam cho thấy xu hướng trong năm qua còn nhanh hơn, có lẽ do hệ hình các mô hình suy luận.

Cập nhật tháng 4 năm 2025: Sau khi bài viết này được xuất bản lần đầu, kết quả cho o3 đã được công bố và nó dường như đi theo xu hướng nhanh hơn sau năm 2024 thay vì xu hướng chậm hơn sau năm 2020 đã được thảo luận ở trên. Nếu điều này tiếp tục, thì tiến bộ sẽ nhanh gần gấp đôi: tầm nhìn thời gian tăng gấp đôi sau mỗi bốn tháng thay vì bảy tháng.

Nếu xu hướng nhanh hơn này thực sự là do việc mở rộng quy mô học tăng cường, nó có lẽ không thể tiếp tục với tốc độ gần đây trong hơn 1-2 năm, vì vậy chúng ta có thể thấy thêm 1-2 năm với thời gian nhân đôi là 4 tháng, sau đó quay trở lại xu hướng 7 tháng trước đó.

Ngoài ra, đây có thể là sự khởi đầu của một vòng lặp phản hồi tích cực, dẫn đến tiến bộ siêu cấp số nhân.

Các mô hình AI cũng đang ngày càng hiểu rõ bối cảnh của chúng — trả lời đúng các câu hỏi về kiến trúc của chính chúng, các đầu ra trong quá khứ, và liệu chúng đang được huấn luyện hay triển khai — một điều kiện tiên quyết khác cho khả năng tác tử.

Nói một cách nhẹ nhàng hơn, trong khi Claude 3.7 vẫn chơi Pokemon rất tệ, nó tốt hơn nhiều so với 3.5, và chỉ một năm trước, Claude 3 không thể chơi được chút nào.

Những biểu đồ trên giải thích tại sao, mặc dù các mô hình AI có thể rất 'thông minh' trong việc trả lời câu hỏi, chúng vẫn chưa tự động hóa được nhiều công việc.

Hầu hết các công việc không chỉ là danh sách các nhiệm vụ rời rạc kéo dài một giờ –– chúng liên quan đến việc tìm ra phải làm gì; phối hợp với một nhóm; các dự án dài, mới lạ với rất nhiều bối cảnh, v.v.

Ngay cả trong một trong những lĩnh vực mạnh nhất của AI — kỹ thuật phần mềm –– ngày nay nó chỉ có thể làm các nhiệm vụ mất dưới một giờ. Và nó vẫn thường bị vấp phải những thứ như tìm đúng nút trên một trang web. Điều này có nghĩa là nó còn một chặng đường dài mới có thể thay thế hoàn toàn các kỹ sư phần mềm.

Tuy nhiên, các xu hướng cho thấy có khả năng cao rằng điều đó sẽ sớm thay đổi. Một AI có thể làm các nhiệm vụ 1 ngày hoặc 1 tuần sẽ có thể tự động hóa nhiều công việc hơn một cách đáng kể so với các mô hình hiện tại. Các công ty có thể bắt đầu thuê hàng trăm 'nhân viên kỹ thuật số' được giám sát bởi một số ít người.

OpenAI đã đặt tên năm 2025 là “năm của các tác tử.”

Một khi các tác tử bắt đầu hoạt động một chút, điều đó sẽ mở ra nhiều tiến bộ hơn:

Thế giới là một nguồn dữ liệu vô tận, cho phép các tác tử phát triển một cách tự nhiên một mô hình nhân quả của thế giới. 33

Bất kỳ biện pháp nào trong số này cũng có thể tăng độ tin cậy một cách đáng kể, và như chúng ta đã thấy nhiều lần trong bài viết này, những cải tiến về độ tin cậy có thể đột ngột mở ra các khả năng mới:

Vì vậy, tiến bộ có thể cảm thấy khá bùng nổ.

Nói tất cả những điều này, khả năng tác tử là yếu tố không chắc chắn nhất trong bốn động lực. Chúng ta vẫn chưa có các benchmark tốt để đo lường nó, vì vậy trong khi có thể có nhiều tiến bộ trong việc điều hướng một số loại nhiệm vụ nhất định, tiến bộ có thể vẫn chậm trên các khía cạnh khác. Một vài lĩnh vực yếu kém đáng kể có thể cản trở các ứng dụng của AI. Có thể cần những đột phá cơ bản hơn để làm cho nó thực sự hoạt động.

Tuy nhiên, các xu hướng gần đây và những cải tiến nêu trên trong quá trình phát triển có nghĩa là tôi kỳ vọng sẽ thấy những tiến bộ đáng kể.

Hãy tóm tắt lại mọi thứ chúng ta đã đề cập cho đến nay. Nhìn về hai năm tới, tất cả bốn động lực của tiến bộ AI dường như sẽ tiếp tục và xây dựng dựa trên nhau:

Và đó sẽ không phải là kết thúc. Các công ty hàng đầu đang trên đà thực hiện các đợt huấn luyện trị giá 10 tỷ đô la vào năm 2028. Điều này sẽ đủ để tiền huấn luyện một mô hình nền tảng có kích thước GPT-6 và thực hiện học tăng cường gấp 100 lần (hoặc một số sự kết hợp khác). 34

Ngoài ra, các động lực mới như các mô hình suy luận xuất hiện khoảng mỗi 1–2 năm, vì vậy chúng ta nên dự kiến ít nhất một khám phá nữa như thế này trong bốn năm tới. Và có một số khả năng chúng ta có thể thấy một tiến bộ cơ bản hơn, giống như chính học sâu.

Tổng hợp tất cả những điều này lại, những người hình dung tương lai là 'những chatbot tốt hơn một chút' đang mắc sai lầm. Nếu không có một sự gián đoạn lớn, 37 tiến bộ sẽ không chững lại ở đây.

Câu hỏi trị giá hàng nghìn tỷ đô la là AI sẽ trở nên tiên tiến đến mức nào.

Cuối cùng không ai biết, nhưng một cách để có được câu trả lời chính xác hơn là ngoại suy tiến bộ trên các benchmark đo lường khả năng của AI.

Vì tất cả các động lực của tiến bộ đang tiếp tục với tốc độ tương tự như trong quá khứ, chúng ta có thể ngoại suy gần đúng tốc độ tiến bộ gần đây. 38

Đây là bản tóm tắt tất cả các benchmark chúng ta đã thảo luận (cộng với một vài benchmark khác) và chúng ta có thể kỳ vọng chúng sẽ ở đâu vào năm 2026:

Điều này ngụ ý rằng trong hai năm nữa, chúng ta nên kỳ vọng các hệ thống AI:

Bước nhảy vọt tiếp theo có thể đưa chúng ta vào khả năng giải quyết vấn đề vượt trội con người — khả năng trả lời các câu hỏi khoa học chưa được giải quyết một cách độc lập.

Nhiều nút thắt cản trở việc triển khai tác tử AI trong thế giới thực, ngay cả đối với những tác tử có thể sử dụng máy tính. Chúng bao gồm quy định, sự miễn cưỡng để AI đưa ra quyết định, độ tin cậy không đủ, sự trì trệ của các tổ chức, và thiếu sự hiện diện vật lý. 42

Ban đầu, các hệ thống mạnh mẽ cũng sẽ đắt đỏ, và việc triển khai chúng sẽ bị giới hạn bởi sức mạnh tính toán có sẵn, vì vậy chúng sẽ chỉ được hướng đến các nhiệm vụ có giá trị nhất.

Điều này có nghĩa là hầu hết nền kinh tế có lẽ sẽ tiếp tục hoạt động như bình thường trong một thời gian. Bạn vẫn sẽ tham khảo ý kiến bác sĩ con người (ngay cả khi họ sử dụng các công cụ AI), mua cà phê từ các nhân viên pha chế con người, và thuê thợ sửa ống nước con người.

Tuy nhiên, có một vài lĩnh vực quan trọng mà, bất chấp những nút thắt này, các hệ thống này có thể được triển khai nhanh chóng với những hậu quả đáng kể.

Đây là nơi AI đang được áp dụng mạnh mẽ nhất hiện nay. Google cho biết khoảng 25% mã mới của họ được viết bởi AI. Các startup của Y Combinator nói rằng con số đó là 95%, và họ đang phát triển nhanh hơn nhiều lần so với trước đây.

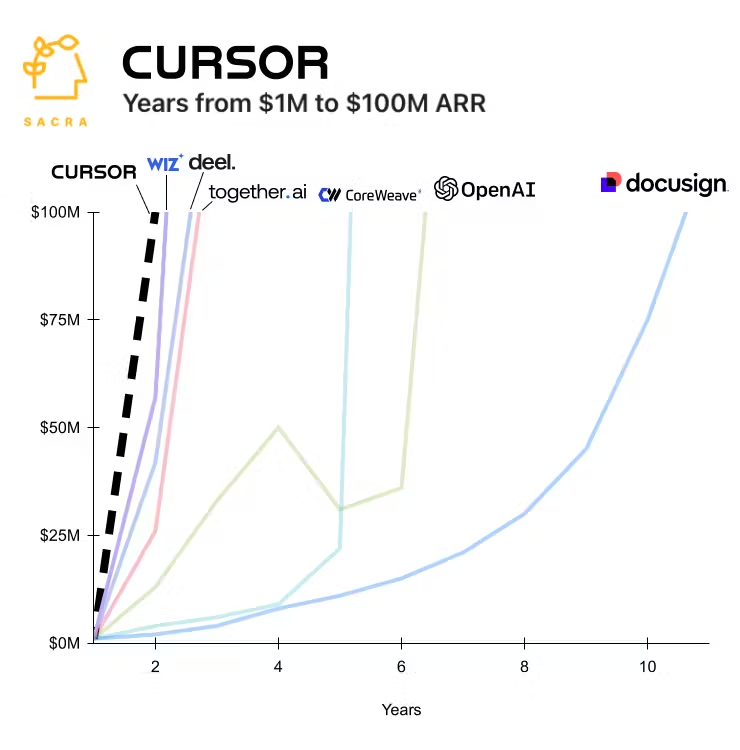

Nếu việc lập trình trở nên rẻ hơn 10 lần, chúng ta sẽ sử dụng nó nhiều hơn rất nhiều. Có lẽ không lâu nữa, chúng ta sẽ thấy các startup phần mềm trị giá hàng tỷ đô la với một số ít nhân viên con người và hàng trăm tác tử AI. Một số startup AI đã trở thành các công ty phát triển nhanh nhất mọi thời đại.

Khi OpenAI ra mắt, nó là startup phát triển nhanh nhất mọi thời đại về doanh thu. Kể từ đó, một số công ty AI khác đã phá kỷ lục, gần đây nhất là Cursor (một tác tử lập trình). Docusign, một startup SaaS thành công điển hình trước làn sóng AI, được hiển thị trên biểu đồ để so sánh. Nguồn.

Vì vậy, ứng dụng hẹp này của AI có thể tạo ra hàng trăm tỷ đô la giá trị kinh tế khá nhanh chóng — đủ để tài trợ cho việc tiếp tục mở rộng quy mô AI.

Ứng dụng của AI vào nền kinh tế có thể mở rộng đáng kể từ đó. Ví dụ, Epoch ước tính rằng có lẽ một phần ba các tác vụ công việc có thể được thực hiện từ xa thông qua máy tính, và việc tự động hóa chúng có thể làm tăng gấp đôi nền kinh tế.

Những người tạo ra AlphaFold đã giành giải Nobel vì đã thiết kế một AI giải quyết vấn đề gấp nếp protein.

Các mô hình AI cũng đã tìm thấy hàng trăm nghìn tinh thể ổn định có thể được sử dụng trong khoa học vật liệu và tạo ra các dự báo thời tiết nhanh hơn và chính xác hơn. 43 Tôi kỳ vọng sẽ có nhiều kết quả như thế này hơn nữa một khi các nhà khoa học đã điều chỉnh AI để giải quyết các vấn đề cụ thể, ví dụ bằng cách huấn luyện trên dữ liệu di truyền hoặc vũ trụ học.

Các mô hình trong tương lai có thể có những hiểu biết thực sự mới lạ chỉ bằng cách ai đó hỏi chúng. Nhưng, ngay cả khi không, rất nhiều khoa học có thể được giải quyết bằng phương pháp vét cạn. Đặc biệt, trong bất kỳ lĩnh vực nào chủ yếu là ảo nhưng có câu trả lời có thể kiểm chứng — chẳng hạn như toán học, mô hình kinh tế, vật lý lý thuyết, hoặc khoa học máy tính — nghiên cứu có thể được tăng tốc bằng cách tạo ra hàng nghìn ý tưởng và sau đó xác minh ý tưởng nào hoạt động.

Ngay cả một lĩnh vực thực nghiệm như sinh học cũng bị tắc nghẽn bởi những thứ như lập trình và phân tích dữ liệu, những hạn chế có thể được giảm bớt đáng kể.

Một phát minh duy nhất như vũ khí hạt nhân có thể thay đổi tiến trình lịch sử, vì vậy tác động của bất kỳ sự tăng tốc nào ở đây cũng có thể rất kịch tính.

Một lĩnh vực đặc biệt dễ bị tăng tốc là chính nghiên cứu AI. Ngoài việc hoàn toàn ảo, đây là lĩnh vực mà các nhà nghiên cứu AI hiểu rõ nhất, có động lực lớn để tự động hóa, và không gặp rào cản nào trong việc triển khai AI.

Ban đầu, điều này sẽ trông giống như các nhà nghiên cứu sử dụng các tác tử AI 'cấp thực tập sinh' để gỡ rối cho họ trong các nhiệm vụ cụ thể hoặc năng lực kỹ thuật phần mềm (vốn là một nút thắt lớn), hoặc thậm chí giúp động não ý tưởng.

Sau đó, nó có thể trông giống như việc cho các mô hình đọc tất cả tài liệu, tạo ra hàng nghìn ý tưởng để cải thiện các thuật toán, và tự động kiểm tra chúng trong các thí nghiệm quy mô nhỏ.

Một mô hình AI đã tạo ra một bài báo nghiên cứu AI được chấp nhận tại một hội thảo hội nghị. Đây là một danh sách các cách khác mà AI đã được áp dụng vào nghiên cứu AI.

Với tất cả những điều này, có thể chúng ta sẽ có các tác tử AI thực hiện nghiên cứu AI trước khi mọi người tìm ra tất cả các khúc mắc cho phép AI thực hiện hầu hết các công việc từ xa.

Do đó, ứng dụng kinh tế rộng rãi của AI không nhất thiết là một cách tốt để đánh giá tiến bộ AI — nó có thể theo sau một cách bùng nổ sau khi các khả năng của AI đã tiến bộ đáng kể.

Đây là lập luận phản biện mạnh nhất theo quan điểm của mình.

Đầu tiên, thừa nhận rằng AI có khả năng sẽ trở nên siêu phàm trong các nhiệm vụ rời rạc, được định nghĩa rõ ràng, điều đó có nghĩa là chúng ta sẽ thấy sự tiến bộ nhanh chóng liên tục trên các benchmark.

Nhưng hãy lập luận rằng nó sẽ vẫn kém trong các nhiệm vụ được định nghĩa kém, đòi hỏi bối cảnh cao, và có tầm nhìn thời gian dài.

Đó là bởi vì các loại nhiệm vụ này không có câu trả lời có thể kiểm chứng rõ ràng và nhanh chóng, và do đó chúng không thể được huấn luyện bằng học tăng cường, và chúng cũng không có trong dữ liệu huấn luyện.

Điều đó có nghĩa là tốc độ tiến bộ đối với các loại nhiệm vụ này sẽ chậm, và thậm chí có thể đạt đến một điểm chững.

Nếu bạn cũng lập luận rằng vị trí xuất phát của nó yếu, thì ngay cả sau 4-6 năm tiến bộ nữa, nó vẫn có thể kém. Dữ liệu của METR cho thấy AI không thể hoàn thành nhiều tác vụ sử dụng máy tính mà con người thấy rất dễ làm trong vài phút, đặc biệt là ở độ tin cậy cao, và nó vẫn còn tệ hơn một đứa trẻ 7 tuổi khi chơi Pokemon.

Thứ hai, lập luận rằng hầu hết các công việc tri thức đều bao gồm đáng kể các nhiệm vụ dài hạn, lộn xộn, đòi hỏi bối cảnh cao này.

Ví dụ, các kỹ sư phần mềm dành rất nhiều thời gian để tìm ra những gì cần xây dựng, phối hợp với những người khác, và hiểu các cơ sở mã khổng lồ thay vì chỉ hoàn thành một danh sách các nhiệm vụ được định nghĩa rõ ràng. Ngay cả khi năng suất lập trình của họ tăng 10 lần, nếu lập trình chỉ chiếm 50% công việc của họ, năng suất tổng thể của họ chỉ tăng gần gấp đôi.

Một ví dụ điển hình về một nhiệm vụ lộn xộn, được định nghĩa kém là có những hiểu biết khái niệm mới lạ, vì vậy bạn có thể lập luận rằng nhiệm vụ này, vốn đặc biệt quan trọng để mở khóa một sự tăng tốc, có khả năng là khó tự động hóa nhất (trái ngược với những người khác nghĩ rằng nghiên cứu AI có thể dễ tự động hóa hơn nhiều công việc khác).

Trong kịch bản này, chúng ta sẽ có những trợ lý AI cực kỳ thông minh và hiểu biết, và có lẽ là một sự tăng tốc trong một số lĩnh vực ảo hạn chế (có lẽ như nghiên cứu toán học), nhưng chúng sẽ vẫn là công cụ, và con người sẽ vẫn là nút thắt kinh tế & khoa học chính.

Các nhà nghiên cứu AI con người sẽ thấy năng suất của họ tăng lên nhưng không đủ để bắt đầu một vòng lặp phản hồi tích cực – tiến bộ AI sẽ vẫn bị tắc nghẽn bởi những hiểu biết mới lạ, sự phối hợp của con người, và sức mạnh tính toán.

Những giới hạn này, kết hợp với các vấn đề trong việc tìm kiếm một mô hình kinh doanh và các rào cản khác đối với việc triển khai AI, sẽ có nghĩa là các mô hình sẽ không tạo ra đủ doanh thu để biện minh cho các đợt huấn luyện trên 10 tỷ đô la. Điều đó sẽ có nghĩa là tiến bộ sẽ chậm lại đáng kể sau khoảng năm 2028. 44 Một khi tiến bộ chậm lại, biên lợi nhuận trên các mô hình tiên phong sẽ sụp đổ, làm cho việc trả tiền cho nhiều đợt huấn luyện hơn càng khó khăn hơn.

Lập luận phản bác chính là biểu đồ trước đó từ METR: các mô hình đang cải thiện trong việc hành động trong các tầm nhìn dài hơn, điều này đòi hỏi sự hiểu biết bối cảnh sâu hơn và xử lý các nhiệm vụ trừu tượng, phức tạp hơn. Việc dự phóng xu hướng này về phía trước cho thấy các mô hình tự chủ hơn nhiều trong vòng bốn năm.

Điều này có thể đạt được thông qua nhiều tiến bộ gia tăng mà mình đã phác thảo, 45 nhưng cũng có khả năng chúng ta sẽ thấy một sự đổi mới cơ bản hơn phát sinh — bộ não con người chứng minh rằng những khả năng như vậy là có thể.

Hơn nữa, các nhiệm vụ tầm nhìn dài có thể được chia nhỏ thành các nhiệm vụ ngắn hơn (ví dụ: lập kế hoạch, thực hiện bước đầu tiên, v.v.). Nếu AI trở nên đủ giỏi trong các nhiệm vụ ngắn hơn, thì các nhiệm vụ tầm nhìn dài có thể nhanh chóng bắt đầu hoạt động.

Đây có lẽ là câu hỏi trung tâm của việc dự báo AI hiện nay: liệu tầm nhìn mà các AI có thể hành động sẽ chững lại hay tiếp tục cải thiện?

Đây là một số cách khác mà tiến bộ AI có thể chậm hơn hoặc không ấn tượng:

Để khám phá sâu hơn về quan điểm hoài nghi, hãy xem “Liệu chúng ta có đang trên bờ vực của AGI không?” của Steve Newman, “Lời hứa của các mô hình suy luận” của Matthew Barnnett, “Một kịch bản bi quan: Dự đoán của tôi về tiến bộ AI,” của Thane Ruthenis, và podcast Dwarkesh với Epoch AI.

Cuối cùng, bằng chứng sẽ không bao giờ mang tính quyết định một chiều hay chiều khác, và các ước tính sẽ dựa trên các phán đoán mà mọi người có thể khác nhau một cách hợp lý. Tuy nhiên, tôi thấy khó có thể nhìn vào bằng chứng mà không đặt xác suất đáng kể vào việc AGI xuất hiện trước năm 2030.

Tôi đã đưa ra một số tuyên bố lớn. Là một người không chuyên, sẽ rất tuyệt nếu có các chuyên gia có thể cho chúng ta biết nên nghĩ gì.

Thật không may, không có. Chỉ có các nhóm khác nhau, với những nhược điểm khác nhau.

Tôi đã xem xét quan điểm của các nhóm chuyên gia khác nhau này trong một bài viết riêng.

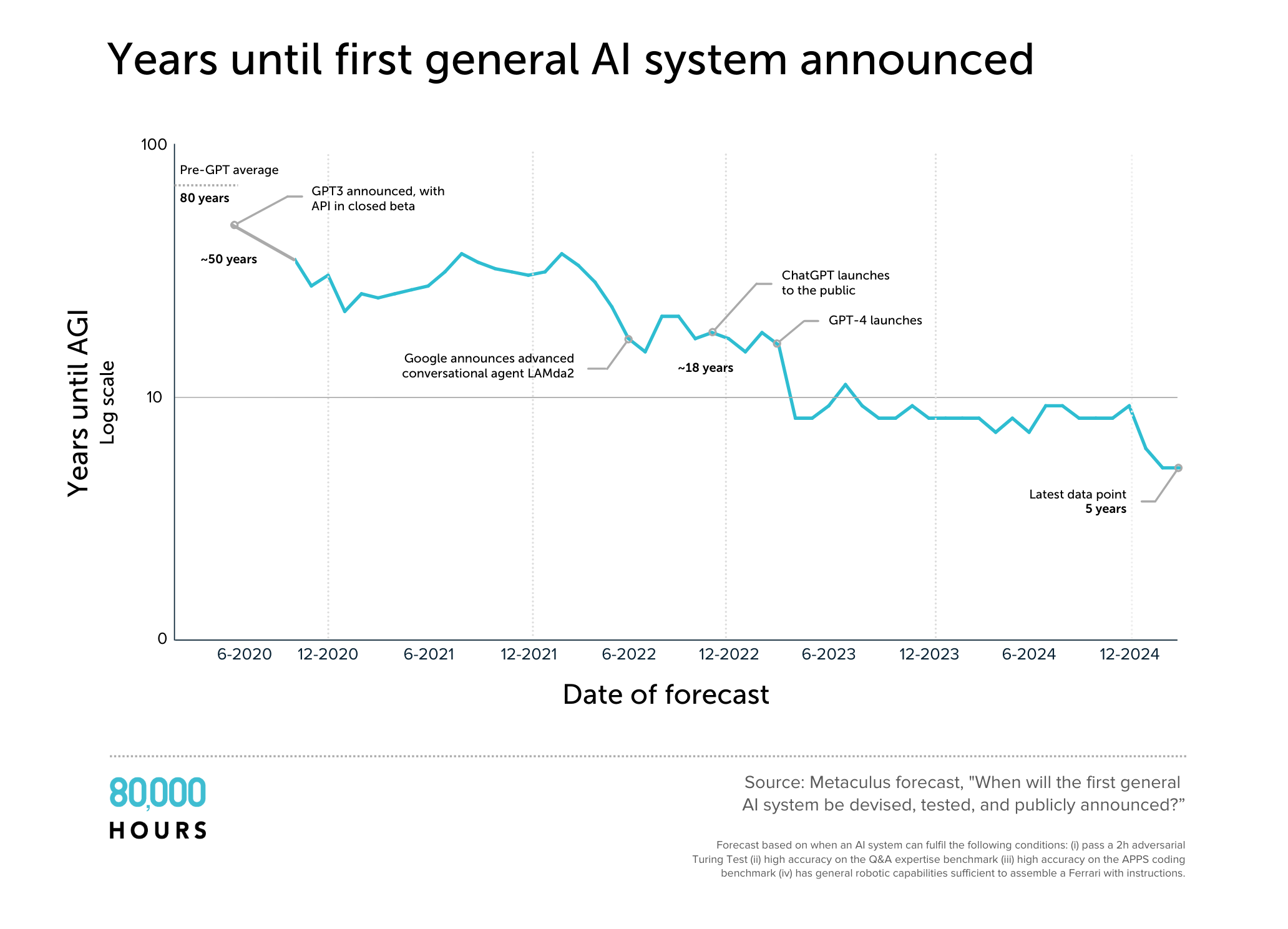

Một điểm nổi bật là mọi nhóm đều đã rút ngắn đáng kể các ước tính của mình. Ngày nay, ngay cả nhiều người 'hoài nghi' về AI cũng nghĩ rằng AGI sẽ đạt được trong 20 năm nữa – giữa sự nghiệp của sinh viên đại học ngày nay.

Trong bốn năm, ước tính trung bình trên Metaculus về thời điểm AGI sẽ được phát triển đã giảm mạnh từ 50 năm xuống còn 5 năm. Có những vấn đề với định nghĩa được sử dụng, nhưng biểu đồ phản ánh một mô hình giảm ước tính rộng hơn.

Đánh giá chung của tôi là AGI vào năm 2030 nằm trong phạm vi quan điểm của chuyên gia, vì vậy việc bác bỏ nó là 'khoa học viễn tưởng' là không chính đáng. Thật vậy, những người biết nhiều nhất về công nghệ dường như có các mốc thời gian ngắn nhất.

Tất nhiên, nhiều chuyên gia nghĩ rằng sẽ mất nhiều thời gian hơn. Nhưng nếu 30% chuyên gia nghĩ rằng một chiếc máy bay sẽ phát nổ, và 70% còn lại nghĩ rằng nó sẽ ổn, với tư cách là người không chuyên, chúng ta không nên kết luận rằng nó chắc chắn sẽ không xảy ra. Nếu một cái gì đó không chắc chắn, điều đó không có nghĩa là nó sẽ không xảy ra.

Việc cho rằng vì chúng ta không biết khi nào AGI sẽ xuất hiện, nó có thể đến sớm, vào những năm 2030, 2040, v.v. là điều tự nhiên.

Mặc dù đó là một quan điểm phổ biến, tôi không chắc nó đúng.

Các động lực cốt lõi của tiến bộ AI là nhiều sức mạnh tính toán hơn và các thuật toán tốt hơn.

AI mạnh hơn có nhiều khả năng được khám phá nhất khi sức mạnh tính toán và lao động được sử dụng để cải thiện AI đang tăng trưởng một cách ấn tượng nhất.

Ngay bây giờ, tổng sức mạnh tính toán có sẵn để huấn luyện và chạy AI đang tăng 3 lần mỗi năm, 46 và lực lượng lao động cũng đang tăng nhanh.

Điều này có nghĩa là mỗi năm, số lượng mô hình AI có thể chạy tăng 3 lần. Ngoài ra, có thể sử dụng sức mạnh tính toán gấp ba lần cho việc huấn luyện, và việc huấn luyện đó có thể sử dụng các thuật toán tốt hơn, điều đó có nghĩa là chúng trở nên có năng lực hơn cũng như nhiều hơn về số lượng.

Trước đó, tôi đã lập luận rằng những xu hướng này có thể tiếp tục cho đến năm 2028. Nhưng bây giờ tôi sẽ chỉ ra rằng nó rất có thể sẽ gặp phải các nút thắt ngay sau đó.

Đầu tiên, tiền bạc:

Ngay cả khi có sẵn tiền, cũng sẽ có các nút thắt như:

Vì vậy, rất có thể, tốc độ tăng trưởng của sức mạnh tính toán sẽ chậm lại vào khoảng năm 2028–2032.

Tiến bộ thuật toán cũng đang rất nhanh chóng ngay bây giờ, nhưng khi mỗi khám phá được thực hiện, khám phá tiếp theo trở nên ngày càng khó hơn. Việc duy trì tốc độ tiến bộ không đổi đòi hỏi một lực lượng nghiên cứu tăng trưởng theo cấp số nhân.

Năm 2021, OpenAI có khoảng 300 nhân viên; ngày nay, họ có khoảng 3.000. Anthropic và DeepMind cũng đã tăng trưởng hơn 3 lần, và các công ty mới đã tham gia. Số lượng bài báo về ML được sản xuất mỗi năm đã tăng gần gấp đôi sau mỗi hai năm. 51

Khó để biết chính xác cách định nghĩa lực lượng lao động của những người thực sự đang thúc đẩy các năng lực (so với việc bán sản phẩm hoặc thực hiện các nghiên cứu ML khác). Nhưng nếu lực lượng lao động cần tăng gấp đôi sau mỗi 1–3 năm, điều đó chỉ có thể kéo dài cho đến khi nguồn nhân tài cạn kiệt. 52

Đánh giá của tôi là tăng trưởng có thể dễ dàng tiếp tục cho đến cuối thập kỷ nhưng có lẽ sẽ bắt đầu chậm lại vào đầu những năm 2030 (trừ khi AI đã trở nên đủ tốt để thay thế các nhà nghiên cứu AI vào lúc đó).

Tiến bộ thuật toán cũng phụ thuộc vào việc tăng sức mạnh tính toán, điều này cho phép nhiều thí nghiệm hơn. Với đủ sức mạnh tính toán, các nhà nghiên cứu thậm chí có thể tiến hành tìm kiếm vét cạn các thuật toán tối ưu. Do đó, việc làm chậm tăng trưởng sức mạnh tính toán sẽ tương ứng làm chậm tiến bộ thuật toán.

Nếu sức mạnh tính toán và hiệu quả thuật toán chỉ tăng 50% hàng năm thay vì 3 lần, một bước nhảy vọt tương đương với bước nhảy từ GPT-3 đến GPT-4 sẽ mất hơn 14 năm thay vì 2,5.

Nó cũng làm giảm xác suất khám phá ra một hệ hình AI mới.

Vì vậy, có một cuộc chạy đua:

Thời điểm quyết định sẽ là khoảng năm 2028–2032.

Hoặc là tiến bộ chậm lại, hoặc chính AI sẽ vượt qua những nút thắt này, cho phép tiến bộ tiếp tục hoặc thậm chí tăng tốc.

Nếu AI có khả năng đóng góp vào nghiên cứu AI không đạt được trước năm 2028–2032, xác suất hàng năm để khám phá ra nó sẽ giảm đáng kể.

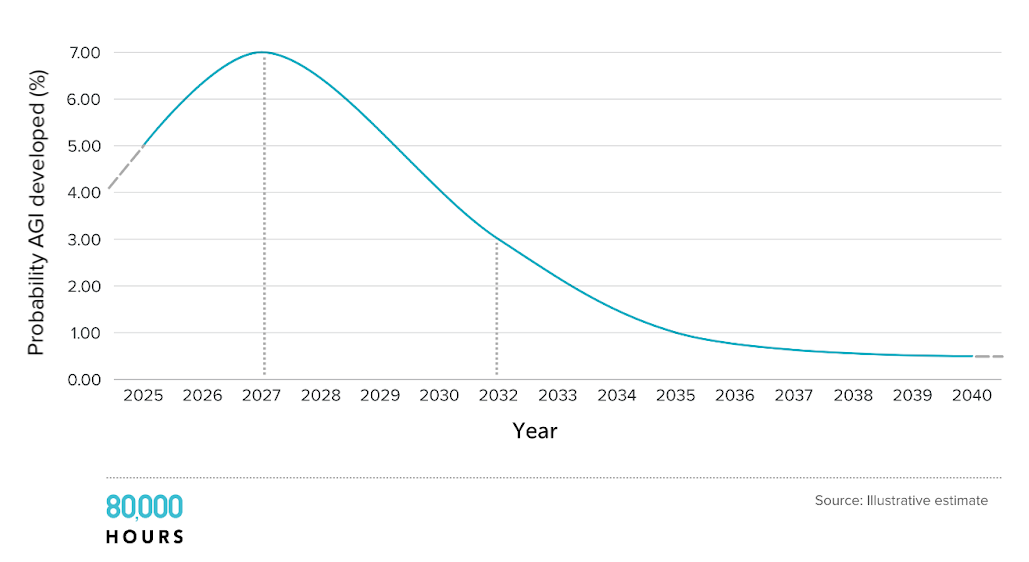

Tiến bộ sẽ không đột ngột dừng lại — nó sẽ chậm lại dần dần. Dưới đây là một số ước tính minh họa về xác suất đạt được AGI (đừng trích dẫn các con số chính xác!):

Rất gần đúng, chúng ta có thể lên kế hoạch cho hai kịch bản: 53

Chúng ta sẽ biết nhiều hơn về kịch bản nào chúng ta đang ở trong vài năm tới.

Tôi gần như nghĩ về các kịch bản này là 50:50 — mặc dù tôi có thể thay đổi từ 30% đến 80% tùy thuộc vào ngày.

Các kịch bản hỗn hợp cũng có thể xảy ra – việc mở rộng quy mô có thể chậm lại dần dần, hoặc bị trì hoãn vài năm do xung đột Đài Loan, đẩy 'AGI' vào đầu những năm 30. Nhưng việc bắt đầu với một mô hình đơn giản là hữu ích.

Các con số bạn đặt cho mỗi kịch bản cũng phụ thuộc vào định nghĩa của bạn về AGI và những gì bạn nghĩ sẽ mang tính chuyển đổi. Tôi quan tâm nhất đến việc dự báo AI có thể đóng góp một cách có ý nghĩa vào nghiên cứu AI. 54 AGI theo nghĩa là một mô hình có thể thực hiện gần như tất cả các công việc từ xa rẻ hơn một con người có thể sẽ mất nhiều thời gian hơn do một chuỗi dài các nút thắt. Mặt khác, AGI theo nghĩa là 'tốt hơn hầu hết mọi người trong việc suy luận khi được cho một giờ' dường như về cơ bản đã ở đây rồi.

Vậy chúng ta sẽ có AGI vào năm 2030 chứ?

Dù định nghĩa chính xác là gì, bằng chứng đáng kể hỗ trợ khả năng này — chúng ta có thể chỉ cần duy trì các xu hướng hiện tại trong vài năm nữa.

Chúng ta sẽ không bao giờ có bằng chứng quyết định một chiều hay chiều khác, nhưng đối với tôi, việc nghĩ rằng xác suất trước năm 2030 dưới 10% là rõ ràng quá tự tin.

Với những tác động to lớn và rủi ro nghiêm trọng, có đủ bằng chứng để xem xét khả năng này một cách cực kỳ nghiêm túc.

Tình hình ngày nay giống như tháng 2 năm 2020 ngay trước khi các lệnh phong tỏa vì COVID: một xu hướng rõ ràng cho thấy sự thay đổi lớn, sắp xảy ra, nhưng hầu hết mọi người vẫn tiếp tục cuộc sống của họ như bình thường.

Trong một bài viết sắp tới, tôi sẽ lập luận rằng AGI tự động hóa phần lớn công việc từ xa và làm tăng gấp đôi nền kinh tế có thể là một kết quả thận trọng.

Nếu AI có thể thực hiện nghiên cứu AI, khoảng cách giữa AGI và 'siêu trí tuệ' có thể rất ngắn.

Điều này có thể kích hoạt một sự mở rộng lớn lực lượng nghiên cứu, có khả năng mang lại tiến bộ khoa học của một thế kỷ trong chưa đầy một thập kỷ. Robot, kỹ thuật sinh học, và định cư không gian đều có thể đến sớm hơn nhiều so với dự đoán thông thường.

5 năm tới sẽ là sự khởi đầu của một trong những giai đoạn then chốt nhất trong lịch sử.