Mô hình nền tảng là gì? Mô hình nền tảng đại diện cho một sự thay đổi cơ bản trong cách chúng ta phát triển trí tuệ nhân tạo. Thay vì xây dựng các mô hình chuyên biệt cho nhiều tác vụ nhỏ cụ thể, chúng ta hiện có thể đào tạo các mô hình quy mô lớn làm nền tảng cho nhiều ứng dụng khác nhau. Các mô hình này sau đó được chuyên biệt hóa thông qua quá trình gọi là tinh chỉnh để thực hiện các tác vụ cụ thể. Hãy tưởng tượng điều này tương tự như cách chúng ta có thể xây dựng nhiều loại tòa nhà khác nhau bằng cùng một cấu trúc nền tảng (Bommasani et al., 2022). Chúng ta có thể xây dựng ngân hàng, nhà hàng hoặc nhà ở, nhưng cấu trúc nền tảng cơ bản vẫn giữ nguyên. Đây chỉ là một định nghĩa trực quan đơn giản. Chúng ta sẽ đi sâu vào chi tiết hơn trong các phần tiếp theo về đào tạo, đặc tính và rủi ro.

Tại sao mô hình nền tảng lại ra đời? Phương pháp truyền thống là đào tạo các mô hình AI chuyên biệt cho từng tác vụ thường tỏ ra kém hiệu quả và hạn chế. Sự phát triển bị cản trở bởi nhu cầu về dữ liệu được con người gắn nhãn và khả năng chuyển giao kiến thức giữa các tác vụ một cách hiệu quả. Các mô hình nền tảng đã vượt qua những hạn chế này thông qua quá trình học tự giám sát trên các tập dữ liệu khổng lồ không được gắn nhãn. Sự đột phá này xảy ra do nhiều lý do khác nhau - sự phát triển của phần cứng chuyên dụng như GPU, các kiến trúc học máy mới như transformer, và việc tiếp cận ngày càng dễ dàng với lượng dữ liệu trực tuyến khổng lồ (Kaplan et al., 2020) là một số lý do nổi bật cho sự chuyển đổi này.

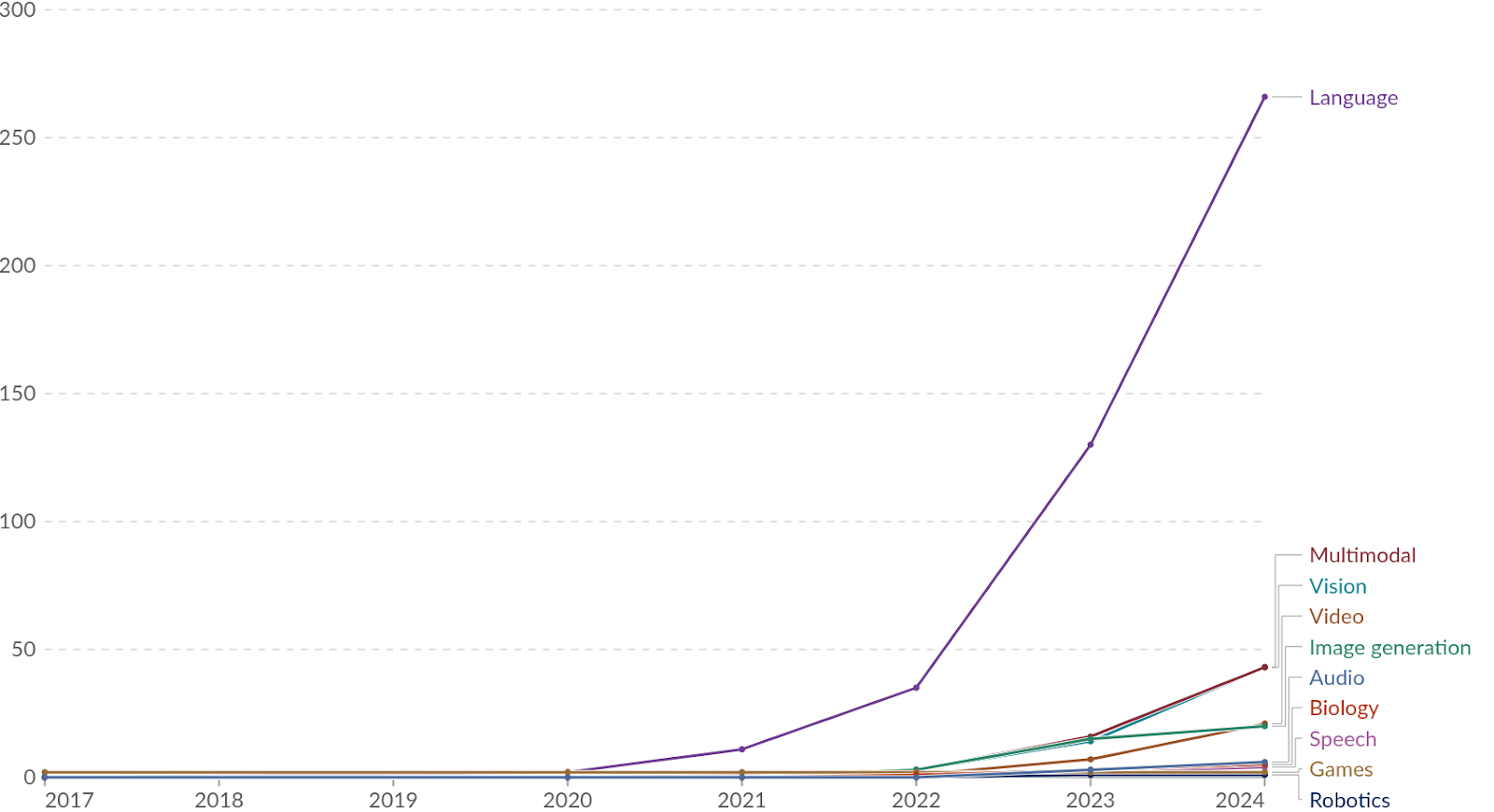

Ví dụ về các mô hình nền tảng là gì? Trong xử lý ngôn ngữ, các mô hình như GPT-4 và Claude là ví dụ về mô hình nền tảng. Cả hai đều đã chứng minh khả năng tạo ra ngôn ngữ con người, tham gia vào các cuộc trò chuyện phức tạp và thực hiện các tác vụ suy luận đơn giản (OpenAI, 2023). Các ví dụ trong xử lý hình ảnh bao gồm các mô hình như DALL-E 3 và Stable Diffusion. (Betker et al., 2023) Đây là các ví dụ cụ thể cho từng lĩnh vực, nhưng chúng ta cũng đang chứng kiến xu hướng hướng tới các mô hình nền tảng đa phương tiện (LMMs). Điều này bao gồm các mô hình như GPT-4V và Gemini có thể hoạt động trên nhiều loại dữ liệu khác nhau - xử lý và tạo ra văn bản, hình ảnh, mã nguồn, âm thanh và có thể nhiều hơn nữa trong tương lai (Google, 2023). Ngay cả trong học tăng cường, nơi các mô hình truyền thống được đào tạo cho các tác vụ cụ thể, chúng ta đang chứng kiến các mô hình nền tảng như Gato thể hiện khả năng học các hành vi chung có thể được điều chỉnh cho các tác vụ hạ lưu khác nhau. (Reed et al., 2022)

<iframe-static-figure>

Tại sao các mô hình nền tảng lại quan trọng đối với an toàn AI? Lý do chúng ta bắt đầu cẩm nang này bằng việc thảo luận về các mô hình nền tảng là vì chúng đánh dấu sự chuyển đổi sang các hệ thống đa năng, thay vì các hệ thống chuyên biệt hẹp. Sự chuyển đổi này mang lại nhiều rủi ro mới mà trước đây không tồn tại. Những rủi ro này bao gồm rủi ro lợi dụng sai mục đích từ việc tập trung hóa, đồng nhất hóa và năng lực lưỡng dụng, chỉ để kể tên một vài ví dụ. Khả năng của các mô hình nền tảng trong việc học các năng lực rộng và có thể chuyển giao đã dẫn đến sự xuất hiện của các hành vi ngày càng phức tạp từ các mục tiêu đào tạo tương đối đơn giản (Wei et al., 2022). Các năng lực phức tạp, tổ hợp với tính tổng quát và việc mở rộng quy mô, có nghĩa là chúng ta cần nghiêm túc xem xét các rủi ro an toàn vượt ra ngoài việc lợi dụng sai mục đích, vốn trước đây dường như chỉ là lý thuyết hoặc xa vời. Ngoài rủi ro lợi dụng sai mục đích, các vấn đề như mất căn chỉnh đang trở thành mối quan ngại ngày càng tăng với mỗi khả năng mới mà các mô hình nền tảng này thể hiện. Chúng tôi dành hẳn một chương để thảo luận về các rủi ro này. Tuy nhiên, chúng tôi cũng sẽ cung cấp cho bạn một cái nhìn sơ lược về các loại rủi ro có thể xảy ra trong các phần tiếp theo, vì điều này xứng đáng được nhắc lại.

Sự khác biệt giữa mô hình nền tảng và mô hình tiên phong là gì? Mô hình tiên phong đại diện cho đỉnh cao của năng lực AI - chúng là các mô hình tiên tiến nhất trong lĩnh vực tương ứng. Mặc dù nhiều mô hình tiên phong cũng là mô hình nền tảng (như Claude 3.5 Sonnet), điều này không phải lúc nào cũng đúng. Ví dụ, AlphaFold, mặc dù là mô hình tiên phong trong dự đoán cấu trúc protein, thường không được coi là mô hình nền tảng vì nó được chuyên biệt hóa cho một tác vụ duy nhất thay vì làm nền tảng chung cho nhiều ứng dụng (Jumper et al., 2021).

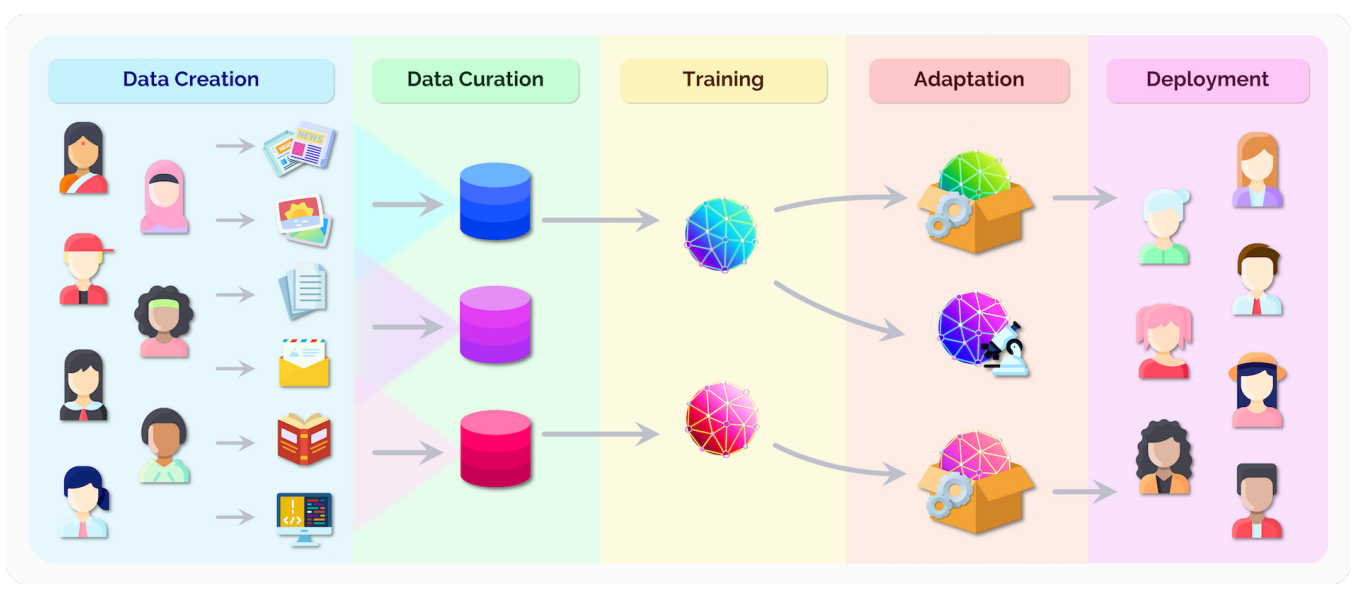

Mô hình nền tảng được đào tạo khác với các hệ thống AI truyền thống như thế nào? Một trong những đổi mới chính của mô hình nền tảng là phương pháp đào tạo của chúng. Thông thường, mô hình nền tảng sử dụng quy trình đào tạo hai giai đoạn. Đầu tiên, chúng trải qua giai đoạn đào tạo trước (pre-training), sau đó có thể được điều chỉnh thông qua các cơ chế như tinh chỉnh (fine-tuning) hoặc khung hỗ trợ (scaffolding) để thực hiện các tác vụ cụ thể. Thay vì học từ các ví dụ được con người gắn nhãn cho các tác vụ cụ thể, các mô hình này học bằng cách tìm kiếm các mẫu trong lượng lớn dữ liệu không được gắn nhãn.

Đào tạo ban đầu là gì? Đào tạo ban đầu là giai đoạn ban đầu mà mô hình học các mẫu và kiến thức chung từ các tập dữ liệu khổng lồ gồm hàng triệu hoặc hàng tỷ ví dụ. Trong giai đoạn này, mô hình không được đào tạo cho bất kỳ tác vụ cụ thể nào - thay vào đó, nó phát triển các năng lực rộng lớn có thể được chuyên môn hóa sau này. Tính tổng quát này vừa mạnh mẽ vừa đáng lo ngại từ góc độ an toàn. Trong khi nó cho phép mô hình thích ứng với nhiều tác vụ khác nhau, nó cũng có nghĩa là chúng ta không thể dễ dàng dự đoán hoặc kiểm soát những gì mô hình có thể học để làm (Hendrycks et al., 2022).

Làm thế nào học tự giám sát cho phép tiền huấn luyện? Học tự giám sát (SSL) là sự đổi mới kỹ thuật chính khiến các mô hình nền tảng trở nên khả thi. Đây là cách chúng ta thực hiện giai đoạn tiền huấn luyện. Khác với học có giám sát truyền thống, yêu cầu dữ liệu được con người gắn nhãn, SSL tận dụng cấu trúc nội tại của chính dữ liệu để tạo ra tín hiệu huấn luyện. Ví dụ, thay vì gắn nhãn hình ảnh một cách thủ công, chúng ta có thể che một phần của hình ảnh đã có sẵn và yêu cầu mô hình dự đoán phần còn lại. Ví dụ, mô hình có thể dự đoán nửa dưới của hình ảnh dựa trên nửa trên, học về các đối tượng thường xuất hiện cùng nhau. Ví dụ, nó có thể học rằng các hình ảnh có cây và cỏ ở phần trên thường có nhiều cỏ hơn, hoặc có thể là một con đường, ở phần dưới. Nó học về các đối tượng và bối cảnh của chúng - cây và cỏ thường xuất hiện trong công viên, chó thường được tìm thấy trong môi trường này, đường thường nằm ngang, và v.v. Các biểu diễn được học này sau đó có thể được sử dụng cho nhiều tác vụ mà mô hình không được đào tạo cụ thể, như nhận diện chó trong hình ảnh hoặc nhận biết công viên - tất cả mà không cần nhãn do con người cung cấp! Khái niệm tương tự áp dụng cho ngôn ngữ, mô hình có thể dự đoán từ tiếp theo trong câu, chẳng hạn "Con mèo ngồi trên...", học ngữ pháp, cú pháp và bối cảnh miễn là chúng ta lặp lại quá trình này trên lượng văn bản khổng lồ.

Fine-tuning là gì? Sau khi huấn luyện ban đầu, các mô hình nền tảng có thể được điều chỉnh thông qua hai phương pháp chính: fine-tuning và tạo câu lệnh. Fine-tuning bao gồm huấn luyện bổ sung trên một tác vụ hoặc tập dữ liệu cụ thể để chuyên môn hóa năng lực của mô hình. Ví dụ, chúng ta có thể sử dụng Học tăng cường từ phản hồi của con người (RLHF) để cải thiện khả năng tuân theo hướng dẫn hoặc trở nên hữu ích hơn của các mô hình ngôn ngữ. Tạo câu lệnh, mặt khác, liên quan đến việc cung cấp cho mô hình các đầu vào được thiết kế cẩn thận để hướng dẫn nó đạt được hành vi mong muốn mà không cần đào tạo thêm.

Tại sao quá trình đào tạo này lại quan trọng đối với an toàn AI? Quá trình đào tạo của các mô hình nền tảng tạo ra nhiều thách thức an toàn độc đáo. Thứ nhất, bản chất tự giám sát của quá trình đào tạo trước có nghĩa là chúng ta có ít kiểm soát đối với những gì mô hình học được - nó có thể phát triển năng lực hoặc hành vi không mong muốn. Thứ hai, quá trình điều chỉnh cần phải duy trì đáng tin cậy các thuộc tính an toàn mà chúng ta đã thiết lập trong quá trình đào tạo trước. Cuối cùng, quy mô khổng lồ của dữ liệu đào tạo và khả năng điện toán khiến việc hiểu rõ hoặc kiểm toán những gì mô hình đã học trở nên khó khăn. Nhiều thách thức an toàn mà chúng ta sẽ thảo luận trong cẩm nang này - từ tổng quát lệch mục tiêu đến giám sát mở rộng quy mô - đều có liên quan sâu sắc đến cách các mô hình này được đào tạo và thích ứng.

Tại sao chúng ta cần hiểu các tính chất của các mô hình nền tảng? Ngoài việc hiểu quá trình đào tạo, chúng ta cũng cần hiểu các đặc điểm định nghĩa chính hoặc năng lực của các mô hình này. Các tính chất này thường quyết định cả năng lực và rủi ro tiềm ẩn của các hệ thống này. Chúng giúp giải thích tại sao các mô hình nền tảng đặt ra những thách thức an toàn độc đáo so với các hệ thống AI truyền thống. Khả năng chuyển giao kiến thức, tổng quát hóa qua nhiều lĩnh vực khác nhau và phát triển các khả năng phát sinh có nghĩa là chúng ta không thể dựa vào các phương pháp an toàn truyền thống giả định hành vi hẹp và có thể dự đoán được.

Chuyển giao học là gì? Chuyển giao học là một trong những đặc tính cơ bản nhất của các mô hình nền tảng - khả năng chuyển giao kiến thức được học trong quá trình đào tạo ban đầu sang các tác vụ và lĩnh vực mới. Thay vì bắt đầu từ đầu cho mỗi tác vụ, chúng ta có thể tận dụng kiến thức chung mà các mô hình này đã tích lũy (Bommasani et al., 2022). Đặc tính này cho phép thích ứng và triển khai nhanh chóng, nhưng cũng có nghĩa là cả năng lực và rủi ro an toàn có thể chuyển giao theo những cách không mong đợi. Ví dụ, một mô hình có thể chuyển giao không chỉ kiến thức hữu ích mà còn cả các thành kiến có hại hoặc hành vi không mong muốn sang các ứng dụng mới.

Zero-shot và few-shot learning là gì? Khả năng có hiệu suất cao trong việc thực hiện các tác vụ mới với rất ít ví dụ, thậm chí không có ví dụ nào. Ví dụ, GPT-4 có thể giải quyết các vấn đề suy luận mới chỉ từ mô tả bằng ngôn ngữ tự nhiên của tác vụ (OpenAI, 2023). Khả năng tổng quát hóa sang các tình huống mới này rất mạnh mẽ nhưng đáng lo ngại từ góc độ an toàn. Nếu các mô hình có thể thích ứng với các tình huống mới theo những cách không mong đợi, việc dự đoán và kiểm soát hành vi của chúng trong quá trình triển khai sẽ trở nên khó khăn hơn.

Khả năng tổng quát hóa trong các mô hình nền tảng hoạt động khác biệt so với các hệ thống AI truyền thống. Thay vì chỉ tổng quát hóa trong một lĩnh vực hẹp, các mô hình này có thể tổng quát hóa năng lực của mình qua các lĩnh vực khác nhau theo những cách bất ngờ. Tuy nhiên, quá trình tổng quát hóa năng lực này thường diễn ra mà không kèm theo sự tổng quát hóa tương ứng về mục tiêu hoặc ràng buộc - một vấn đề an toàn quan trọng mà chúng ta sẽ phân tích chi tiết trong chương về tổng quát lệch mục tiêu. Ví dụ, một mô hình có thể tổng quát hóa khả năng thao tác văn bản theo những cách không mong đợi mà không duy trì các ràng buộc an toàn mà chúng ta đã định (Hendrycks et al., 2022).

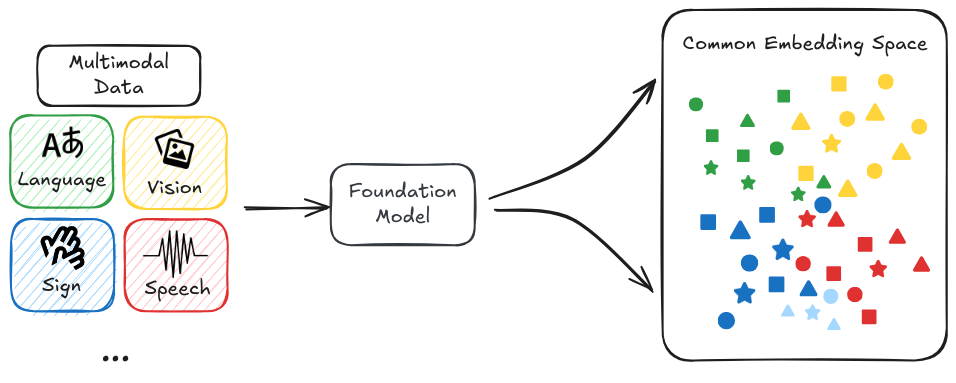

Đa phương tiện là gì? Các mô hình có thể xử lý nhiều loại dữ liệu (văn bản, hình ảnh, âm thanh, video) cùng lúc. Điều này không chỉ đơn thuần là xử lý các loại dữ liệu khác nhau. Mô tả chính xác hơn là chúng có thể thiết lập kết nối giữa các phương tiện theo cách phức tạp (Google, 2023). Từ góc độ an toàn, đa phương tiện mang lại thách thức mới vì nó mở rộng cách mô hình tương tác và ảnh hưởng đến thế giới. Một sự cố an toàn trong một phương tiện có thể biểu hiện qua phương tiện khác theo những cách không mong đợi.