*Chương này là chương phụ lục của chương 1. Bạn có thể sang thẳng chương 2 tại đây.

Các mô hình ngôn ngữ lớn (LLMs) hiện tại, mặc dù được đào tạo trên lượng dữ liệu khổng lồ, vẫn còn xa mới hoàn hảo.

Liệu những vấn đề này có tiếp tục tồn tại trong các phiên bản tương lai hay sẽ biến mất? Phần này phân tích các phê phán chính đối với các mô hình đó và cố gắng xác định xem chúng có còn hợp lệ đối với các LLMs trong tương lai hay không.

Loại đánh giá định tính này rất quan trọng để xác định liệu LLMs có phải là con đường khả thi nhất để đạt được Trí tuệ Nhân tạo Tổng quát (AGI) hay không.

LLMs có thể sáng tạo không? Sự sáng tạo của LLMs thường được tranh luận, nhưng có những dấu hiệu rõ ràng cho thấy AI, về nguyên tắc, có năng lực thực hiện các quá trình sáng tạo theo nhiều cách khác nhau:

LLMs có phải quá chậm trong việc học hỏi không? Các lập luận chống lại các mô hình ngôn ngữ dựa trên transformer thường cho rằng chúng quá kém hiệu quả về mẫu dữ liệu, và rằng LLMs cực kỳ chậm trong việc học các khái niệm mới so với con người. Để cải thiện hiệu suất trong các tác vụ hoặc tình huống mới, thường được cho rằng LLMs cần được đào tạo trên lượng dữ liệu khổng lồ — hàng triệu lần nhiều hơn so với con người cần. Tuy nhiên, có một xu hướng ngày càng tăng về hiệu quả dữ liệu, và niềm tin ngày càng lớn rằng điều này có thể được cải thiện đáng kể trong các mô hình tương lai.

EfficientZero là một tác nhân học tăng cường vượt qua hiệu suất trung bình của con người trên bộ 26 trò chơi Atari sau chỉ hai giờ trải nghiệm thời gian thực cho mỗi trò chơi (Ye et al., 2021; Wang et al., 2024). Đây là một cải thiện đáng kể so với các thuật toán trước đó, cho thấy tiềm năng nhảy vọt trong hiệu quả dữ liệu. Lợi ích ở đây không chỉ là học tập hiệu quả hơn mà còn tiềm năng thích ứng nhanh chóng và thành thạo trong các tác vụ mới, tương tự như tốc độ học tập của trẻ em. EfficientZero không phải là mô hình ngôn ngữ lớn (LLM), nhưng nó cho thấy rằng học sâu có thể được tối ưu hóa về mặt hiệu quả.

Định luật mở rộng quy mô cho thấy các mô hình AI lớn hơn thường hiệu quả hơn về dữ liệu, cần ít dữ liệu hơn để đạt được mức hiệu suất tương đương với các mô hình nhỏ hơn. Các nghiên cứu như "Language Models are Few-Shot Learners" (Brown et al., 2020) và bằng chứng cho thấy các mô hình lớn hơn dường như cần ít dữ liệu hơn để đạt được cùng mức hiệu suất (Kaplan et al., 2020), cho thấy rằng khi mô hình mở rộng quy mô, chúng trở nên thành thạo hơn với ít ví dụ hơn. Xu hướng này cho thấy tương lai AI có thể nhanh chóng thích ứng và học từ dữ liệu hạn chế, thách thức quan niệm rằng AI vốn dĩ là những học viên chậm chạp so với con người.

Các mô hình ngôn ngữ lớn (LLMs) có khả năng chống chịu với sự thay đổi phân phối không? Mặc dù đúng là AI chưa đạt được độ bền tối đa, ví dụ như có thể đạt hiệu suất hoàn hảo sau khi phân phối thay đổi, nhưng đã có tiến bộ đáng kể:

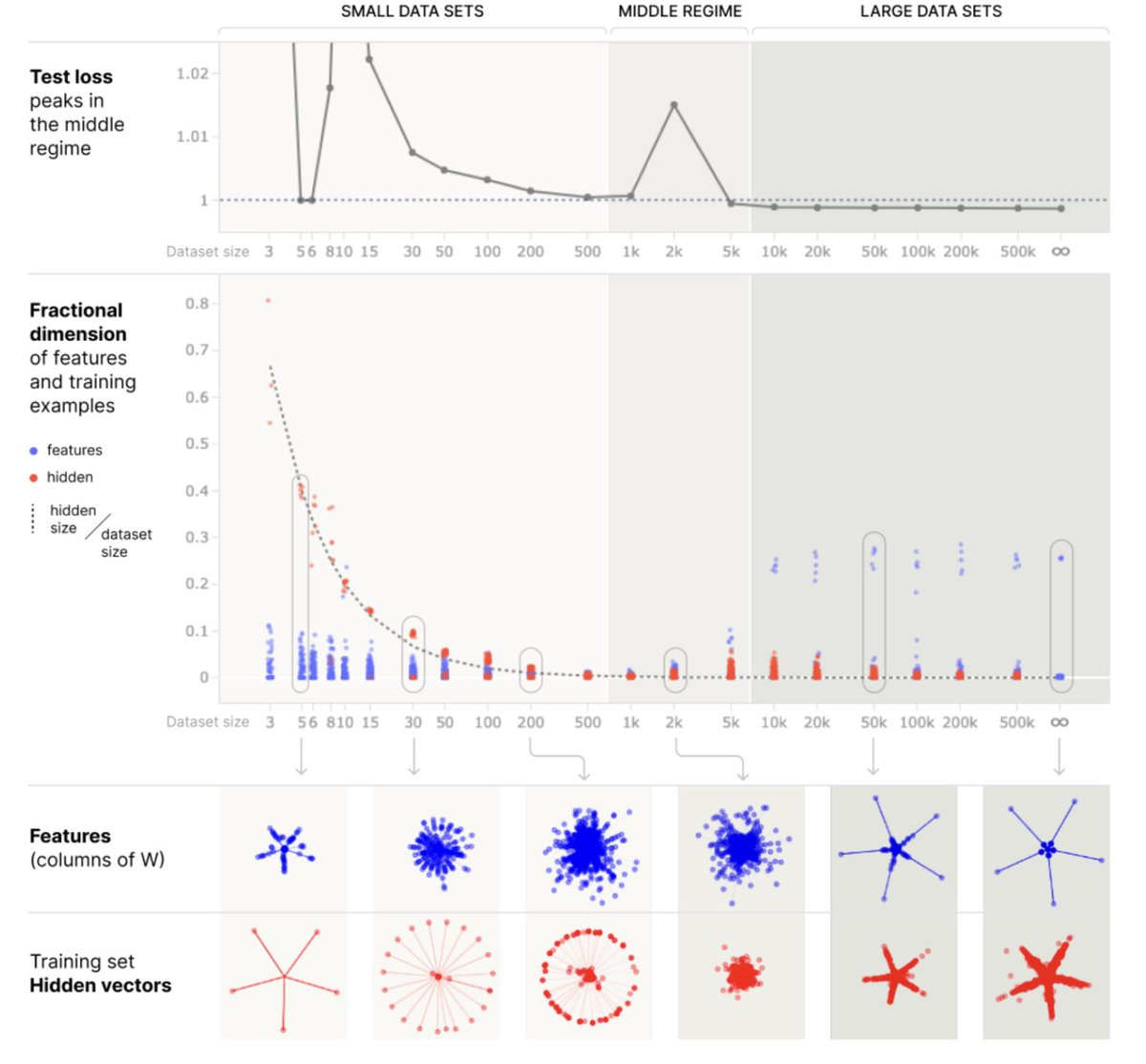

Chim vẹt ngẫu nhiên: Liệu AI chỉ ghi nhớ thông tin mà không thực sự nén nó? Có hai cách đại diện thông tin điển hình trong một mô hình ngôn ngữ lớn (LLM): hoặc ghi nhớ từng điểm một, giống như một bảng tra cứu, hoặc nén thông tin bằng cách chỉ ghi nhớ các đặc trưng cấp cao hơn, mà chúng ta có thể gọi là "mô hình thế giới". Điều này được giải thích trong bài báo quan trọng "Superposition, Memorization, and Double Descent" (Anthropic, 2023): hóa ra để lưu trữ các điểm, ban đầu mô hình học vị trí của tất cả các điểm (ghi nhớ thuần túy), sau đó, nếu tăng số lượng điểm, mô hình bắt đầu nén kiến thức này, và mô hình giờ đây có năng lực tổng quát hóa (và thực hiện một mô hình đơn giản của dữ liệu)

Thật không may, quá ít người hiểu rõ sự khác biệt giữa việc ghi nhớ và hiểu biết. Đây không phải là một câu hỏi cao siêu như ‘hệ thống có mô hình thế giới nội tại không?’, mà là một sự khác biệt về hành vi rất thực tiễn: ‘hệ thống có năng lực tổng quát hóa rộng rãi hay chỉ giới hạn ở tổng quát hóa cục bộ?’

Francois Chollet, Nhà nghiên cứu AI hàng đầu

Từ Siêu vị trí, Ghi nhớ và Sự suy giảm kép (Anthropic, 2023)

Trí tuệ nhân tạo (AI) có năng lực nén thông tin, thường theo cách có liên quan. Ví dụ, khi phân tích các biểu diễn của các từ đại diện cho màu sắc trong các mô hình ngôn ngữ lớn (LLMs) như "đỏ" và "xanh dương", cấu trúc được tạo thành từ tất cả các embedding của những màu sắc đó tạo ra vòng tròn màu chính xác (Điều này sử dụng một phép chiếu phi tuyến tính như T-distributed stochastic neighbor embedding (T-SNE) để chiếu từ không gian đa chiều xuống mặt phẳng 2D). Các ví dụ khác về mô hình thế giới được trình bày trong bài báo "Eight Things to Know about mô hình ngôn ngữ lớn" (Bowman, 2023).

Tất nhiên, có những lĩnh vực khác mà AI giống như một bảng tra cứu, nhưng đây là một phổ, và mỗi trường hợp nên được xem xét riêng biệt. Ví dụ, đối với "liên kết sự thật", bài báo "Locating and Editing Factual Associations in GPT" cho thấy cấu trúc dữ liệu cơ bản của GPT-2 giống như một bảng tra cứu (Meng et al., 2023), nhưng bài báo "Đại diện tuyến tính phát sinh trong các mô hình thế giới của các mô hình trình tự tự giám sát" cho thấy một mô hình GPT nhỏ có năng lực học được một mô hình thế giới nén của OthelloGpt. (Nanda et al., 2023) Có thêm các ví dụ trong phần dành riêng cho các mô hình thế giới trong bài báo "Tám điều cần biết về các mô hình ngôn ngữ lớn" (Bowman, 2023).

Rõ ràng là các mô hình ngôn ngữ lớn (LLMs) đang nén các biểu diễn của mình ít nhất một phần. Nhiều ví dụ về năng lực ấn tượng được trình bày trong công trình "Giả thuyết Con vẹt ngẫu nhiên là đáng tranh cãi đối với thế hệ LLMs gần đây nhất", cho thấy rằng điều này không thể chỉ là việc ghi nhớ thuần túy. (Feuillade-Montixi & Peigné, 2023)

LLMs có không thể tránh khỏi việc "ảo giác"?

LLMs có xu hướng "ảo giác", một thuật ngữ dùng để mô tả việc tạo ra nội dung vô nghĩa hoặc sai sự thật khi phản hồi các tạo câu lệnh cụ thể. Vấn đề này, được nhấn mạnh trong các nghiên cứu như "On Faithfulness and Factuality in Abstractive Summarization" của Maynez et al. (Maynez et al., 2020) và "TruthfulQA: Measuring How mô hình Mimic Human Falsehoods" của Lin et al. (Lin et al., 2022), đặt ra thách thức đáng kể. Tuy nhiên, điều quan trọng là nhận ra rằng những thách thức này được dự đoán do cách thiết lập đào tạo và có thể được giảm thiểu:

Nhiều kỹ thuật có thể được sử dụng để tăng độ chính xác của LLMs

Điều chỉnh mô hình ngôn ngữ lớn (LLM) cho độ chính xác: Trong bài báo này (Tian et al., 2023), các tác giả đề xuất sử dụng phương pháp tối ưu hóa sở thích trực tiếp (DPO) để giảm tỷ lệ ảo giác. Bằng cách áp dụng các kỹ thuật này, mô hình Llama 2 7B đã giảm 58% tỷ lệ lỗi sự thật so với mô hình gốc.

Retrieval Augmented Generation (RAG). Phương pháp này hoạt động bằng cách kết hợp quá trình tra cứu thông tin thực tế (tra cứu, tương tự như tìm kiếm trên Google) và sau đó sử dụng thông tin đó để hướng dẫn phản hồi của AI (sinh ra, dựa trên tài liệu đã tra cứu). Bằng cách này, AI được định hướng chặt chẽ hơn vào thực tế, giảm khả năng tạo ra nội dung phi thực tế hoặc sai lệch. Nói cách khác, đây giống như việc cung cấp cho AI một thư viện tham khảo để kiểm tra sự thật trong quá trình học và phản hồi, đảm bảo đầu ra của nó được dựa trên thực tế. Phương pháp này đặc biệt hữu ích trong bối cảnh học tập trong ngữ cảnh, nơi AI học từ thông tin và ngữ cảnh được cung cấp trong mỗi tương tác.

Các kỹ thuật tạo câu lệnh trong AI đã phát triển để bao gồm các phương pháp phức tạp như

Đào tạo dựa trên quy trình đảm bảo rằng các hệ thống quen với việc mô tả suy nghĩ của mình chi tiết hơn và không thể bỏ qua quá nhiều bước suy luận. Ví dụ, xem bài báo "Cải thiện suy luận toán học với giám sát quy trình" của OpenAI (Lightman et al., 2023).

Đào tạo về metacognition: Các mô hình có thể được đào tạo để đưa ra xác suất của những gì chúng khẳng định, một hình thức của metacognition. Ví dụ, bài báo "Language Models (Mostly) Know What They Know" (Kadavath et al., 2022) cho thấy rằng các hệ thống AI có thể được hiệu chỉnh Bayesian về kiến thức của mình. Điều này ngụ ý rằng chúng có thể có một hình thức nhận thức bản thân sơ khai, nhận ra khả năng chính xác của chính mình. Một cách không chính thức, điều này có nghĩa là có thể hỏi một chatbot "Bạn có chắc chắn về những gì bạn đang nói với tôi không?" và nhận được một phản hồi tương đối đáng tin cậy. Điều này có thể được sử dụng để đào tạo chống lại ảo giác.

Đáng chú ý là các kỹ thuật này giúp giảm thiểu đáng kể các vấn đề hiện tại của các mô hình ngôn ngữ lớn (LLMs), nhưng chúng không giải quyết được tất cả các vấn đề tiềm ẩn liên quan đến AI có thể gây nhầm lẫn, như chúng ta sẽ thấy trong chương về tổng quát lệch mục tiêu.

Các mô hình ngôn ngữ lớn (LLMs) có thiếu Hệ thống 2 không? Hệ thống 1 và Hệ thống 2 là các thuật ngữ được nhà kinh tế học Daniel Kahneman phổ biến trong cẩm nang "Thinking, Fast and Slow", mô tả hai cách khác nhau mà não bộ của chúng ta hình thành suy nghĩ và đưa ra quyết định. Hệ thống 1 nhanh, tự động và trực quan; đây là phần tư duy của chúng ta xử lý các quyết định và phán đoán hàng ngày mà không cần nhiều nỗ lực hay suy nghĩ có ý thức. Ví dụ, khi bạn nhận ra một khuôn mặt hoặc hiểu các câu đơn giản, bạn thường sử dụng Hệ thống 1. Ngược lại, Hệ thống 2 chậm hơn, có tính suy luận và logic hơn. Nó tiếp quản khi bạn giải quyết một vấn đề phức tạp, đưa ra một lựa chọn có ý thức hoặc tập trung vào một nhiệm vụ khó khăn. Nó đòi hỏi nhiều năng lượng hơn và được kiểm soát chặt chẽ hơn, xử lý các nhiệm vụ như lập kế hoạch cho tương lai, kiểm tra tính hợp lý của một lập luận phức tạp hoặc bất kỳ hoạt động nào đòi hỏi sự tập trung sâu sắc. Cùng nhau, hai hệ thống này tương tác và ảnh hưởng đến cách chúng ta suy nghĩ, đưa ra phán đoán và quyết định, nhấn mạnh sự phức tạp của tư duy và hành vi con người.

Một vấn đề quan trọng là liệu các mô hình ngôn ngữ lớn (LLMs) có thể mô phỏng các quá trình của Hệ thống 2 hay không, những quá trình này liên quan đến suy nghĩ chậm hơn, có chủ đích hơn và logic hơn. Một số lập luận lý thuyết về giới hạn độ sâu trong các mô hình transformer cho thấy chúng không thể chia nhỏ các số nguyên lớn một cách nội bộ (Delétang et al., 2023). Tuy nhiên, điều này không phản ánh thực tế: GPT-4 có năng lực giải thích các phép tính từng bước và đạt được kết quả mong đợi thông qua chuỗi suy luận hoặc sử dụng các công cụ như trình thông dịch mã.

Sự phát triển của nhận thức siêu việt. Các chức năng mới trong các mô hình ngôn ngữ lớn (LLMs), như kỹ thuật Reflexion (Shinn et al., 2023), cho phép các mô hình này phân tích lại và cải thiện câu trả lời của mình. Có thể yêu cầu mô hình ngôn ngữ lớn (LLM) lùi lại một bước, đặt câu hỏi về tính chính xác của các hành động trước đó và xem xét các cách để cải thiện câu trả lời trước đó. Điều này nâng cao đáng kể năng lực của GPT-4, cải thiện năng lực của nó và làm cho chúng phù hợp hơn với các hoạt động của Hệ thống 2 của con người. Lưu ý rằng kỹ thuật này là mới nổi và không hoạt động tốt với các mô hình trước đó.

Các kết quả này cho thấy sự mờ nhạt giữa hai hệ thống này. Các quá trình của Hệ thống 2 có thể bản chất là sự kết hợp của nhiều quá trình Hệ thống 1, xuất hiện chậm hơn do liên quan đến nhiều bước và tương tác với các hình thức bộ nhớ chậm hơn. Quan điểm này tương tự cách các mô hình ngôn ngữ hoạt động, với mỗi bước trong quá trình Hệ thống 1 tương đương với một bước thực thi trong thời gian cố định trong các mô hình như GPT. Mặc dù các mô hình này gặp khó khăn trong việc chủ động phối hợp các bước để giải quyết vấn đề phức tạp, việc chia nhỏ tác vụ thành các bước nhỏ hơn (Least-to-most prompting) hoặc kích thích suy luận từng bước (Chain-of-Thought (CoT) prompting) sẽ cải thiện đáng kể hiệu suất của chúng.

Liệu các mô hình ngôn ngữ lớn (LLMs) có thiếu mô hình thế giới nội tại? Khái niệm "mô hình thế giới" trong AI không nhất thiết phải bị giới hạn trong việc mã hóa rõ ràng trong kiến trúc. Trái với các phương pháp như H-JEPA (LeCun, 2022), đề xuất một mô hình thế giới rõ ràng để nâng cao quá trình đào tạo AI, có bằng chứng ngày càng tăng cho thấy mô hình thế giới có thể được mã hóa một cách ngầm định. Khái niệm này đặc biệt rõ ràng trong học tăng cường (RL), nơi sự phân biệt giữa RL dựa trên mô hình và RL không dựa trên mô hình có thể gây hiểu lầm. Ngay cả trong RL không dựa trên mô hình, các thuật toán thường mã hóa ngầm một dạng mô hình thế giới quan trọng cho hiệu suất tối ưu.

LLMs có thể học liên tục và có trí nhớ dài hạn không? Học liên tục và quản lý hiệu quả trí nhớ dài hạn là những thách thức lớn trong lĩnh vực AI nói chung.

Quên lãng thảm khốc. Một rào cản quan trọng trong lĩnh vực này là hiện tượng quên đột ngột, khi một mạng thần kinh, sau khi học thông tin mới, có xu hướng quên hoàn toàn thông tin đã học trước đó. Vấn đề này là trọng tâm của các nghiên cứu đang diễn ra, nhằm phát triển các hệ thống AI có thể duy trì và phát triển kiến thức theo thời gian. Ví dụ, nếu chúng ta đào tạo một AI trên một trò chơi Atari, sau khi kết thúc đợt đào tạo thứ hai, AI có thể đã quên cách chơi trò chơi đầu tiên. Đây là một ví dụ về hiện tượng quên đột ngột.

Nhưng giả sử chúng ta huấn luyện một hệ thống AI lớn trên nhiều trò chơi Atari cùng lúc, thậm chí thêm một số văn bản từ Internet và một số tác vụ Công nghệ robot. Điều này có thể hoạt động. Ví dụ, hệ thống AI GATO minh họa quá trình huấn luyện này và thể hiện điều mà chúng ta gọi là "lợi ích của việc mở rộng quy mô", tức là những điều không thể thực hiện được trong quy mô nhỏ có thể trở nên khả thi trong quy mô lớn.

Các kỹ thuật khác đang được phát triển để giải quyết vấn đề trí nhớ dài hạn, ví dụ, các phương pháp dựa trên khung hỗ trợ (scaffolding) cũng đã được áp dụng để đạt được trí nhớ dài hạn và học tập liên tục trong AI. Khung hỗ trợ trong AI đề cập đến việc sử dụng các cấu trúc được lập trình sẵn bởi con người, bao gồm vòng lặp for để liên tục truy vấn mô hình:

Cần lưu ý rằng bộ nhớ dài hạn dựa trên khung hỗ trợ (scaffold-based) không được coi là giải pháp tối ưu, và những người theo chủ nghĩa thuần túy sẽ ưa chuộng việc sử dụng chính các trọng số của hệ thống làm bộ nhớ dài hạn.

Lập kế hoạch

Lập kế hoạch là một lĩnh vực mà các hệ thống AI hiện đang gặp khó khăn, nhưng đã có tiến bộ đáng kể. Một số phương pháp, như những phương pháp dựa trên khung hỗ trợ, cho phép phân chia nhiệm vụ và chia nhỏ mục tiêu thành các mục tiêu con nhỏ hơn, dễ đạt được hơn.

Hơn nữa, bài báo "Voyager: Một tác nhân có khả năng thích ứng mở rộng với mô hình ngôn ngữ lớn" cho thấy có thể sử dụng GPT-4 cho lập kế hoạch bằng ngôn ngữ tự nhiên trong Minecraft (Wang et al., 2023).

Có vẻ như có một số điểm tương đồng giữa các mô hình ngôn ngữ lớn (LLMs) và vỏ não ngôn ngữ:

Dưới đây là một số lý do để tin rằng các phòng thí nghiệm sẽ tiếp tục mở rộng quy mô LLMs.

Định luật mở rộng quy mô trên LLM ngụ ý những cải thiện chất lượng tiếp theo. Các định luật mở rộng quy mô ban đầu có thể không ấn tượng. Tuy nhiên, việc liên kết các chỉ số định lượng này có thể dẫn đến cải thiện chất lượng thuật toán. Một thuật toán đạt được mức tổn thất gần như hoàn hảo là thuật toán cần thiết phải hiểu rõ mọi chi tiết tinh tế và thể hiện khả năng thích ứng lớn. Việc các định luật mở rộng quy mô không bị bẻ cong là rất quan trọng và có nghĩa là chúng ta có thể làm cho mô hình trở thành một nhà suy luận chất lượng cao hơn.

Từ các mối quan hệ đơn giản đến sự hiểu biết. Trong quá trình đào tạo, GPTs tiến từ các mối quan hệ cơ bản đến sự hiểu biết ngày càng sâu sắc. Ban đầu, mô hình chỉ thiết lập mối liên kết giữa các từ liên tiếp. Dần dần, nó phát triển sự hiểu biết về ngữ pháp và ngữ nghĩa, tạo ra các liên kết giữa các câu và sau đó giữa các đoạn văn. Cuối cùng, GPT nắm bắt được những tinh tế trong phong cách viết.

Bài tập: Định luật mở rộng quy mô trên LLM ngụ ý những cải thiện chất lượng tiếp theo

Hãy tính toán sự khác biệt về tổn thất, được đo bằng bit, giữa hai đầu ra của mô hình: "Janelle ăn một ít kem vì anh ấy thích những thứ ngọt ngào như kem." và "Janelle ăn một ít kem vì cô ấy thích những thứ ngọt ngào như kem." Câu này chứa khoảng hai mươi token. Nếu mô hình dao động giữa "Anh ấy" hoặc "Cô ấy", chọn ngẫu nhiên (tỷ lệ 50/50), nó sẽ chịu tổn thất 2 bit trên token đại từ khi sai. Tổn thất cho các token khác vẫn giữ nguyên trong cả hai mô hình. Tuy nhiên, vì mô hình chỉ sai một nửa số lần, cần áp dụng hệ số 1/2. Điều này dẫn đến sự chênh lệch (1/2) * (2/20) = 1/20, tức 0,05 bit. Do đó, một mô hình có mức tổn thất nằm trong khoảng 0,05 bit so với mức tổn thất lý thuyết tối thiểu có năng lực hiểu được các khái niệm phức tạp hơn so với mô hình được đề cập ở trên.

Hoàn thành văn bản có thể là một bài kiểm tra AI-complete (Wikipedia, 2022).

Các mô hình ngôn ngữ lớn (LLMs) hiện tại chỉ có số lượng tham số tương đương với số synapse của các loài động vật có vú nhỏ, không có gì ngạc nhiên khi chúng vẫn còn chưa hoàn hảo. Các mô hình như GPT-4, dù lớn hơn nhiều so với các mô hình khác, vẫn có việc mở rộng quy mô tương đối khiêm tốn so với kích thước của não người. Để minh họa, mô hình GPT-3 lớn nhất có số lượng tham số tương đương với số synapse của một con nhím. Chúng ta không thực sự biết GPT-4 có bao nhiêu tham số, nhưng nếu nó có kích thước tương tự như PALM (có 512 tỷ tham số), thì GPT-4 chỉ có số tham số tương đương với số synapse của một con chinchilla. Trong khi đó, vỏ não mới của con người chứa khoảng 140 nghìn tỷ synapse, tức là hơn 200 lần số synapse của một con chinchilla. Để thảo luận chi tiết hơn về so sánh này, xem bài thảo luận liên quan tại đây. Để thảo luận về số lượng tham số cần thiết để mô phỏng một synapse, xem bài thảo luận về các điểm neo sinh học.

GPT-4 vẫn rẻ hơn hàng trăm lần so với các dự án khoa học lớn khác: Mặc dù chi phí đào tạo các mô hình lớn rất cao, nhưng những bước nhảy vọt đáng kể trong năng lực AI do việc mở rộng quy mô mang lại đã biện minh cho những chi phí này. Ví dụ, GPT-4 đắt hơn so với các mô hình ML khác. Nó được cho là tốn 50 triệu USD để đào tạo. Nhưng Dự án Manhattan tốn 25 tỷ USD, gấp 500 lần mà không tính đến lạm phát, và việc đạt được trí tuệ ngang tầm con người có thể quan trọng hơn về mặt kinh tế so với việc đạt được bom nguyên tử.

Tổng hợp lại, những điểm này ủng hộ quan điểm rằng Trí tuệ Nhân tạo Tổng quát (AGI) có thể đạt được chỉ bằng cách mở rộng quy mô các thuật toán hiện tại.