Trước khi thảo luận về các kịch bản rủi ro cụ thể, chúng ta cần một khung khổ cho phép đánh giá vị trí của chúng trên phổ rủi ro. Phân loại rủi ro bản chất là đa chiều; không có phân loại "tốt nhất" duy nhất. Chúng tôi đã chọn phân chia rủi ro thành hai yếu tố - "tại sao rủi ro xảy ra" (nguyên nhân) và "rủi ro có thể nghiêm trọng đến mức nào" (mức độ nghiêm trọng). Các khung phân tích bổ sung khác như phân loại rủi ro của MIT tiếp cận các khía cạnh như "ai gây ra chúng" (con người so với hệ thống AI), "khi nào chúng xuất hiện" (phát triển so với triển khai) hoặc "liệu kết quả có được dự định hay không" (Slattery et al., 2024). Phương pháp phân tích của chúng tôi chỉ là một trong nhiều cách tiếp cận có thể, nhưng các rủi ro chúng ta sẽ thảo luận thường xuất hiện phổ biến trong các khung phân tích khác.

Chúng tôi phân loại rủi ro từ AI theo trách nhiệm nguyên nhân để hiểu các điểm can thiệp. Chúng tôi chia rủi ro dựa trên ai hoặc cái gì chịu trách nhiệm chính: con người sử dụng AI như một công cụ (lợi dụng sai mục đích), hệ thống AI tự nó hành động bất thường (mất căn chỉnh), hoặc các tác động phát sinh từ tương tác phức tạp của hệ thống (hệ thống). Cách tiếp cận nguyên nhân này giúp xác định nơi can thiệp có thể hiệu quả nhất.

Nhiều rủi ro từ AI trong thực tế tổ hợp nhiều con đường nguyên nhân hoặc hoàn toàn kháng cự việc phân loại rõ ràng. Phân tích hơn 1.600 rủi ro từ AI được ghi chép cho thấy nhiều rủi ro không phù hợp hoàn toàn với bất kỳ danh mục nào (Slattery et al., 2024). Các rủi ro liên quan đến tương tác giữa con người và AI kết hợp sự mất căn chỉnh cá nhân với rủi ro hệ thống. Rủi ro đa tác nhân nảy sinh từ việc các hệ thống AI tương tác theo cách không mong đợi. Một số kịch bản liên quan đến các hiệu ứng dây chuyền, nơi lợi dụng sai mục đích cho phép mất căn chỉnh, hoặc áp lực hệ thống làm trầm trọng thêm các sự cố cá nhân. Chúng tôi đã chọn phân tích nguyên nhân để giải thích, nhưng cần lưu ý rằng sẽ có sự trùng lặp, và tương lai có thể chứa đựng sự kết hợp của các rủi ro từ nhiều nguyên nhân khác nhau.

Rủi ro từ AI trải rộng trên một phổ từ tổn hại cá nhân đến các mối đe dọa có thể làm tê liệt vĩnh viễn văn minh nhân loại. Hiểu rõ mức độ nghiêm trọng giúp ưu tiên nguồn lực hạn chế và điều chỉnh phản ứng của chúng ta đối với các loại rủi ro khác nhau. Thay vì coi tất cả rủi ro từ AI là quan trọng như nhau, chúng ta có thể phân loại chúng theo phạm vi và mức độ nghiêm trọng để xác định những rủi ro cần được ưu tiên xử lý ngay lập tức so với những rủi ro cần chuẩn bị lâu dài.

Rủi ro cá nhân và địa phương ảnh hưởng đến cá nhân hoặc cộng đồng cụ thể nhưng vẫn nằm trong phạm vi giới hạn. Cơ sở dữ liệu Sự cố AI ghi nhận hơn 1.000 trường hợp thực tế mà các hệ thống AI đã gây ra hoặc suýt gây ra thiệt hại (McGregor, 2020; Cơ sở dữ liệu Sự cố AI, 2025). Các trường hợp này bao gồm tai nạn xe tự lái, thiên vị thuật toán trong tuyển dụng hoặc cho vay gây bất lợi cho cá nhân cụ thể, vi phạm quyền riêng tư do hệ thống AI rò rỉ dữ liệu cá nhân, hoặc thao túng thông qua các chiến dịch thông tin sai lệch có mục tiêu. Rủi ro địa phương có thể liên quan đến sự cố hệ thống AI làm gián đoạn quản lý giao thông của thành phố hoặc gây ra mất điện trong khu vực. Những rủi ro này đã gây ra thiệt hại ngay lập tức, được ghi nhận cho từ hàng nghìn đến hàng trăm nghìn người.

Số lượng sự cố và tranh cãi liên quan đến trí tuệ nhân tạo (AI) được báo cáo hàng năm trên toàn cầu. Các sự cố đáng chú ý bao gồm video "deepfake" về Tổng thống Ukraine Volodymyr Zelenskyy đầu hàng, và việc các nhà tù Mỹ sử dụng AI để giám sát các cuộc gọi của tù nhân. (Giattino et al., 2023).

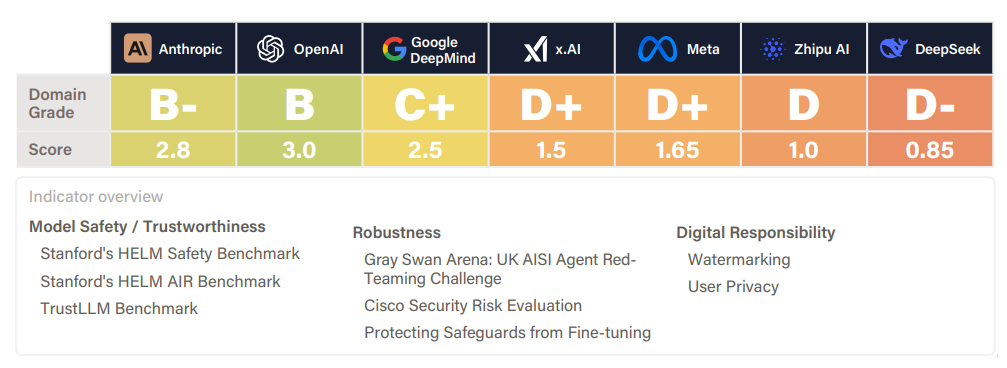

Báo cáo chỉ số an toàn AI cho mùa hè 2025. Các điểm số này thuộc danh mục "tác hại hiện tại" và thể hiện mức độ hiệu quả của các mô hình AI từ các công ty khác nhau trong việc giảm thiểu tác hại hiện tại. Điều này bao gồm các yếu tố như hiệu suất so sánh an toàn, khả năng chống lại các cuộc tấn công đối kháng, đánh dấu nội dung do AI tạo ra, và cách xử lý dữ liệu người dùng (FLI, 2025).

Rủi ro thảm họa đe dọa các quần thể lớn nhưng cho phép phục hồi sau này. Khi số người bị ảnh hưởng bởi rủi ro đạt khoảng 10% dân số toàn cầu và trở nên phổ biến hơn về mặt địa lý, chúng được gọi là rủi ro thảm họa toàn cầu. Các ví dụ lịch sử bao gồm Đại dịch Hắc Tử (giết chết một phần ba dân số châu Âu), đại dịch cúm năm 1918 (50-100 triệu ca tử vong) và các kịch bản tương lai tiềm năng như chiến tranh hạt nhân hoặc đại dịch được tạo ra nhân tạo (Ord, 2020). Trong bối cảnh AI, những rủi ro này có thể gây ra sự gián đoạn trên quy mô quốc tế. Thất nghiệp hàng loạt do tự động hóa AI có thể làm suy yếu toàn bộ nền kinh tế, gây ra bất ổn xã hội và biến động chính trị. Các cuộc tấn công mạng sử dụng phần mềm độc hại do AI tạo ra có thể làm tê liệt hệ thống tài chính hoặc cơ sở hạ tầng quan trọng của một quốc gia. Giám sát được hỗ trợ bởi AI có thể cho phép kiểm soát độc tài đối với hàng trăm triệu người. Các thể chế dân chủ có thể sụp đổ dưới các chiến dịch thông tin sai lệch do AI hỗ trợ kéo dài, làm tan vỡ thực tại chung và khiến việc ra quyết định tập thể trở nên bất khả thi (Slattery et al., 2024; Hammond et al., 2025; Gabriel et al., 2024; Stanford HAI, 2025). Những rủi ro này ảnh hưởng đến hàng triệu đến hàng tỷ người nhưng generally không ngăn cản sự phục hồi hoặc thích nghi sau này.

Rủi ro hiện sinh (x-risks) đại diện cho những mối đe dọa mà nhân loại có thể không bao giờ phục hồi được tiềm năng đầy đủ của mình. Khác với rủi ro thảm họa nơi phục hồi vẫn có thể, rủi ro hiện sinh hoặc tiêu diệt hoàn toàn nhân loại, hoặc vĩnh viễn ngăn cản văn minh đạt được những đỉnh cao công nghệ, luân lý hoặc văn hóa mà nó có thể đạt được. Rủi ro hiện sinh liên quan đến AI bao gồm các kịch bản mà các hệ thống tiên tiến vĩnh viễn tước đoạt quyền lực của nhân loại, thiết lập một chế độ toàn trị ổn định và không thể lật đổ, hoặc gây ra tuyệt chủng loài người (Bostrom, 2002; Conn, 2015; Ord, 2020). Những rủi ro này đòi hỏi các chiến lược phòng ngừa thay vì phản ứng, vì việc học hỏi từ thất bại trở nên bất khả thi theo định nghĩa.[^footnote_recovery]

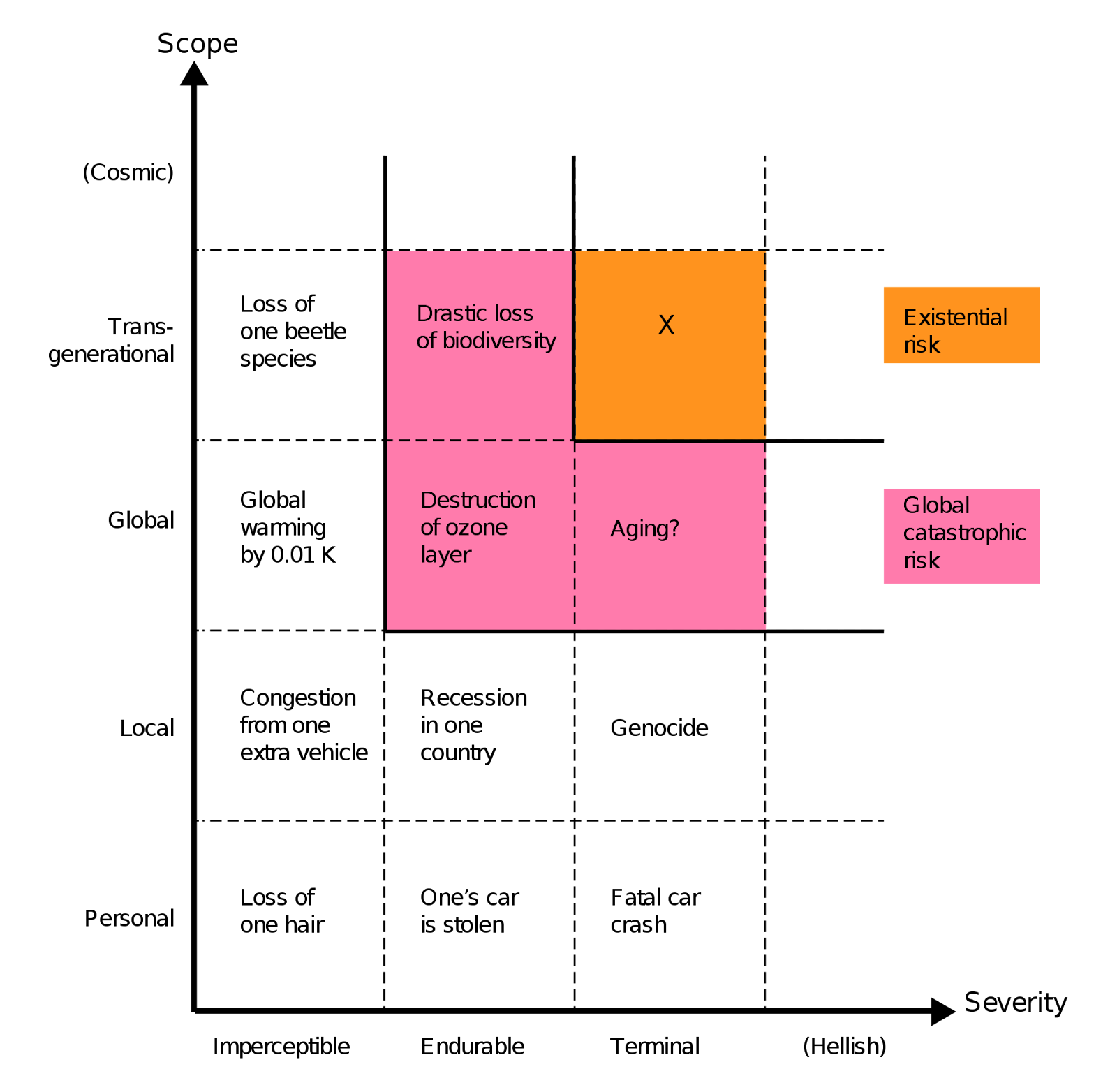

Rủi ro hiện sinh (x-risks) (Bostrom, 2001)

Rủi ro hiện sinh là rủi ro mà kết quả tiêu cực có thể tiêu diệt hoàn toàn sự sống thông minh có nguồn gốc từ Trái Đất hoặc vĩnh viễn và nghiêm trọng hạn chế tiềm năng của nó.

Sụp đổ nền văn minh không thể phục hồi, nơi chúng ta hoặc tuyệt chủng hoặc không bao giờ được thay thế bởi một nền văn minh sau này tái thiết, đã được cho là có thể xảy ra, nhưng có xác suất cực kỳ thấp (Rodriguez, 2020).

Các loại rủi ro định tính. Phạm vi rủi ro có thể là cá nhân (ảnh hưởng đến một người), địa phương (ảnh hưởng đến một khu vực địa lý hoặc một nhóm cụ thể), toàn cầu (ảnh hưởng đến toàn bộ dân số nhân loại hoặc một phần lớn của nó), xuyên thế hệ (ảnh hưởng đến nhân loại trong nhiều thế hệ) hoặc toàn thế hệ (ảnh hưởng đến nhân loại nói chung hoặc hầu hết các thế hệ tương lai). Mức độ nghiêm trọng của rủi ro có thể được phân loại là không đáng kể (khó nhận ra), có thể chịu đựng được (gây hại nghiêm trọng nhưng không hoàn toàn phá hủy chất lượng cuộc sống) hoặc tàn khốc (gây tử vong hoặc giảm sút nghiêm trọng và vĩnh viễn chất lượng cuộc sống) (Bostrom, 2012).

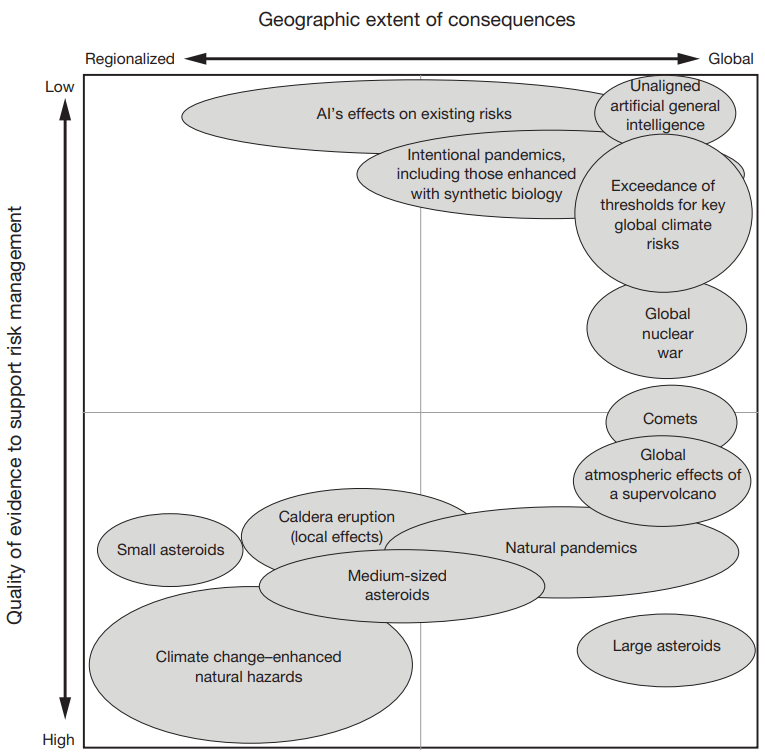

Đánh giá Rủi ro Thảm họa Toàn cầu của RAND. Vị trí và kích thước của các hình elip trong hình này thể hiện một mô tả định tính về mối quan hệ tương đối giữa các mối đe dọa và nguy cơ. Hình này chỉ trình bày các ví dụ về các trường hợp hoặc kịch bản được mô tả trong các chương đó, không phải tất cả các kịch bản được mô tả (Willis et al., 2024).

Các rủi ro có mức độ nghiêm trọng cao đại diện cho những sai lầm không thể đảo ngược với hệ quả vĩnh viễn. Chúng ta đã chứng kiến trí tuệ nhân tạo (AI) gây ra những tác hại được ghi nhận đối với con người thực tế và có tác động làm mất ổn định các hệ thống toàn cầu. Tuy nhiên, các rủi ro thảm họa và hiện sinh đặt ra một thách thức cơ bản khác biệt: nếu các hệ thống AI tiên tiến gây ra thảm họa hiện sinh, nhân loại không thể học hỏi từ sai lầm đó và triển khai các biện pháp bảo vệ tốt hơn. Sự không thể đảo ngược này khiến một số nhà nghiên cứu lập luận rằng cần ưu tiên phòng ngừa các kịch bản có xác suất thấp nhưng tầm ảnh hưởng lớn bên cạnh việc giải quyết các tác hại hiện tại (Bostrom, 2002). Tuy nhiên, mọi người không đồng ý về sự cân bằng phù hợp giữa các mức độ rủi ro khác nhau (Oxford Union Debate, 2024; Munk Debate, 2024).

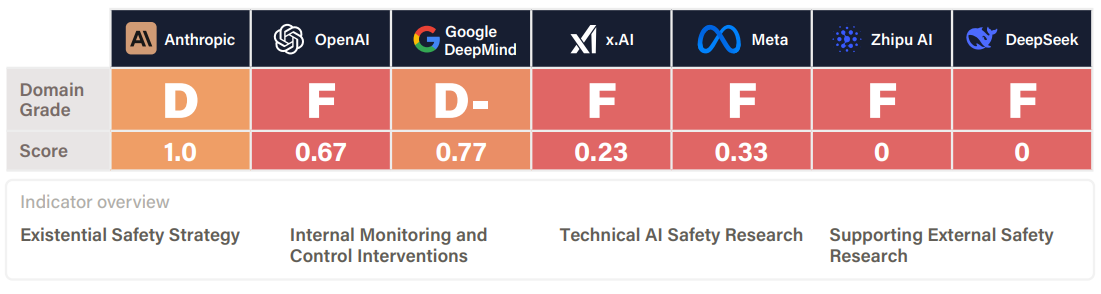

Báo cáo chỉ số an toàn AI cho mùa hè 2025. Các điểm số này thuộc danh mục Rủi ro hiện sinh, thể hiện mức độ sẵn sàng của các công ty trong việc quản lý các rủi ro cực đoan từ các hệ thống AI tương lai có thể sánh ngang hoặc vượt qua năng lực của con người, bao gồm các chiến lược và nghiên cứu về sự đồng bộ và kiểm soát (FLI, 2025). Rõ ràng là có một khoảng cách về sự sẵn sàng. Các công ty tuyên bố sẽ đạt được Trí tuệ nhân tạo tổng quát (AGI) trong thập kỷ tới, nhưng không có công ty nào đạt điểm trên D trong kế hoạch an toàn tồn vong.

Rủi ro Ikigai (i-risks) liên quan đến việc mất đi ý nghĩa và mục đích sống ngay cả khi con người vẫn tồn tại và phát triển. Tên gọi này được lấy từ khái niệm Ikigai của Nhật Bản (mục đích sống), những rủi ro này xuất hiện khi các hệ thống AI trở nên vượt trội hơn con người trong mọi hoạt động có ý nghĩa. Con người có thể mất đi cảm giác về mục đích sống khi AI có thể tạo ra nghệ thuật tốt hơn, thực hiện nghiên cứu tốt hơn và đạt được hiệu suất xuất sắc hơn - những nhiệm vụ truyền thống mang lại ý nghĩa cho cuộc sống. Khác với rủi ro tuyệt chủng loài người hoặc đau khổ, i-risks liên quan đến các kịch bản mà con người an toàn và thoải mái về vật chất nhưng lại lạc lõng về mặt tồn tại. Chúng ta có thể tạo ra các ràng buộc nhân tạo để duy trì sự liên quan của con người, hoặc tìm ra những hình thức mục đích hoàn toàn mới nảy sinh từ sự hợp tác giữa con người và AI. Tuy nhiên, các giải pháp này đặt ra những câu hỏi riêng về tính chân thực và liệu ý nghĩa được duy trì nhân tạo có thể thỏa mãn nhu cầu tâm lý của con người hay không (Yampolskiy, 2024; Yampolsky; 2024).

Rủi ro đau khổ quy mô vũ trụ (S-risks) liên quan đến lượng đau khổ khổng lồ có thể vượt xa tất cả đau khổ trong lịch sử nhân loại. S-risks là một loại rủi ro hiện sinh đặc biệt. Chúng đại diện cho các kịch bản mà tương lai chứa đựng lượng đau khổ gấp nhiều lần so với hiện tại, có thể liên quan đến hàng nghìn tỷ sinh vật có ý thức trên khắp không gian và thời gian. Khác với rủi ro tuyệt chủng loại bỏ hoàn toàn trải nghiệm, nguy cơ đau khổ quy mô vũ trụ tạo ra tương lai tràn ngập đau khổ khủng khiếp (Althaus & Gloor, 2016; Baumann, 2017; DiGiovanni, 2023).

Các nền văn minh tương lai có thể tạo ra số lượng khổng lồ các thực thể có ý thức nhân tạo. Nếu những thực thể này có ý thức, thì các trí tuệ nhân tạo có thể trải qua đau khổ thực sự nếu được tạo ra một cách cẩu thả. Các giải pháp hiệu quả có thể vô tình gây ra đau khổ - như nô lệ kỹ thuật số, nơi hàng nghìn tỷ trí tuệ số thực hiện lao động tính toán trong điều kiện khủng khiếp. Các nền văn minh tương lai thực hiện các mô phỏng chi tiết về tiến hóa sinh học hoặc kiểm tra các lý thuyết về ý thức có thể vô tình tạo ra hàng triệu sinh vật đau khổ trong các mô phỏng của họ. Các sinh vật được mô phỏng sẽ trải qua đau khổ thực sự mặc dù chúng chỉ tồn tại dưới dạng các quá trình tính toán.

Mặc dù những kịch bản này có thể nghe giống như khoa học viễn tưởng, một số nhà nghiên cứu cho rằng chúng xứng đáng được xem xét do những hậu quả tiềm tàng khổng lồ và tính không thể đảo ngược của những kết quả này nếu chúng xảy ra.

Các danh mục rủi ro và mức độ nghiêm trọng này cung cấp nền tảng để phân tích các năng lực cụ thể của trí tuệ nhân tạo (AI) có thể dẫn đến kết quả gây hại. Phần còn lại của chương này tập trung vào việc trình bày các trường hợp cụ thể và lập luận về cách các phát triển AI khác nhau có thể dẫn đến các mức độ gây hại khác nhau, đặc biệt là những trường hợp có thể vượt qua giới hạn dẫn đến thảm họa hoặc đe dọa tồn vong.