*Chương này là chương phụ lục của chương 1. Bạn có thể sang thẳng chương 2 tại đây.

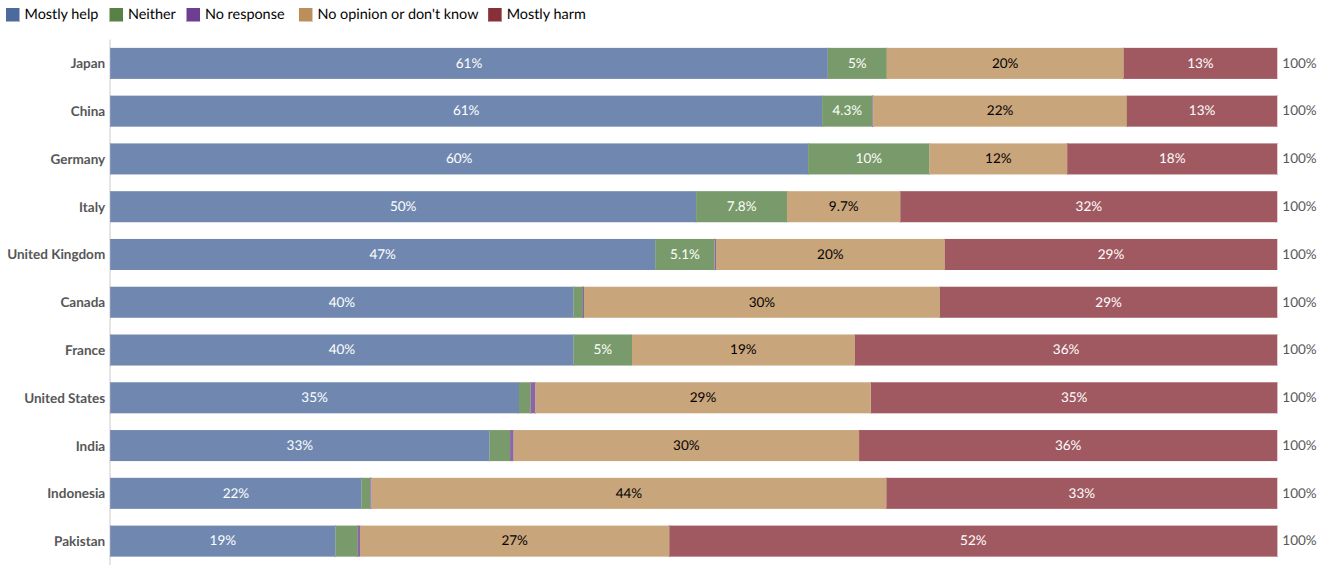

Quan điểm về tầm ảnh hưởng của trí tuệ nhân tạo (AI) đối với xã hội trong 20 năm tới, 2021. Các đối tượng tham gia khảo sát được hỏi: “Trí tuệ nhân tạo sẽ giúp hay gây hại cho con người trong 20 năm tới?” (Giattino et al., 2023).

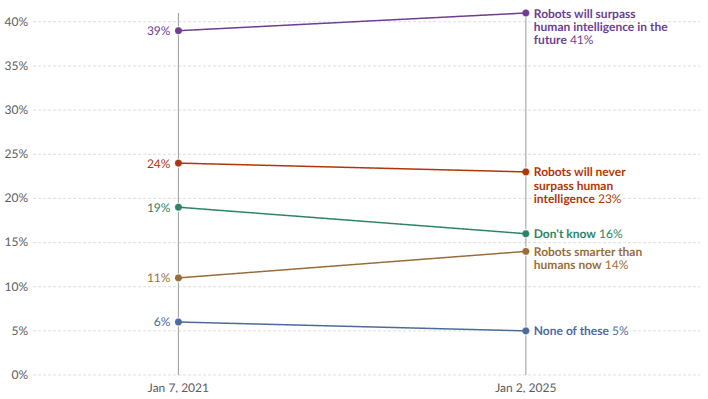

Quan điểm của người Mỹ về trí tuệ robot so với trí tuệ con người. Các đối tượng tham gia khảo sát được hỏi: “Bạn đồng ý nhất với câu nào trong số các câu sau đây?” (Giattino et al., 2023).

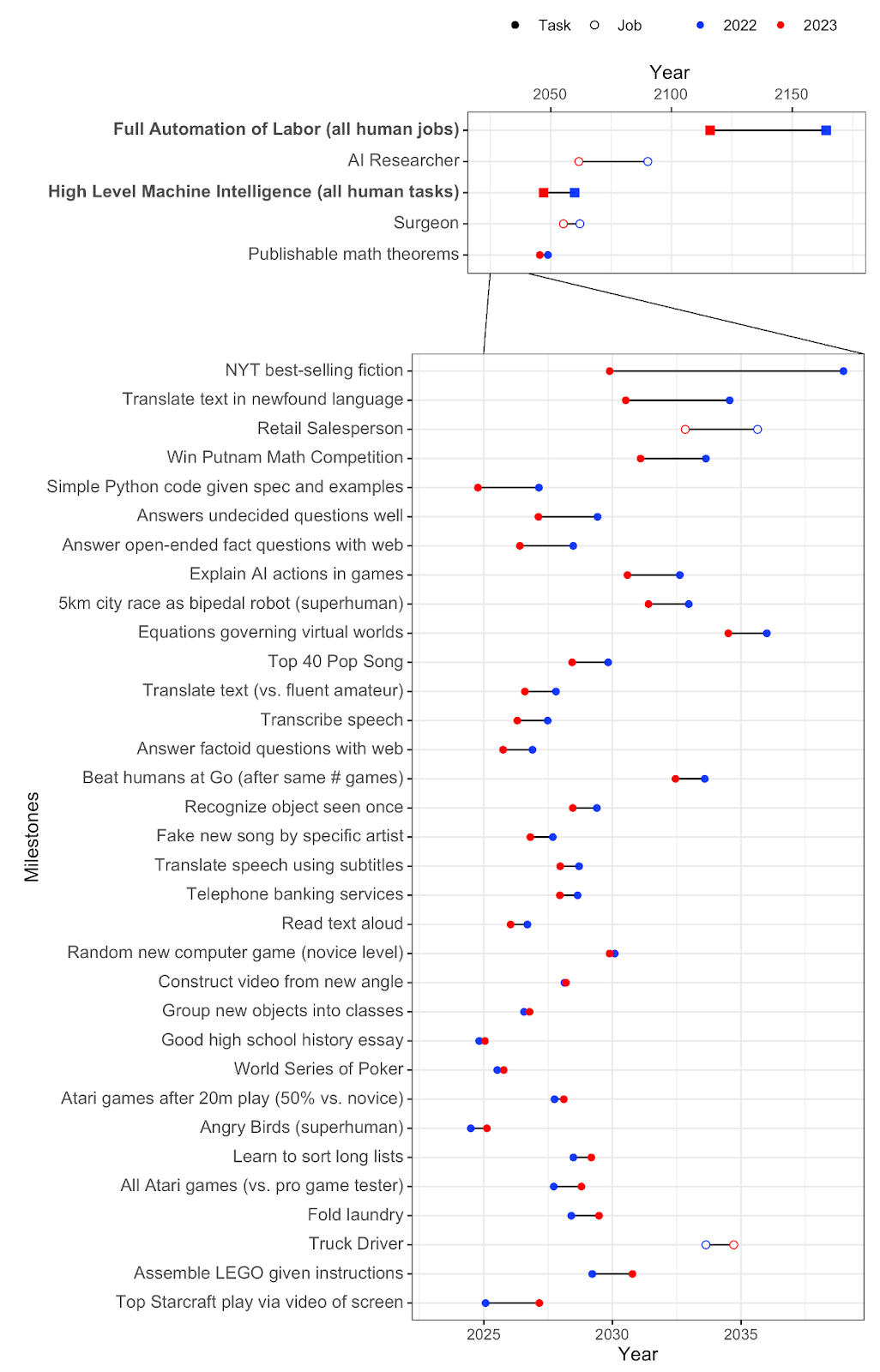

Theo một cuộc khảo sát gần đây do AI Tầm Ảnh hưởng thực hiện (AI Tầm Ảnh hưởng, 2022): “Thời gian dự kiến để đạt được hiệu suất thông minh ngang bằng con người đã giảm từ 1–5 thập kỷ so với cuộc khảo sát năm 2022. Như thường lệ, các câu hỏi về ‘trí tuệ nhân tạo đẳng cấp’ (HLMI) và ‘tự động hóa hoàn toàn lao động’ (FAOL) nhận được câu trả lời rất khác nhau, và cá nhân có nhiều ý kiến trái chiều (được thể hiện bằng các đường mỏng bên dưới), nhưng dự báo tổng hợp cho cả hai nhóm câu hỏi đều giảm mạnh. Để tham khảo, giữa các cuộc khảo sát từ năm 2016 đến 2022, dự báo về HLMI chỉ thay đổi khoảng một năm.

Khảo sát năm 2024 về các chuyên gia AI (AI tầm ảnh hưởng, 2022)

Cũng có thể so sánh dự báo của cùng một nghiên cứu vào năm 2022 với kết quả hiện tại. Đáng chú ý là cộng đồng đã đánh giá thấp tốc độ tiến bộ trong năm 2023 và điều chỉnh dự báo của mình theo hướng giảm. Một số dự báo khá bất ngờ. Ví dụ, các tác vụ như "Viết bài luận trung học" và "Chuyển đổi giọng nói thành văn bản" đã được tự động hóa với ChatGPT và Whisper, tương ứng. Tuy nhiên, dường như các nhà nghiên cứu không biết đến những kết quả này. Ngoài ra, điều đáng ngạc nhiên là dự báo về thời điểm chúng ta có thể xây dựng một "nhà nghiên cứu AI" có thời gian dài hơn so với thời điểm chúng ta có thể xây dựng "trí tuệ nhân tạo đẳng cấp (tất cả các tác vụ của con người)". Trung vị của cuộc khảo sát chuyên gia năm 2024 dự đoán trí tuệ máy tính cấp con người (HLMI) vào năm 2049.

Dưới đây là nhiều trích dẫn từ các chuyên gia về trí tuệ nhân tạo biến đổi.

Lưu ý rằng Hinton, Bengio và Sutskever là một số nhà nghiên cứu được trích dẫn nhiều nhất trong lĩnh vực AI. Và Hinton, Bengio và LeCun là những người nhận giải Turing về Học sâu. Một số người dùng trên Reddit đã tổng hợp một danh sách toàn diện về các dự báo thời gian công khai về AI từ các nhà nghiên cứu và lãnh đạo ngành nổi tiếng.

Câu hỏi nghiên cứu là: Làm thế nào để bạn ngăn chặn họ không bao giờ muốn kiểm soát? Và không ai biết câu trả lời [...] Chuông báo động mà tôi đang gióng lên liên quan đến mối đe dọa hiện sinh khi chúng chiếm quyền kiểm soát [...] Nếu bạn coi trọng rủi ro hiện sinh này, như tôi hiện nay, thì có thể rất hợp lý khi ngừng phát triển những thứ này thêm nữa [...] nó giống như người ngoài hành tinh đã hạ cánh và mọi người chưa nhận ra vì họ nói tiếng Anh rất tốt.

Geoffrey Hinton, Cha đẻ của AI hiện đại, người nhận Giải thưởng Turing

Rất khó, về mặt cái tôi và cảm giác tự hào về công việc của mình, để chấp nhận ý tưởng rằng thứ mà bạn đã dành hàng thập kỷ để nghiên cứu có thể thực sự nguy hiểm cho nhân loại... Tôi nghĩ rằng tôi không muốn suy nghĩ quá nhiều về điều đó, và có lẽ điều đó cũng đúng với những người khác [...] Trí tuệ nhân tạo (AI) tự định hướng có thể nguy hiểm cho toàn nhân loại. Cấm các hệ thống AI mạnh mẽ (ví dụ như vượt quá khả năng của GPT-4) được trao quyền tự định hướng và khả năng hành động sẽ là một bước khởi đầu tốt.

Yoshua Bengio, Một trong những nhà khoa học được trích dẫn nhiều nhất mọi thời đại, "Ông tổ" của trí tuệ nhân tạo hiện đại, người đoạt Giải thưởng Turing

Nếu chúng ta tiếp tục theo đuổi [cách tiếp cận hiện tại], thì cuối cùng chúng ta sẽ mất kiểm soát đối với các máy móc.

Stuart Russell, Đồng tác giả của cuốn sách giáo khoa AI hàng đầu, Đồng sáng lập Trung tâm AI Thân thiện với Con người

Chúng ta phải xem xét các rủi ro từ AI một cách nghiêm túc như các thách thức toàn cầu lớn khác, như biến đổi khí hậu. Cộng đồng quốc tế đã mất quá nhiều thời gian để phối hợp một phản ứng toàn cầu hiệu quả đối với vấn đề này, và chúng ta đang phải gánh chịu hệ quả của điều đó hiện nay. Chúng ta không thể để xảy ra sự chậm trễ tương tự với AI [...] có thể một ngày nào đó sẽ có một tổ chức tương tự như Cơ quan Năng lượng Nguyên tử Quốc tế (IAEA), thực sự kiểm toán các vấn đề này.

Demis Hassabis, Đồng sáng lập và Giám đốc điều hành của DeepMind

Khi tôi nghĩ về lý do tại sao tôi sợ [...] tôi nghĩ điều thực sự khó bác bỏ là: sẽ có những mô hình mạnh mẽ; chúng sẽ có khả năng tác nhân; chúng ta đang tiến gần đến chúng. Nếu một mô hình như vậy muốn gây hỗn loạn và hủy diệt nhân loại hoặc bất cứ điều gì, tôi nghĩ chúng ta cơ bản không có khả năng ngăn chặn nó.

Dario Amodei, Đồng sáng lập và CEO của Anthropic, Cựu Trưởng bộ phận an toàn AI tại OpenAI

[Về việc tạm dừng] Tôi không loại trừ khả năng đó. Và tôi nghĩ rằng trong vòng khoảng năm năm tới, chúng ta sẽ phải xem xét câu hỏi đó một cách nghiêm túc.

Mustafa Suleyman, Giám đốc Điều hành Microsoft AI, Đồng sáng lập DeepMind

Tương lai sẽ tốt đẹp cho các hệ thống trí tuệ nhân tạo (AI) dù sao đi nữa; sẽ thật tuyệt nếu nó cũng tốt đẹp cho con người [...] Không phải là nó sẽ tích cực ghét con người và muốn gây hại cho họ, mà chỉ là nó sẽ quá mạnh mẽ, và tôi nghĩ một ví dụ hay là cách con người đối xử với động vật [...] Và tôi nghĩ rằng mối quan hệ đó sẽ là mối quan hệ mặc định giữa chúng ta và các hệ thống trí tuệ nhân tạo tổng quát (AGIs) thực sự tự chủ và hoạt động vì lợi ích của chính chúng.

Ilya Sutskever, Một trong những nhà khoa học được trích dẫn nhiều nhất mọi thời đại, Đồng sáng lập và Cựu Giám đốc Khoa học tại OpenAI

Liệu các rủi ro tiềm ẩn từ trí tuệ nhân tạo (AI) có vượt trội hơn các rủi ro hiện sinh khác…? Đây là rủi ro hàng đầu của tôi trong thế kỷ này [...] Điều khiến tôi lo lắng không phải là sự thiếu hụt các dự án AGI cụ thể, mà là sự thiếu hụt các kế hoạch cụ thể về cách đảm bảo an toàn cho chúng.

Shane Legg, Đồng sáng lập và Giám đốc Khoa học AGI tại DeepMind

[Sau khi từ chức tại OpenAI, nói về các nguồn rủi ro] Những vấn đề này rất khó để giải quyết đúng đắn, và tôi lo ngại rằng chúng ta không đang đi đúng hướng để đạt được điều đó [...] OpenAI đang gánh vác một trách nhiệm khổng lồ thay mặt cho toàn nhân loại. Nhưng trong những năm qua, văn hóa an toàn và quy trình đã bị đẩy lùi so với các sản phẩm sáng bóng. Chúng ta đã quá muộn để nghiêm túc đối mặt với những hậu quả của Trí tuệ Nhân tạo Tổng quát (AGI).

Jan Leike, Cựu đồng trưởng dự án Superalignment tại OpenAI

[Đề xuất về cách đề nghị thành lập một cơ quan quản lý toàn cầu:] "Bất kỳ cụm khả năng điện toán nào vượt quá ngưỡng công suất cực cao nhất định – và với chi phí như vậy, chúng ta đang nói đến khoảng năm cụm trên thế giới, đại loại như vậy – bất kỳ cụm nào như vậy phải tuân thủ quy trình kiểm tra tương tự như các thanh tra vũ khí quốc tế" […] Tôi đã thực hiện một chuyến đi vòng quanh thế giới trong năm nay và đã trò chuyện với các nhà lãnh đạo quốc gia của nhiều quốc gia cần tham gia vào điều này, và hầu hết đều ủng hộ ý tưởng này.

Sam Altman, Đồng sáng lập và CEO của OpenAI

Cách thức chính xác mà thế giới sau AGI sẽ trông như thế nào là điều khó dự đoán — thế giới đó có thể sẽ khác biệt hơn so với thế giới hiện tại so với sự khác biệt giữa thế giới hiện tại và thế kỷ 16 [...] Chúng ta vẫn chưa biết mức độ khó khăn để đảm bảo rằng các AGI sẽ hành động theo giá trị của người vận hành. Một số người tin rằng điều đó sẽ dễ dàng; một số người tin rằng nó sẽ vô cùng khó khăn; nhưng không ai biết chắc chắn.

Greg Brockman, Đồng sáng lập và Cựu Giám đốc Công nghệ (CTO) của OpenAI

[Nói về thời kỳ gần thời điểm tạo ra trí tuệ nhân tạo tổng quát (AGI) đầu tiên] bạn có động lực cạnh tranh nơi mọi người đều cố gắng vượt lên trước, và điều đó có thể đòi hỏi phải hy sinh yếu tố an toàn. Vì vậy, tôi nghĩ có thể cần sự phối hợp giữa các thực thể lớn đang thực hiện loại đào tạo này [...] Tạm dừng đào tạo thêm, hoặc tạm dừng triển khai, hoặc tránh các loại đào tạo mà chúng ta cho là có thể rủi ro hơn.

John Schulman, Đồng sáng lập OpenAI

Tôi chưa gặp ai trong các phòng thí nghiệm trí tuệ nhân tạo (AI) nói rằng rủi ro [từ việc đào tạo mô hình thế hệ tiếp theo] thấp hơn 1% so với việc phá hủy hành tinh. Điều quan trọng là mọi người cần biết rằng cuộc sống đang bị đe dọa [...] Một điều mà việc tạm dừng đạt được là chúng ta sẽ không đẩy mạnh ranh giới, đặc biệt là trong các thí nghiệm đào tạo trước có rủi ro cao.

Jaan Tallinn, Đồng sáng lập Skype, Viện Tương lai của Cuộc sống

Một cỗ máy siêu thông minh có thể thiết kế ra những cỗ máy tốt hơn nữa; lúc đó chắc chắn sẽ xảy ra một "sự bùng nổ trí tuệ", và trí tuệ của con người sẽ bị bỏ lại xa phía sau. Do đó, cỗ máy siêu thông minh đầu tiên sẽ là phát minh cuối cùng mà con người cần phải tạo ra, miễn là cỗ máy đó đủ ngoan ngoãn để chỉ cho chúng ta cách kiểm soát nó.

I. J. Good, Chuyên gia mật mã tại Bletchley Park

Có vẻ như một khi phương pháp suy nghĩ của máy móc đã bắt đầu, sẽ không lâu trước khi chúng vượt qua khả năng yếu ớt của chúng ta… Chúng sẽ có thể trò chuyện với nhau để nâng cao trí tuệ. Do đó, ở một giai đoạn nào đó, chúng ta phải chuẩn bị cho việc máy móc sẽ nắm quyền kiểm soát.

Alan Turing, Cha đẻ của Khoa học Máy tính và Trí tuệ Nhân tạo

Sự phát triển của trí tuệ nhân tạo hoàn chỉnh có thể đánh dấu sự kết thúc của loài người [...] Nó sẽ tự phát triển và tái thiết kế bản thân với tốc độ ngày càng tăng.

Stephen Hawking, Nhà vật lý lý thuyết

Tôi không mong đợi một thứ gì đó thực sự thông minh sẽ tấn công chúng ta bằng những đội quân robot diễu hành có đôi mắt đỏ rực, nơi có thể có một bộ phim thú vị về việc chúng ta chiến đấu với chúng. Tôi mong đợi một thực thể thực sự thông minh và vô cảm sẽ tìm ra các chiến lược và công nghệ có thể tiêu diệt chúng ta một cách nhanh chóng và đáng tin cậy, sau đó tiêu diệt chúng ta.

Eliezer Yudkowsky, Nhà nghiên cứu an toàn AI, Đồng sáng lập Viện Nghiên cứu Trí tuệ Máy móc (MIRI)

Trí tuệ nhân tạo (AI) là trường hợp hiếm hoi mà tôi cho rằng chúng ta cần chủ động trong việc quy định hơn là phản ứng [...] Tôi cho rằng [trí tuệ siêu việt kỹ thuật số] là thách thức tồn vong lớn nhất mà chúng ta phải đối mặt và cũng là thách thức cấp bách nhất. Nó cần phải là một cơ quan công quyền có tầm nhìn và quyền giám sát để đảm bảo rằng mọi người đang phát triển AI một cách an toàn [...] Và hãy nhớ lời tôi, AI nguy hiểm hơn vũ khí hạt nhân rất nhiều. Rất nhiều. Vậy tại sao chúng ta lại không có sự giám sát quy định? Điều này thật điên rồ.

Elon Musk, Nhà sáng lập/Cộng sự sáng lập của OpenAI, Neuralink, SpaceX, xAI, PayPal, Giám đốc điều hành (CEO) của Tesla, Giám đốc công nghệ (CTO) của X/Twitter

Trí tuệ siêu trí tuệ sẽ xuất hiện trong tương lai của chúng ta. [...] Có khả năng trí tuệ nhân tạo sẽ mất kiểm soát. [Có thể,] một máy móc có thể quyết định rằng con người là mối đe dọa, kết luận rằng lợi ích của nó khác với lợi ích của chúng ta, hoặc đơn giản là ngừng quan tâm đến chúng ta.

Bill Gates, Đồng sáng lập Microsoft

Các rủi ro nghiêm trọng có thể phát sinh từ việc lợi dụng sai mục đích hoặc các vấn đề không mong muốn liên quan đến kiểm soát phù hợp với ý định của con người. Những vấn đề này một phần là do các năng lực đó chưa được hiểu rõ hoàn toàn [...] Có tiềm năng gây ra thiệt hại nghiêm trọng, thậm chí thảm khốc, dù là cố ý hay vô ý, xuất phát từ các năng lực quan trọng nhất của các mô hình AI này.

Tuyên bố Bletchley, nhiều quốc gia trong khối EU