P(doom) đại diện cho xác suất chủ quan rằng trí tuệ nhân tạo sẽ gây ra các kết quả thảm họa hiện sinh cho nhân loại. Thuật ngữ này đã phát triển thành một chỉ số nghiêm túc được các nhà nghiên cứu, nhà hoạch định chính sách và lãnh đạo ngành sử dụng để thể hiện đánh giá rủi ro hiện sinh của AI. Các kịch bản cụ thể được bao hàm bởi "doom" có thể thay đổi nhưng thường bao gồm tuyệt chủng loài người, mất năng lực vĩnh viễn của nhân loại hoặc sụp đổ nền văn minh (Field, 2025).

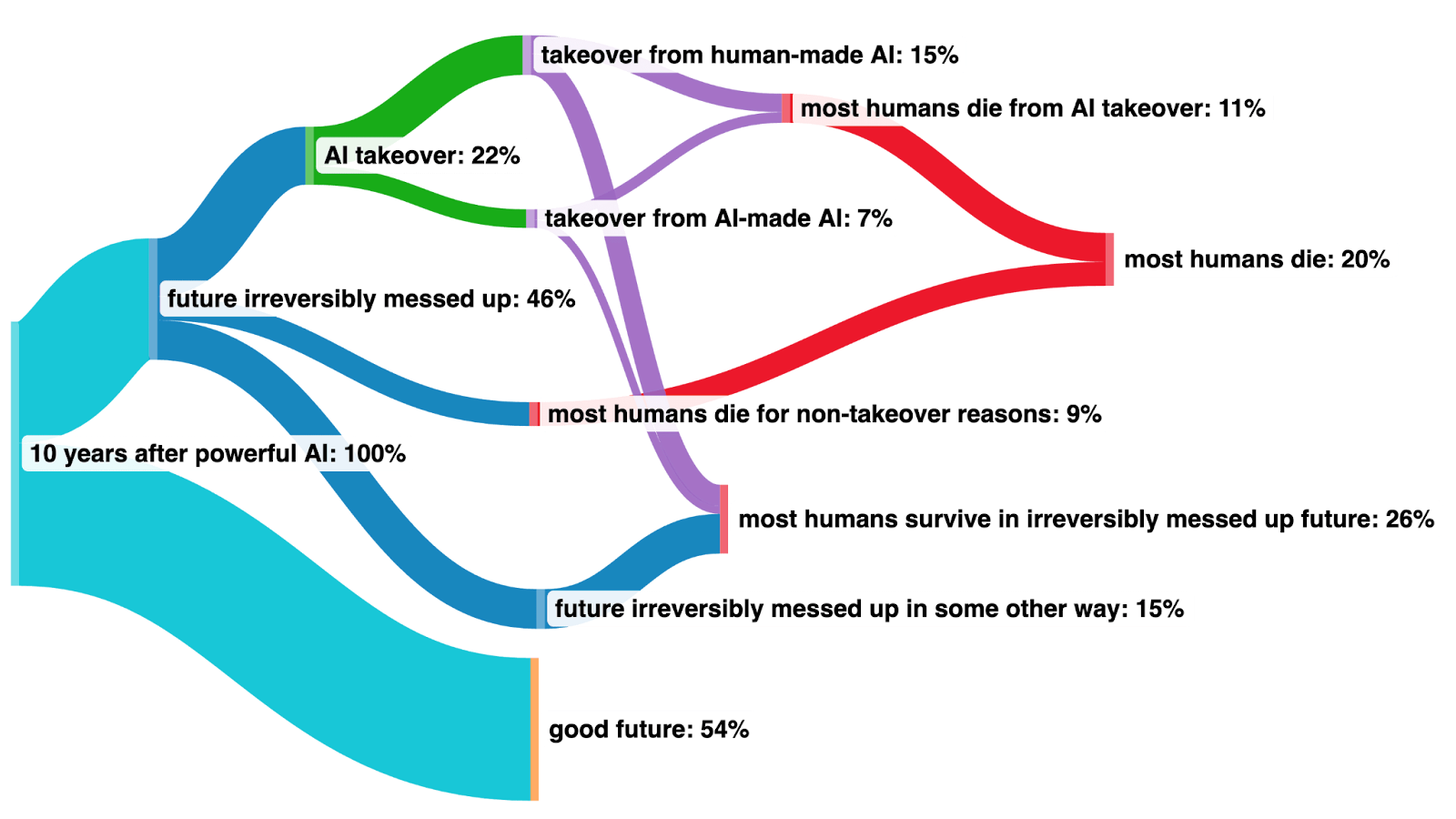

Hình minh họa mô tả quan điểm của Paul Christiano về tương lai. Paul Christiano là một nhà nghiên cứu an toàn AI và hiện là Giám đốc Viện An toàn AI Hoa Kỳ. Ông từng điều hành Trung tâm Nghiên cứu Cân bằng và nhóm nghiên cứu cân bằng mô hình ngôn ngữ tại OpenAI (Christiano, 2023)

Định lượng rủi ro hiện sinh gặp phải những thách thức cơ bản do tính chất chưa từng có của mối đe dọa. Khác với các đánh giá rủi ro khác có thể dựa vào dữ liệu lịch sử hoặc bằng chứng thực nghiệm, các ước tính rủi ro hiện sinh của AI phụ thuộc nặng nề vào lập luận lý thuyết, phán đoán của chuyên gia và suy luận về các kịch bản tương lai chưa từng xảy ra. Không có phương pháp luận tiêu chuẩn để tính toán P(doom) - mỗi ước tính phản ánh đánh giá chủ quan của cá nhân về các yếu tố như thời gian phát triển AI, độ khó điều chỉnh, năng lực quản trị và các chế độ thất bại tiềm năng.

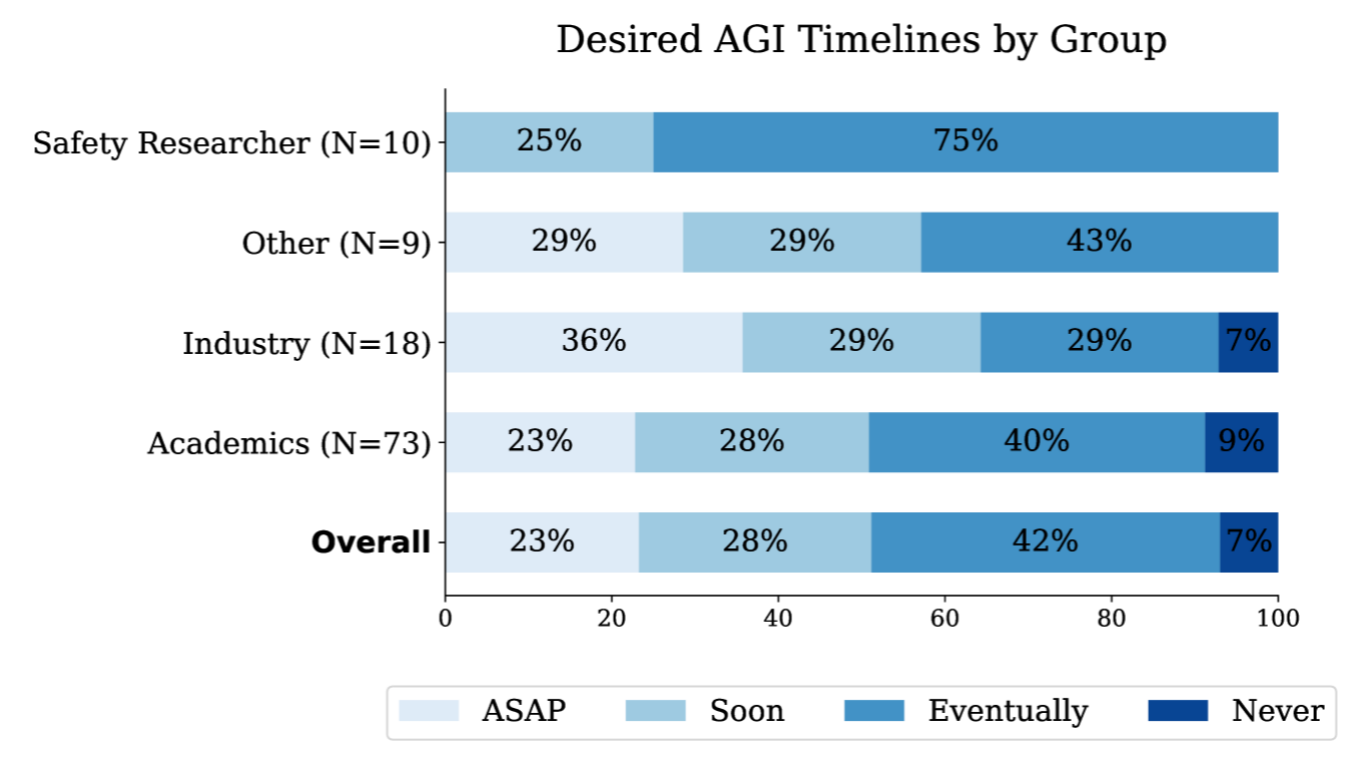

Biểu đồ thanh từ một cuộc khảo sát về thời gian phát triển AGI mong muốn. Các tham gia viên được hỏi: “Điều nào mô tả tốt nhất quan điểm của bạn về thời điểm chúng ta nên phát triển AGI?” Các tham gia viên có các lựa chọn sau: “Chúng ta không bao giờ nên phát triển AGI,” “Cuối cùng, nhưng không sớm,” “Sớm, nhưng không nhanh nhất có thể,” “Chúng ta nên phát triển các hệ thống mạnh mẽ và tổng quát hơn nhanh nhất có thể.” Người tham gia được chia theo lĩnh vực nghề nghiệp (Field, 2025).

Các ước tính của chuyên gia dao động mạnh mẽ, bao trùm gần như toàn bộ phạm vi xác suất. Một cuộc khảo sát năm 2023 cho thấy các nhà nghiên cứu AI ước tính rủi ro tuyệt chủng trung bình là 14,4% trong 100 năm, nhưng các ước tính cá nhân dao động từ gần như bằng không đến gần như chắc chắn (PauseAI, 2025; Field, 2025):

Sự chênh lệch lớn trong các ước tính cho thấy một số hạn chế quan trọng. Thứ nhất, nhiều chuyên gia không xác định khung thời gian, khiến việc so sánh trở nên khó khăn. Thứ hai, định nghĩa về "thảm họa" có thể khác nhau giữa thảm họa hiện sinh, tuyệt chủng loài người hoặc mất năng lực vĩnh viễn. Thứ ba, các ước tính rất nhạy cảm với các giả định về lộ trình phát triển AI, độ khó trong việc đồng bộ hóa và phản ứng của các cơ quan chức năng. Mặc dù chúng ta không thể tiếp cận bất kỳ "xác suất khách quan" nào về thảm họa AI, ngay cả các ước tính chủ quan của chuyên gia cũng là đầu vào quan trọng cho việc ưu tiên và ra quyết định chính sách. Khối lượng xác suất đáng kể mà các chuyên gia có kiến thức đặt vào các rủi ro thảm họa—bao gồm cả những người đã phát triển các hệ thống AI tạo ra những rủi ro này—cho thấy các kịch bản rủi ro được mô tả trong chương này xứng đáng được quan tâm nghiêm túc thay vì bị coi là khoa học viễn tưởng.