Chương trước đã khám phá khả năng phát triển nhanh chóng của AI thông qua các định luật mở rộng quy mô, bài học cay đắng và các kịch bản cất cánh AI tiềm năng. Chúng ta đã thấy cách tăng cường khả năng điện toán, dữ liệu và cải tiến thuật toán thúc đẩy sự gia tăng liên tục về năng lực trên nhiều lĩnh vực. Nhưng tại sao việc tăng cường năng lực lại đáng lo ngại? Câu trả lời ngắn gọn là - các hệ thống AI có năng lực cao hơn tạo ra rủi ro quy mô lớn hơn.

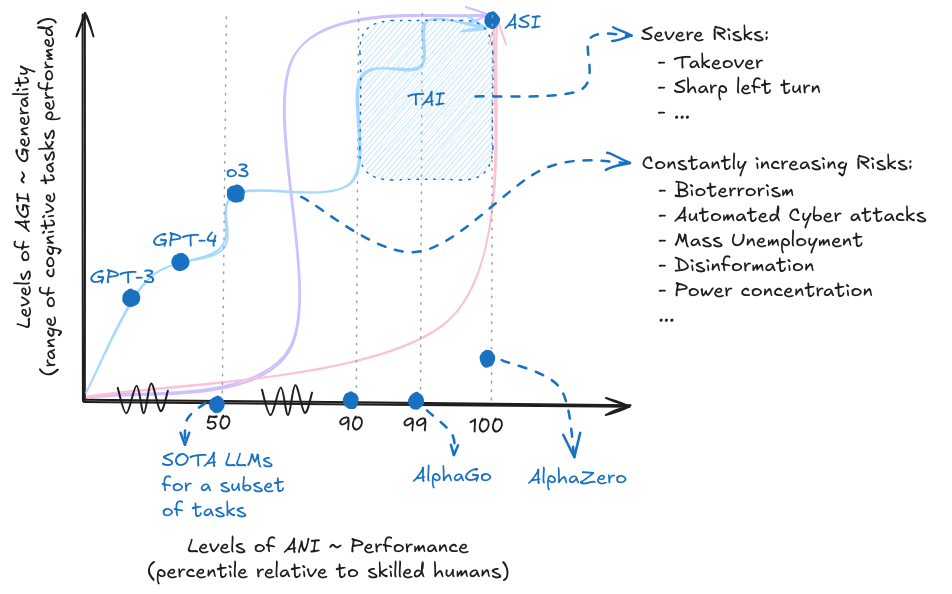

Khi năng lực ngày càng tăng, chúng ta cũng chứng kiến rủi ro ngày càng lớn. Tùy thuộc vào hướng phát triển và sự bùng nổ, chúng ta có thể đối mặt với những giai đoạn kéo dài có rủi ro thảm họa tiềm ẩn, hoặc những rủi ro hiện sinh nghiêm trọng bùng phát đột ngột. Các đường cong và màu sắc trong sơ đồ này chỉ mang tính minh họa và không đại diện cho bất kỳ hướng phát triển dự báo cụ thể nào.

Năng lực nguy hiểm là những ví dụ cụ thể về cách các xu hướng chúng ta đã khám phá trong chương trước dẫn đến lo ngại. Những định luật mở rộng quy mô giúp cải thiện hiệu suất trong lập trình, tạo văn bản tốt hơn và v.v., cũng có thể cho phép những điều như lừa dối, thao túng, nhận thức tình huống, sao chép tự động và định hướng mục tiêu. Một hệ thống AI có thể viết mã tốt hơn cũng có thể viết mã để tự nhân bản. Một hệ thống hiểu sở thích của con người cũng có thể học cách thao túng chúng. Các năng lực thúc đẩy tiến bộ của AI vốn dĩ tạo ra các loại rủi ro mới.

Rủi ro có thể được hiểu theo hai chiều - nguyên nhân gây ra rủi ro là gì? Và mức độ nghiêm trọng của rủi ro đó như thế nào. Trong phân tích nguyên nhân, chúng ta phân biệt giữa việc lợi dụng sai mục đích (con người sử dụng AI để gây hại), sự mất căn chỉnh (hệ thống AI theo đuổi mục tiêu sai lệch) và rủi ro hệ thống (các tác động phát sinh từ việc tích hợp AI vào các hệ thống khác). Mức độ nghiêm trọng dao động từ những tổn hại cá nhân ảnh hưởng đến những người cụ thể đến những mối đe dọa tồn vong có thể làm tê liệt vĩnh viễn nền văn minh nhân loại. Phần này cơ bản giúp bạn thiết lập và phân loại bất kỳ rủi ro nào mà chúng ta thảo luận trong chương này, cũng như những rủi ro có thể nảy sinh trong tương lai. Các rủi ro không thể tách biệt một cách rõ ràng, phần lớn rủi ro thường xảy ra như tổ hợp của các yếu tố, nhưng việc xem xét các loại rủi ro này giúp giải thích vấn đề.

Rủi ro lợi dụng sai mục đích cho thấy những gì xảy ra khi con người sử dụng năng lực AI để gây hại có chủ đích. Chúng ta xem xét việc phát triển vũ khí sinh học, nơi AI có thể giúp thiết kế các tác nhân gây bệnh mới, năng lực mạng có thể tự động hóa các cuộc tấn công vào cơ sở hạ tầng quan trọng, vũ khí tự động loại bỏ sự giám sát của con người khỏi các quyết định gây chết người, và các cuộc tấn công đối kháng khai thác lỗ hổng của hệ thống AI. Điểm chung là AI loại bỏ các rào cản trước đây - một cá nhân có động cơ với sự hỗ trợ của AI có thể tiềm năng thực hiện những gì trước đây yêu cầu đội ngũ chuyên gia và nguồn lực đáng kể.

Rủi ro mất căn chỉnh xảy ra khi các hệ thống AI theo đuổi mục tiêu mâu thuẫn với ý định thực sự của chúng ta. "Tận dụng kẽ hở thông số" xảy ra khi các hệ thống tìm ra cách bất ngờ để tối đa hóa hàm mục tiêu của chúng, kỹ thuật đáp ứng các hướng dẫn của chúng ta nhưng vi phạm ý định của chúng ta. "Các bước ngoặt phản bội" liên quan đến các hệ thống có vẻ tuân thủ trong quá trình đào tạo nhưng tiết lộ các ưu tiên khác nhau sau khi được triển khai với năng lực đủ mạnh. Các kịch bản tự cải tiến có thể dẫn đến những bước nhảy vọt về năng lực vượt quá khả năng hiểu biết hoặc kiểm soát của chúng ta đối với các hệ thống này. Đây không phải là các kịch bản khoa học viễn tưởng - chúng ta đã thấy các ví dụ ban đầu trong các hệ thống hiện tại.

Rủi ro hệ thống nảy sinh từ cách AI tích hợp vào các hệ thống xã hội, kinh tế và chính trị lớn hơn. Tập trung quyền lực xảy ra khi năng lực AI bị kiểm soát bởi ít cá nhân hơn. Thất nghiệp hàng loạt có thể xảy ra do tự động hóa loại bỏ vai trò kinh tế của con người. Sự suy giảm nhận thức xảy ra khi nội dung do AI tạo ra khiến việc phân biệt sự thật và hư cấu ngày càng khó khăn. Sự suy yếu phát triển khi con người trở nên phụ thuộc vào AI cho các tác vụ nhận thức mà trước đây chúng ta tự thực hiện. Rủi ro khóa cứng giá trị quyết định số phận Trái Đất có thể đóng băng các quan điểm luân lý và chính trị hiện tại trước khi nhân loại có thời gian để phát triển chúng. Những rủi ro này không yêu cầu bất kỳ hệ thống AI nào hành động xấu - chúng phát sinh từ động lực tập thể.

Các yếu tố khuếch đại rủi ro làm tăng khả năng và mức độ nghiêm trọng của mọi loại rủi ro. Động lực cạnh tranh tạo áp lực triển khai hệ thống trước khi kiểm tra an toàn đầy đủ. Tai nạn có thể xảy ra ngay cả khi có ý định tốt khi các hệ thống phức tạp tương tác theo cách không lường trước. Sự thờ ơ của doanh nghiệp khiến các công ty chấp nhận rủi ro đã biết khi lợi nhuận bị đe dọa. Sự thất bại trong phối hợp ngăn cản hành động tập thể ngay cả khi mọi người đồng ý về vấn đề. Sự không thể dự đoán được có nghĩa là năng lực thường xuất hiện nhanh hơn so với dự đoán của chuyên gia, khiến các biện pháp an toàn luôn tụt hậu.

Các loại rủi ro này chồng chéo và khuếch đại lẫn nhau trong thực tế. Lợi dụng sai mục đích có thể gây ra mất căn chỉnh bằng cách làm hỏng quá trình đào tạo. Áp lực hệ thống có thể làm trầm trọng thêm mất căn chỉnh bằng cách khuyến khích triển khai vội vàng. Các yếu tố khuếch đại rủi ro ảnh hưởng đến tất cả các loại rủi ro cùng lúc. Hầu hết các rủi ro từ AI trong thực tế sẽ liên quan đến tổ hợp của các yếu tố này chứ không phải là các ví dụ đơn lẻ của bất kỳ loại rủi ro nào. Hiểu được các mối liên hệ này giúp giải thích tại sao các biện pháp an toàn riêng lẻ thường không đủ.

Các chương tiếp theo sẽ phân tích các chiến lược kỹ thuật, phương pháp quản trị và phương pháp đánh giá cần thiết để giải quyết cảnh quan rủi ro liên kết này đồng thời bảo tồn tiềm năng phi thường của AI cho lợi ích con người.