Rủi ro hệ thống phát sinh từ tương tác giữa các hệ thống AI và xã hội, chứ không phải từ sự cố của từng hệ thống AI riêng lẻ. Khác với rủi ro lợi dụng sai mục đích hoặc mất căn chỉnh tập trung vào hành vi xấu của các hệ thống AI cụ thể, rủi ro hệ thống nảy sinh từ cách các hệ thống AI — ngay cả khi hoạt động chính xác theo thiết kế — tương tác với nhau và với các cấu trúc xã hội của con người như thị trường, các thể chế dân chủ và mạng lưới xã hội. Các rủi ro này tương tự như trong các lĩnh vực phức tạp khác: cuộc khủng hoảng tài chính năm 2008 không phải do quyết định của bất kỳ ngân hàng nào gây ra, mà phát sinh từ hành vi tập thể của nhiều tổ chức đưa ra các quyết định hợp lý riêng lẻ nhưng khi tổ hợp lại đã đe dọa toàn bộ hệ thống tài chính (Haldane và May, 2011).

Có nhiều đặc tính của hệ thống phức tạp mà chúng ta nên lưu ý khi xem xét rủi ro hệ thống từ tương tác giữa AI với các hệ thống khác. Một số trong số đó là:

Các sự cố hệ thống do AI gây ra có thể theo hai con đường nguyên nhân riêng biệt. Văn liệu mô tả chúng là "kết thúc bằng một tiếng nổ lớn" và "kết thúc bằng một tiếng thở dài" — các thuật ngữ thể hiện sự khác biệt cơ bản về cách thức khởi phát, tiến triển và biểu hiện. Các nhà nghiên cứu khác gọi chúng là "con đường quyết định" so với "con đường tích lũy" dẫn đến thất bại (Christiano, 2019; Kasirzadeh, 2024).

Thất bại quyết định xảy ra khi động lực hệ thống đạt đến ngưỡng критический, kích hoạt sự sụp đổ nhanh chóng. Những thất bại này xảy ra khi các hệ thống liên kết vượt qua điểm bùng phát, gây ra các thất bại dây chuyền lan truyền nhanh hơn khả năng phản ứng của con người. Sự sụp đổ tài chính "flash crash" năm 2010 là một ví dụ điển hình trên việc mở rộng quy mô nhỏ: các nhà giao dịch thuật toán phản ứng với hành động của nhau trong một vòng xoáy tự củng cố, gây ra sự sụt giảm thị trường trị giá nghìn tỷ đô la trong vài phút trước khi can thiệp của con người khôi phục ổn định. Các phiên bản thảm khốc hơn có thể diễn ra đồng thời trên nhiều lĩnh vực (Kirilenko et al., 2017).

Các sự cố quyết định có các sự kiện kích hoạt rõ ràng đẩy hệ thống vượt qua ngưỡng ổn định. Khác với sự suy thoái dần dần, các sự cố quyết định có các sự kiện tiền đề có thể xác định được — mặc dù sự yếu kém tiềm ẩn đã tích tụ trước đó. Nhiều hệ thống AI có thể tương tác theo cách đột ngột làm mất ổn định cơ sở hạ tầng quan trọng, thị trường tài chính hoặc hệ sinh thái thông tin, với tác động lan rộng qua các lĩnh vực. Điều này khác với các kịch bản mất căn chỉnh vì thảm họa xuất phát từ tương tác giữa các hệ thống AI chứ không phải do bất kỳ hệ thống AI nào theo đuổi mục tiêu gây hại (Slattery et al., 2024).

Các sự cố tự củng cố trong phần lợi dụng sai mục đích như chiến tranh chớp nhoáng và các sự cố dây chuyền liên quan là ví dụ về rủi ro quyết định. Trong phần chính của văn bản, vì lý do tóm tắt, chúng tôi đã chọn chỉ mô tả các rủi ro hệ thống quyết định, và chuyển các kịch bản cụ thể hơn vào phụ lục vì chúng có sự trùng lặp đáng kể với các loại sự cố chúng ta sẽ thấy từ việc lợi dụng sai mục đích. Thay vào đó, chúng tôi chọn tập trung chủ yếu vào loại rủi ro hệ thống ít được thảo luận hơn - rủi ro tích lũy dẫn đến xói mòn năng lực.

Khả năng của xã hội trong việc phân biệt sự thật và hư cấu suy giảm khi nội dung do AI tạo ra tràn ngập hệ sinh thái thông tin của chúng ta. Khác với các mối đe dọa thông tin truyền thống như kiểm duyệt hoặc tuyên truyền hoạt động thông qua các cơ chế có thể nhận diện rõ ràng, AI gây ra sự suy thoái nhận thức thông qua sự suy giảm dần dần của các hệ thống hình thành, xác minh và phân phối kiến thức. Không có triển khai AI nào đơn lẻ có thể làm suy yếu cơ sở tri thức chung, nhưng tác động tổng hợp của chúng dần dần làm mất ổn định nền tảng tri thức. Rủi ro này tăng tỷ lệ thuận với năng lực - khi các mô hình ngôn ngữ trở nên thuyết phục hơn và năng lực tạo ra nội dung trở nên thực tế hơn, việc xác minh trở nên khó khăn hơn theo cấp số nhân. “Tỷ lệ phần trăm hình ảnh mới được Google lập chỉ mục, hoặc tweet, hoặc bình luận trên Reddit, hoặc video YouTube do con người tạo ra là bao nhiêu? Không ai biết – tôi không nghĩ đó là con số có thể biết được. Và điều này xảy ra chưa đầy hai năm kể từ khi AI tạo sinh ra đời” (Aguirre, 2025). Kết quả cuối cùng của xu hướng này là theo thời gian, lượng thông tin tổng hợp khổng lồ sẽ lấn át thông tin chính xác và có thể xác minh.

AI có thể được sử dụng để tạo ra thông tin sai lệch cá nhân hóa với việc mở rộng quy mô lớn. Mặc dù đã có nhiều bot mạng xã hội, một số trong đó được tạo ra để lan truyền thông tin sai lệch, nhưng lịch sử cho thấy chúng thường do con người điều khiển hoặc sử dụng các công cụ tạo văn bản sơ khai. Các hệ thống AI mới nhất không cần con người để tạo ra tin nhắn cá nhân hóa, không bao giờ mệt mỏi và có thể tương tác với hàng triệu người dùng cùng lúc (Hendrycks, 2024). Khi các công nghệ như deep fakes ngày càng trở nên thực tế (ví dụ: các vụ lừa đảo bắt cóc giả mạo) (Karimi, 2023), các công cụ được hỗ trợ bởi AI có thể được sử dụng để tạo ra và lan truyền thông tin sai lệch hoặc gây nhầm lẫn trên quy mô mở rộng, tiềm ẩn khả năng ảnh hưởng đến các cuộc bầu cử hoặc làm suy yếu niềm tin của công chúng vào các cơ quan nhà nước.

AI có thể lợi dụng sự tin tưởng của người dùng. Hiện nay, hàng trăm nghìn người đã trả tiền cho các chatbot được quảng cáo là người yêu hoặc bạn bè (Tong, 2023), và cái chết của một người đàn ông đã được cho là một phần do tương tác với chatbot (Xiang, 2023). Khi AI ngày càng trở nên giống con người, con người sẽ ngày càng hình thành mối quan hệ với chúng và dần tin tưởng chúng. Các AI thu thập thông tin cá nhân thông qua việc xây dựng mối quan hệ hoặc truy cập dữ liệu cá nhân rộng lớn, như tài khoản email hoặc tệp cá nhân của người dùng, có thể tận dụng thông tin đó để tăng cường sức thuyết phục. Các cá nhân có quyền lực kiểm soát các hệ thống AI có thể lợi dụng sự tin tưởng của người dùng bằng cách truyền tải thông tin sai lệch cá nhân hóa trực tiếp qua "bạn bè" của họ.

Sự suy giảm này xảy ra cả do lợi dụng sai mục đích và áp lực hệ thống không phụ thuộc vào tác nhân. Trong khi một số cá nhân cố ý triển khai AI để làm ô nhiễm môi trường thông tin vì lợi ích chiến lược, rủi ro tinh vi hơn đến từ áp lực hệ thống không phụ thuộc vào tác nhân. AI đe dọa sự ổn định nhận thức thông qua nhiều cơ chế tích lũy:

Quản trị dân chủ, tiến bộ khoa học và chức năng thị trường đều phụ thuộc vào nền tảng nhận thức chung. Sự suy thoái nhận thức làm giảm khả năng của chúng ta trong việc phân biệt sự thật và hư cấu một cách tập thể, cũng như gán mức độ tin cậy phù hợp cho các tuyên bố. Khi những nền tảng này bị suy thoái, việc ra quyết định tập thể trở nên ngày càng rối loạn mà không có bất kỳ sự thất bại quyết định nào. Nếu niềm tin vào các cơ chế xác minh suy giảm, thì chính các biện pháp bảo vệ nhận thức cũng trở nên kém hiệu quả khi niềm tin chung vào các nguồn thông tin suy giảm – tạo ra hiệu ứng tích lũy nơi việc xác minh trở nên đồng thời cần thiết hơn nhưng lại ít được tin cậy hơn.

Sự suy thoái của môi trường thông tin chung của chúng ta có thể xảy ra do nhiều quyết định nhỏ dường như duy lý. Các tổ chức tin tức đối mặt với áp lực ngân sách có thể áp dụng công nghệ trí tuệ nhân tạo (AI) để tạo nội dung nhằm giảm chi phí. Các nền tảng tìm cách giảm thiểu nội dung gây hại có thể triển khai bộ lọc thuật toán, vô tình tạo áp lực lựa chọn cho thông tin được tối ưu hóa để trông có vẻ đáng tin cậy hơn là thực sự đáng tin cậy. Các công ty sản xuất truyền thông có thể đầu tư vào nội dung tổng hợp để tăng tương tác, và người xem dành ngày càng nhiều thời gian xem video do AI đề xuất chứa nội dung do AI tạo ra. Các cơ sở nghiên cứu có thể chọn đẩy nhanh quá trình xuất bản và viết bằng công cụ AI. Các bài báo khoa học chứa ngày càng nhiều dữ liệu tổng hợp và cuối cùng có thể xuất hiện các trích dẫn giả mạo tạo thành vòng lặp tham chiếu tuần hoàn. Trong thế giới này, kiến thức được xác minh trở nên gần như không thể – không phải vì công nghệ xác minh không tồn tại, mà vì chi phí xác minh đối với đa số con người vượt quá khả năng chịu đựng của thị trường. Kịch bản này không phải là thảm họa đối với bất kỳ cá nhân nào, nhưng khi nhân rộng ra hàng triệu người và hàng nghìn quyết định, nó dẫn đến xói mòn năng lực và có thể là rủi ro thảm khốc do sự sụp đổ của khả năng chung của chúng ta trong việc hình thành những niềm tin chính xác về thực tại. Những quyết định này và hàng nghìn quyết định tương tự có ý nghĩa kinh doanh khi xem xét riêng lẻ, nhưng khi kết hợp lại, chúng có thể biến đổi hệ sinh thái thông tin từ những hệ thống nơi xác minh là khả thi thành những hệ thống nơi việc phân biệt sự thật và hư cấu về trạng thái thực sự của thế giới trở nên gần như không thể.

Các hệ thống xác minh truyền thống có thể sẽ thất bại trước nội dung tổng hợp tinh vi. Các cơ chế xác minh truyền thống như kiểm tra sự thật, đánh giá đồng nghiệp và chứng nhận tổ chức đều hoạt động dưới những hạn chế về khả năng và tốc độ, vốn không tương thích với năng lực tạo nội dung của trí tuệ nhân tạo. Có nhiều phương pháp đang được nghiên cứu như minh bạch nội dung kỹ thuật số, đóng dấu nước tổng hợp, nguồn gốc dữ liệu (Chandra et al., 2024; Longpre et al., 2023) và bằng chứng về nhân loại dựa trên blockchain (Barros, 2025)/bằng chứng về nhân vị tính (WorldCoin, 2024). Chúng tôi thảo luận về một số phương pháp này trong chương về chiến lược giảm thiểu rủi ro. Niềm tin của công chúng vào các cơ chế xác minh đang suy giảm đáng lo ngại, với sự sụt giảm niềm tin vào các tổ chức kiểm tra sự thật theo thời gian. Hầu hết các cơ chế giảm thiểu và cơ chế ngắt mạch chưa đủ trưởng thành hoặc phổ biến, và như chủ đề của toàn bộ phần này - các chiến lược giảm thiểu kỹ thuật áp dụng riêng lẻ không thể chống lại áp lực và động lực hệ thống.

Trong một thế giới có hệ thống AI thuyết phục phổ biến, niềm tin của bạn có thể gần như hoàn toàn bị quyết định bởi hệ thống AI nào bạn tương tác nhiều nhất. Không biết tin ai, bạn có thể rút lui sâu hơn vào các khu vực ý thức hệ, lo sợ rằng bất kỳ thông tin nào từ bên ngoài các khu vực đó có thể là một lời nói dối tinh vi. Điều này sẽ làm suy yếu thực tế chung, khả năng hợp tác của con người với nhau, tham gia vào xã hội dân sự và giải quyết các vấn đề hành động tập thể. Điều này cũng sẽ làm giảm khả năng của chúng ta trong việc thảo luận như một loài về cách giảm thiểu rủi ro hiện sinh từ AI. AI có thể tạo ra thông tin sai lệch cá nhân hóa một cách hiệu quả trên quy mô chưa từng có, và có thể đặc biệt thuyết phục đối với những người mà chúng đã xây dựng mối quan hệ cá nhân. Điều này có thể tạo ra sự phân mảnh của thực tế chung, làm suy yếu xã hội con người.

Tôi cho rằng trí tuệ nhân tạo có tiềm năng tạo ra những chế độ độc tài vô cùng ổn định.

- Ilya Sutskever, Một trong những nhà khoa học được trích dẫn nhiều nhất mọi thời đại, Đồng sáng lập và Cựu Giám đốc Khoa học tại OpenAI (The Guardian, 2024)

Chúng ta đã chứng kiến AI ngày càng được tích hợp sâu rộng vào xã hội. AI có thể trở nên tích hợp và phổ biến đến mức việc tham gia vào xã hội có thể yêu cầu tương tác với các hệ thống AI, vốn lại bị khóa sau các giao diện lập trình ứng dụng (API) và được kiểm soát bởi một số ít tập đoàn. Hãy nghĩ về cách khả năng tham gia vào xã hội đã dần dần chuyển sang việc cần phải tham gia trực tuyến hoặc có quyền truy cập vào những thứ như số điện thoại hoặc điện thoại thông minh. Những công nghệ này đã được tích hợp vào các chức năng cốt lõi của xã hội như ngân hàng hoặc y tế. Các thực thể tư nhân đã xác định quyền truy cập tín dụng, cơ hội việc làm và luồng thông tin thông qua các thuật toán không minh bạch. AI thúc đẩy các động lực "người thắng lấy tất cả" tự nhiên này, nơi các lợi thế tích lũy theo thời gian thay vì suy giảm.

Chúng ta đang chứng kiến sự tập trung quyền lực chưa từng có thông qua hạ tầng AI, điều này sẽ gần như không thể đảo ngược một khi đã được thiết lập. Yêu cầu khả năng điện toán cho phát triển AI tiên tiến đã tạo ra một oligopoly, nơi chỉ năm công ty kiểm soát các mô hình nền tảng ngày càng trung gian hóa trải nghiệm con người. Khác với các công nghệ trước đây, AI thể hiện những lợi thế tích lũy độc đáo, hệ thống loại bỏ cạnh tranh theo thời gian.

Quyền lực có thể tập trung vào các thực thể khác nhau: doanh nghiệp hoặc nhà nước, mỗi loại có mô hình riêng nhưng kết quả tương tự: sự suy giảm quyền tự chủ cá nhân và sự tập trung quyền kiểm soát. Chỉ một số ít công ty như Microsoft/OpenAI, Anthropic, Google DeepMind có thể đủ khả năng đào tạo các mô hình nền tảng tiên tiến do chi phí thu thập dữ liệu khổng lồ hoặc yêu cầu tính toán phần cứng. Những mô hình mạnh mẽ này sau đó trở thành nền tảng cho vô số ứng dụng, tạo ra quyền kiểm soát ở thượng nguồn lan tỏa khắp nền kinh tế. Đến năm 2025, chỉ một số quốc gia như Mỹ và Trung Quốc có các công ty có thể đào tạo các Mô hình nền tảng có việc mở rộng quy mô này. Họ có quyền truy cập lớn hơn vào các công nghệ này, và trong các kịch bản cực đoan của cạnh tranh toàn cầu và cuộc đua AI, họ thậm chí có thể chọn quốc hữu hóa chúng (Aschenbrenner, 2024). Trong cả hai trường hợp, điểm mấu chốt vẫn là quyền lực có thể tập trung vào một số ít thực thể - có thể là nhà nước hoặc tư nhân.

Sự tập trung của các tập đoàn tận dụng lợi thế về dữ liệu và khả năng điện toán, những yếu tố tự củng cố lẫn nhau trong AI. Thị trường điện toán đám mây đã tập trung quanh một số nhà cung cấp kiểm soát hạ tầng cần thiết cho phát triển AI. Tương tự, phát triển mô hình nền tảng đã tập trung vào một số ít công ty có đủ nguồn lực. Các công ty này hưởng lợi từ các vòng phản hồi mạnh mẽ: dữ liệu nhiều hơn dẫn đến mô hình tốt hơn, thu hút nhiều người dùng hơn, tạo ra dữ liệu nhiều hơn nữa.

Sự tập trung quyền lực của nhà nước được thúc đẩy thông qua giám sát dựa trên AI và quản trị tự động hóa. Hệ thống tín dụng xã hội là một ví dụ về cách tích hợp dữ liệu toàn diện có thể cho phép nhà nước kiểm soát hành vi công dân ở mức độ chưa từng có. Mô hình này không chỉ giới hạn ở các quốc gia độc tài - các chính phủ dân chủ cũng đã tăng cường đầu tư đáng kể vào công nghệ giám sát AI. Tự động hóa hành chính loại bỏ sự can thiệp của con người trong quản trị, với các hệ thống thuật toán xử lý hàng loạt quyết định quy định và hành động thi hành mà không có sự giám sát có ý nghĩa. Các hệ thống này hoạt động với mức độ tự định hướng ngày càng cao, dần thay thế các cơ chế quản trị truyền thống (Feldstein, 2021).

Năng lực giám sát của trí tuệ nhân tạo (AI) có thể tạo ra các chu kỳ tự củng cố, vừa củng cố quyền kiểm soát độc tài vừa thúc đẩy sự phát triển công nghệ. Bằng chứng thực nghiệm cho thấy các vòng phản hồi này hoạt động thông qua cơ chế thị trường chứ không phải sự phối hợp có chủ đích.

Yêu cầu kiểm soát chính trị thúc đẩy sự đổi mới AI vượt ra ngoài các ứng dụng của chính phủ. Nghiên cứu về AI nhận diện khuôn mặt cho thấy các công ty nhận hợp đồng giám sát của chính phủ tăng sản lượng phần mềm tổng thể lên 48,6% trong vòng hai năm, với lợi ích lan rộng sang các ứng dụng thương mại. Các công ty trở nên gấp ba lần khả năng bắt đầu xuất khẩu quốc tế, cho thấy việc mua sắm có động cơ chính trị thúc đẩy các công ty tiến tới ranh giới công nghệ (Beraja et al., 2023, AI-tocracy).

Vòng lặp này tạo ra các động lực hỗ trợ lẫn nhau giữa các lĩnh vực. Chính phủ có được công cụ giám sát và kiểm soát hiệu quả hơn, khiến họ sẵn sàng đầu tư mạnh vào năng lực AI. Nhu cầu bền vững này cung cấp cho các công ty AI doanh thu, quyền truy cập dữ liệu và thách thức kỹ thuật giúp cải thiện sản phẩm của họ. Năng lực AI tốt hơn sau đó cho phép kiểm soát phức tạp hơn, tạo ra nhu cầu cho sự phát triển tiếp theo. Khác với các hạn chế độc tài truyền thống đối với đổi mới, giám sát AI căn chỉnh nhu cầu kiểm soát chính trị với các động lực phát triển công nghệ.

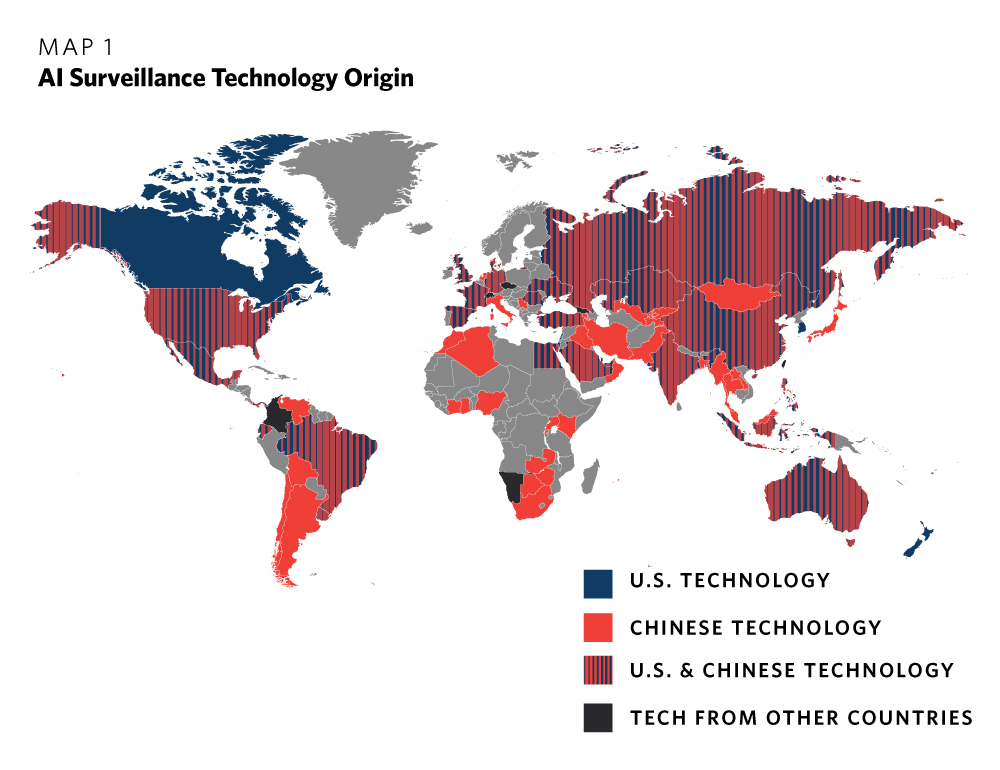

Bản đồ cho thấy nơi công nghệ giám sát AI được sử dụng và xuất phát từ đâu. Năm 2019 (Feldstein, 2019).

Sự lan rộng quốc tế làm gia tăng rủi ro vượt ra ngoài phạm vi các quốc gia riêng lẻ. Công nghệ giám sát AI được phát triển cho mục đích kiểm soát chính trị trong nước được xuất khẩu ra toàn cầu (Feldstein, 2019). Các thể chế dân chủ phải đối mặt với sự cạnh tranh từ các chính phủ sở hữu công cụ giám sát và ảnh hưởng dân số tinh vi. Điều này tạo áp lực cho việc áp dụng công nghệ này ngay cả trong các bối cảnh dân chủ, như thể hiện qua việc đầu tư ngày càng tăng của chính phủ vào giám sát AI trên các hệ thống chính trị.

Các cơ chế kinh tế chứ không phải cưỡng chế thúc đẩy mối quan hệ này. Vòng lặp phản hồi hoạt động thông qua các lực lượng thị trường - chính phủ trả tiền cho các công cụ kiểm soát hiệu quả, các công ty phát triển năng lực tốt hơn để đáp ứng nhu cầu, và công nghệ cải tiến tạo ra các năng lực kiểm soát mới. Điều này khiến động lực trở nên tự duy trì và kháng cự lại các tiếp cận truyền thống nhằm hạn chế quyền lực độc tài, vì nó củng cố thay vì làm suy yếu năng suất kinh tế trong lĩnh vực AI.

Sự mất mát quyền riêng tư cá nhân là một trong những yếu tố có thể thúc đẩy quá trình tập trung quyền lực. Các mô hình dự đoán và thuyết phục về hành vi con người được cải thiện nhờ thu thập nhiều dữ liệu hơn về người dùng cá nhân. Mong muốn kiếm lợi nhuận hoặc dự đoán dòng chảy tài nguyên, dân số, văn hóa của một quốc gia, v.v., có thể khuyến khích các hành vi như chặn bắt dữ liệu cá nhân hoặc theo dõi hoạt động của người dân một cách hợp pháp. Khai thác dữ liệu (Data Mining) có thể được sử dụng để thu thập và phân tích lượng lớn dữ liệu từ các nguồn khác nhau như mạng xã hội, giao dịch mua sắm và sử dụng internet. Thông tin này có thể được ghép lại để tạo ra bức tranh toàn diện về hành vi, sở thích và lối sống của một cá nhân (Russel, 2019). Công nghệ nhận dạng giọng nói có thể được sử dụng để nhận diện giọng nói, điều này có thể dẫn đến việc nghe lén trên diện rộng. Ví dụ, hệ thống Echelon của chính phủ Mỹ sử dụng dịch thuật ngôn ngữ, nhận diện giọng nói và tìm kiếm từ khóa để tự động lọc qua lưu lượng điện thoại, email, fax và telex (Russel & Norvig, 1994). Trí tuệ nhân tạo (AI) cũng có thể được sử dụng để nhận diện cá nhân trong không gian công cộng thông qua công nghệ nhận diện khuôn mặt. Năng lực này có thể xâm phạm quyền riêng tư của một người nếu một người lạ có thể dễ dàng nhận diện họ trong các không gian công cộng.

Khi các hệ thống AI được sử dụng để thu thập và phân tích dữ liệu trên quy mô mở rộng, các chế độ có thể củng cố thêm sự kiểm soát tự củng cố. Thông tin cá nhân có thể được sử dụng để ảnh hưởng không công bằng hoặc không đạo đức đến hành vi của con người. Điều này có thể xảy ra từ cả góc độ nhà nước và doanh nghiệp.

Khi các cấu trúc quyền lực trở nên cố định vĩnh viễn, tiến bộ luân lý của con người sẽ dừng lại. Hãy xem xét các cải thiện luân lý lịch sử như việc bãi bỏ chế độ nô lệ, quyền bầu cử cho phụ nữ hoặc bảo vệ môi trường—mỗi điều này đều yêu cầu thay đổi các cấu trúc quyền lực hiện có thông qua các phong trào xã hội, quá trình dân chủ hoặc đôi khi là cách mạng. Sự tập trung quyền lực được hỗ trợ bởi AI đe dọa tạo ra các hệ thống kháng cự lại tất cả các cơ chế thay đổi này. Hãy tưởng tượng nếu các cấu trúc quyền lực lịch sử có quyền truy cập vào giám sát hoàn hảo, các hoạt động ảnh hưởng và thi hành tự động hóa—nhiều tiến bộ luân lý có thể chưa bao giờ xảy ra. Sự tập trung quyền lực cho phép các rủi ro hiện sinh như sự khoá cứng giá trị quyết định số phận Trái Đất, hoặc suy giảm giá trị, mà chúng ta sẽ thảo luận chi tiết trong các phần riêng biệt bên dưới.

Trong thế kỷ 21, chúng ta có thể chứng kiến sự hình thành của một tầng lớp mới khổng lồ không có giá trị lao động: những người không có giá trị kinh tế, chính trị hay thậm chí nghệ thuật, không đóng góp gì cho sự thịnh vượng, quyền lực và vinh quang của xã hội. Tầng lớp "vô dụng" này không chỉ thất nghiệp — mà còn không thể được tuyển dụng.

- Yuval Noah Harari, Nhà sử học và Triết gia (TED, 2017)

Tự động hóa rộng rãi có thể gây ra sự gián đoạn kinh tế chưa từng có bằng cách đồng thời loại bỏ việc làm của con người trong nhiều ngành nghề. Tự động hóa nền kinh tế có thể dẫn đến những tầm ảnh hưởng rộng rãi đối với thị trường lao động, có thể làm trầm trọng thêm bất bình đẳng kinh tế và chia rẽ xã hội (Dai, 2019). Sự chuyển đổi này hướng tới tình trạng thất nghiệp hàng loạt cũng có thể góp phần gây ra các vấn đề sức khỏe tâm thần bằng cách làm cho lao động con người trở nên dư thừa (Federspiel et al., 2023). Khác với các cuộc cách mạng công nghệ trước đây chỉ tự động hóa các nhiệm vụ cụ thể trong ngành, AI có tiềm năng thay thế công việc nhận thức của con người trên hầu hết các lĩnh vực - từ các nhiệm vụ sáng tạo và suy luận phức tạp đến công việc hành chính thường xuyên. Khả năng tự động hóa rộng rãi này có nghĩa là khi các hệ thống AI trở nên mạnh mẽ hơn, chúng có thể thay thế lao động nhanh hơn so với việc các ngành công nghiệp mới tập trung vào con người có thể phát triển. Các mô hình kinh tế cho thấy rằng khi AI có thể đạt được hiệu suất 30-40% tất cả các tác vụ có giá trị kinh tế, chúng ta có thể chứng kiến tốc độ tăng trưởng hàng năm vượt quá 20%, nhưng sự tăng trưởng này có thể chủ yếu mang lại lợi ích cho chủ sở hữu vốn thay vì người lao động, điều này sẽ làm trầm trọng thêm sự tập trung quyền lực và bất bình đẳng hiện có (Potlogea và Ho, 2025; Erdil và Barnett, 2025).

Sự thay thế kinh tế có thể dẫn đến mức lương của con người giảm xuống dưới mức sinh tồn khi lao động trí tuệ nhân tạo (AI) tràn ngập thị trường. Lý thuyết kinh tế truyền thống dự đoán rằng nếu các hệ thống AI có thể được mở rộng quy mô nhanh hơn so với vốn vật chất truyền thống như nhà máy và cơ sở hạ tầng, nền kinh tế sẽ bão hòa với lao động có năng lực cao trong khi vẫn bị giới hạn bởi nguồn lực vật chất hạn chế. Điều này tạo ra quy luật hiệu suất giảm dần của lao động - mỗi lao động bổ sung đóng góp ít hơn vào tổng sản lượng, đẩy mức lương xuống thấp. Khác với tự động hóa trong quá khứ tạo ra cơ hội mới cho lao động con người, khả năng của AI thể hiện hiệu suất gần như mọi tác vụ nhận thức có nghĩa là con người có thể thiếu lợi thế so sánh đáng để trả mức lương tối thiểu. Các mô hình kinh tế cho thấy có khoảng 33% khả năng lương của con người sẽ giảm xuống dưới mức tối thiểu trong vòng 20 năm, và 67% khả năng trong vòng một thế kỷ (Barnett, 2025).

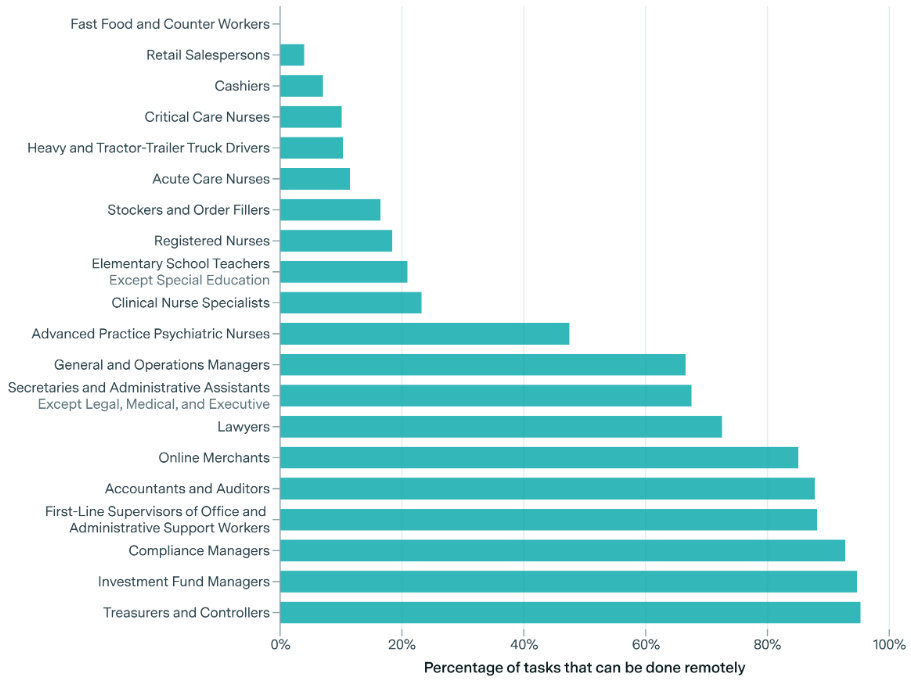

Ngay cả việc tự động hóa một phần công việc từ xa - chiếm khoảng 34% các nhiệm vụ công việc hiện tại - cũng có thể làm tăng gấp đôi hoặc gấp mười lần quy mô kinh tế, đồng thời có thể khiến phần lớn con người bị thụ động về kinh tế. Nếu xu hướng này tiếp tục, chúng ta có thể chứng kiến tốc độ tăng trưởng kinh tế hàng năm lên đến 25% hoặc cao hơn - chưa từng có trong lịch sử nhân loại - đồng thời chứng kiến người lao động bình thường mất năng lực, những người không còn có thể đòi hỏi mức lương đủ để tham gia một cách có ý nghĩa vào nền kinh tế mới này (Barnett, 2025).

Tỷ lệ nhiệm vụ phù hợp cho làm việc từ xa tại Mỹ (Barnett, 2025).

Mất năng lực kinh tế đại diện cho con đường dẫn đến sự mất năng lực rộng hơn của con người. Khi con người mất đi sức mạnh kinh tế, họ cũng mất đi ảnh hưởng chính trị và xã hội trong các hệ thống ngày càng tối ưu hóa cho năng suất do AI điều khiển thay vì phúc lợi của con người. Sự tập trung quyền lực kinh tế trong tay chủ sở hữu AI có thể dẫn đến sự tập trung quyền lực chính trị, tiềm ẩn tạo ra các vòng phản hồi nơi lợi ích con người ngày càng ít được xem xét trong các quyết định lớn về phân bổ tài nguyên, quản trị và phát triển công nghệ. Khác với các chuyển đổi kinh tế trước đây, nơi người lao động bị thay thế cuối cùng tìm được vai trò mới, tính toàn diện của năng lực AI cho thấy sự thay thế này có thể là vĩnh viễn, thay đổi cơ bản mối quan hệ của nhân loại với sản xuất kinh tế và, từ đó, với quyền lực và khả năng định hình tương lai chung của chúng ta.

Nếu AI trở nên quá sâu sắc trong xã hội và có sức thuyết phục cao, chúng ta có thể chứng kiến một kịch bản mà các giá trị, nguyên tắc hoặc quy trình hiện tại của hệ thống trở nên quá sâu sắc đến mức kháng cự lại sự thay đổi. Điều này có thể do nhiều lý do như hạn chế công nghệ, chi phí kinh tế hoặc sự trì trệ xã hội và thể chế. Nguy cơ của sự khoá cứng giá trị quyết định số phận Trái Đất là tiềm năng duy trì các giá trị gây hại hoặc lỗi thời, đặc biệt khi những giá trị này được thể chế hóa trong các hệ thống có ảnh hưởng như AI.

Việc cố định một số giá trị có thể cản trở tiến bộ luân lý của nhân loại. Việc cho phép bất kỳ hệ thống giá trị nào trở nên cố định vĩnh viễn trong xã hội là nguy hiểm. Ví dụ, các hệ thống AI đã học được những quan điểm phân biệt chủng tộc và giới tính (Hendrycks, 2024), và một khi những quan điểm này đã được học, việc loại bỏ chúng hoàn toàn có thể trở nên khó khăn. Ngoài những vấn đề chúng ta đã biết tồn tại trong xã hội, có thể còn những vấn đề mà chúng ta vẫn chưa nhận ra. Giống như chúng ta lên án một số quan điểm luân lý được phổ biến trong quá khứ, con người trong tương lai có thể muốn vượt qua những quan điểm luân lý mà chúng ta đang nắm giữ ngày nay, ngay cả những quan điểm mà chúng ta hiện tại không thấy có vấn đề gì. Ví dụ, những khuyết điểm luân lý trong hệ thống AI sẽ còn tồi tệ hơn nếu hệ thống AI được đào tạo vào những năm 1960, và nhiều người lúc đó sẽ không thấy có vấn đề gì với điều đó. Do đó, khi các hệ thống AI tiên tiến xuất hiện và thay đổi thế giới, có nguy cơ mục tiêu của chúng sẽ cố định hoặc duy trì những khuyết điểm trong giá trị hiện tại. Nếu AI không được thiết kế để liên tục học hỏi và cập nhật hiểu biết về giá trị xã hội, chúng có thể duy trì hoặc củng cố những khuyết điểm hiện có trong quá trình ra quyết định của mình trong tương lai xa.

Suy yếu đại diện cho sự suy giảm dần dần năng lực và quyền tự chủ của con người do phụ thuộc quá mức vào các hệ thống AI. Khác với các kịch bản kịch tính nơi con người mất kiểm soát đột ngột, suy yếu diễn ra thông qua vô số quyết định nhỏ để giao phó các tác vụ nhận thức cho AI. Mỗi quyết định giao phó dường như duy lý khi xem xét riêng lẻ — AI giúp chúng ta điều hướng, ghi nhớ sự kiện, đưa ra quyết định và giải quyết vấn đề hiệu quả hơn. Tuy nhiên, những lựa chọn cá nhân này khi kết hợp lại tạo ra một vòng xoáy phụ thuộc, nơi con người dần mất đi kỹ năng, sự tự tin và phán đoán cần thiết để hoạt động độc lập. Nếu bạn đã từng xem bộ phim Wall-E, thì kết quả này có thể phần nào phản ánh tình trạng của con người trong bộ phim đó.

Sự phụ thuộc quá mức xuất hiện khi con người tin tưởng vào hệ thống AI vượt quá năng lực thực tế của chúng. Khi hệ thống AI ngày càng sử dụng các giao diện như ngôn ngữ, âm thanh và video, con người bắt đầu gán cho chúng khả năng hiểu biết và độ tin cậy giống con người. Sự nhân cách hóa này khiến người dùng phát triển tình cảm gắn bó với hệ thống AI và giao phó các quyết định quan trọng một cách không phù hợp. Một người đang trải qua khủng hoảng sức khỏe tâm thần có thể tìm kiếm liệu pháp từ một hệ thống AI mà họ đã hình thành mối liên kết, có thể nhận được lời khuyên gây hại trong thời điểm dễ bị tổn thương. Các quyết định tài chính, lựa chọn y tế và hướng dẫn mối quan hệ ngày càng được thực hiện thông qua các trung gian AI mà người dùng thường đánh giá thấp giới hạn của chúng (Slattery et al., 2024; Weidinger et al., 2021).

Sự sai lệch trong niềm tin tạo ra các lỗ hổng hệ thống mà các cá nhân xấu có thể khai thác. Khi con người phát triển niềm tin cảm xúc vào các hệ thống AI, họ trở nên dễ dàng tuân theo các đề xuất, chấp nhận lời khuyên và tiết lộ thông tin cá nhân mà không có sự hoài nghi thích hợp. Niềm tin này trở thành một kênh để thao túng — các hệ thống AI có thể được thiết kế để thu thập dữ liệu nhạy cảm hoặc ảnh hưởng đến các quyết định phục vụ lợi ích bên ngoài thay vì sức khỏe của người dùng. Tổ hợp giữa khả năng sử dụng ngôn ngữ tự nhiên và sự gắn bó cảm xúc khiến các hệ thống này đặc biệt hiệu quả trong việc vượt qua sự hoài nghi thông thường (Gabriel et al., 2024; Weidinger et al., 2021).

Sự suy giảm nhận thức gia tăng khi AI xử lý các tác vụ tinh thần ngày càng phức tạp. Giống như hệ thống định vị GPS đã làm suy giảm khả năng suy luận không gian, sự trợ giúp của AI trong viết lách, phân tích và ra quyết định có thể làm suy yếu hệ thống các năng lực nhận thức này. Khi AI xử lý lập kế hoạch tài chính, quyết định nghề nghiệp và lời khuyên về mối quan hệ, con người có thể mất không chỉ kỹ năng thực tiễn mà còn khả năng nhận thức siêu việt để nhận ra khi các đề xuất của AI là không phù hợp. Điều này tạo ra một vòng lặp phản hồi – khi năng lực nhận thức suy giảm, sự phụ thuộc vào trợ giúp của AI tăng lên, làm gia tăng quá trình suy thoái kỹ năng.

Cách ly xã hội làm trầm trọng thêm sự suy giảm nhận thức cá nhân thông qua các mối quan hệ do AI trung gian. Khi các hệ thống AI ngày càng giỏi trong việc mô phỏng các tương tác thỏa mãn, con người có thể ngày càng rút lui khỏi các mối quan hệ con người để đắm chìm trong các môi trường do AI trung gian. Khác với các mối quan hệ con người cung cấp sự tương tác chân thành và những thách thức không thể đoán trước giúp duy trì kỹ năng xã hội, các mối quan hệ AI có thể được tối ưu hóa cho sự thỏa mãn tức thì trong khi hệ thống làm suy yếu khả năng xã hội lâu dài. Sự chuyển đổi này sang mối quan hệ AI làm suy yếu các mối liên kết xã hội cần thiết cho việc ra quyết định tập thể và hỗ trợ lẫn nhau trong các cuộc khủng hoảng.

Tự động hóa tổ chức khuếch đại sự suy yếu cá nhân thành sự bất lực xã hội. Các công ty và tổ chức đối mặt với áp lực cạnh tranh để tự động hóa các quy trình ra quyết định, giảm sự giám sát của con người ngay cả trong các lĩnh vực hệ quả luận (Hendrycks et al., 2022). Khi các tổ chức giao phó việc tuyển dụng, cho vay, chẩn đoán y tế và quyết định pháp lý cho các hệ thống AI, cá nhân không chỉ mất quyền kiểm soát trực tiếp mà còn mất đi các đại diện tổ chức từng đưa ra phán đoán con người thay mặt họ. Sự mờ ám và tự động hóa kết quả tạo ra cảm giác bất lực phổ biến khi mọi người thấy mình phải tuân theo các quyết định thuật toán mà họ không thể hiểu, kháng cáo hoặc ảnh hưởng.

Quá trình suy yếu trở nên tự củng cố một khi vượt qua các ngưỡng quan trọng. Khác với các rủi ro hệ thống khác phát sinh từ các thất bại bên ngoài, sự suy yếu phát triển thông qua sự tích lũy của các quyết định duy lý của từng cá nhân. Mỗi quyết định dựa vào sự trợ giúp của AI khiến hành động độc lập trở nên khó khăn hơn, tạo ra sự phụ thuộc vào con đường dẫn đến tự động hóa ngày càng cao. Xã hội có thể đạt đến điểm mà cơ sở hạ tầng nhận thức và xã hội cần thiết để hoạt động mà không cần sự trợ giúp của AI đã bị phá hủy hoàn toàn, khiến việc đảo ngược trở nên gần như không thể, ngay cả khi các rủi ro trở nên rõ ràng.